Nota

Este comando está disponible con el Módulo de análisis predictivo. Haga clic aquí para obtener más información sobre cómo activar el módulo.

Un equipo de investigadores recopila y publica información detallada acerca de los factores que afectan las enfermedades cardíacas. Las variables incluyen edad, sexo, niveles de colesterol, frecuencia cardíaca máxima, y más. Este ejemplo se basa en un conjunto de datos públicos que proporciona información detallada sobre las enfermedades cardíacas. Los datos originales son de archive.ics.uci.edu.

Después de la exploración inicial con Clasificación CART® para identificar los predictores importantes, los investigadores utilizan Clasificación TreeNet® y Clasificación Random Forests® para crear modelos más intensivos a partir del mismo conjunto de datos. Los investigadores comparan la tabla de resumen del modelo y la gráfica ROC de los resultados para evaluar qué modelo proporciona un mejor resultado de predicción. Para los resultados de los otros análisis, vaya a Ejemplo de Clasificación CART® y a Ejemplo de Ajustar modelo con Clasificación TreeNet®.

- Abra los datos de muestra, EnfermedadesDelCorazonBinario.MWX.

- Elija .

- En la lista desplegable, seleccione Respuesta binaria.

- En Respuesta, escriba Enfermedad cardíaca.

- En Response event, seleccione Sí para indicar que se ha identificado una enfermedad cardíaca en el paciente.

- En Predictores continuos, ingrese Edad, Descansar la presión arterial, Colesterol, Frecuencia cardíaca máxima y Old Peak.

- En Predictores categóricos, ingrese Sexo, Tipo de dolor torácico, Azúcar en la sangre en ayunas, Rest ECG, Ejercicio Angina, Pendiente, Buques principales y Thal.

- Haga clic en Aceptar.

Interpretar los resultados

Para este análisis, el número de observaciones es 303. Cada una de las 300 muestras de bootstrap utiliza las 303 observaciones para crear un árbol. Los datos incluyen una división adecuada de no eventos y eventos.

Método

| Validación del modelo | Validación con datos de "out-of-bag" |

|---|---|

| Número de muestras de bootstrap | 300 |

| Tamaño de la muestra | Igual que el tamaño de los datos de entrenamiento de 303 |

| Número de predictores seleccionados para la división de nodos | Raíz cuadrada del número total de predictores = 3 |

| Tamaño mínimo del nodo interno | 2 |

| Filas utilizadas | 303 |

Información de respuesta binaria

| Variable | Clase | Conteo | % |

|---|---|---|---|

| Enfermedad cardíaca | Sí (Evento) | 139 | 45.87 |

| No | 164 | 54.13 | |

| Todo | 303 | 100.00 |

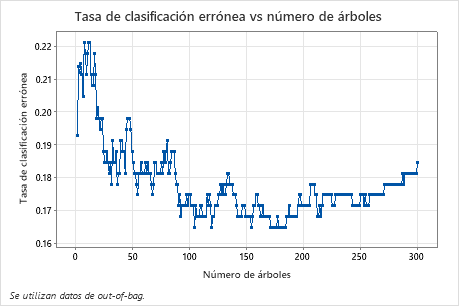

La gráfica Tasa de clasificaciones erróneas vs. número de árboles muestra toda la curva sobre el número de árboles cultivados. La tasa de clasificaciones erróneas es aproximadamente 0.18.

Resumen del modelo

| Total de predictores | 13 |

|---|---|

| Predictores importantes | 13 |

| Estadísticas | Out-of-Bag |

|---|---|

| Logverosimilitud promedio | 0.4004 |

| Área bajo la curva ROC | 0.9028 |

| IC de 95% | (0.8693, 0.9363) |

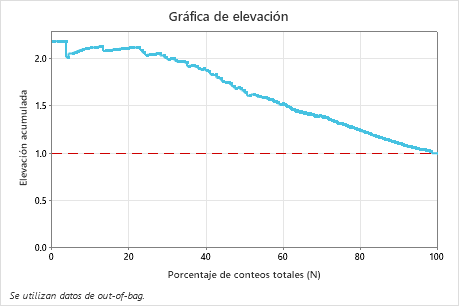

| Elevación | 2.1079 |

| Tasa de clasificación errónea | 0.1848 |

Resumen del modelo

| Total de predictores | 13 |

|---|---|

| Predictores importantes | 13 |

| Número de árboles cultivados | 500 |

| Número óptimo de árboles | 351 |

| Estadísticas | Entrenamiento | Prueba |

|---|---|---|

| Logverosimilitud promedio | 0.2341 | 0.3865 |

| Área bajo la curva ROC | 0.9825 | 0.9089 |

| IC de 95% | (0.9706, 0.9945) | (0.8757, 0.9421) |

| Elevación | 2.1799 | 2.1087 |

| Tasa de clasificación errónea | 0.0759 | 0.1750 |

La tabla Resumen del modelo muestra que la logverosimilitud negativa promedio es 0.3994. Estas estadísticas indican un modelo similar al que crea Minitab TreeNet® al cultivar 500 árboles. Además, las tasas de clasificaciones erróneas son similares.

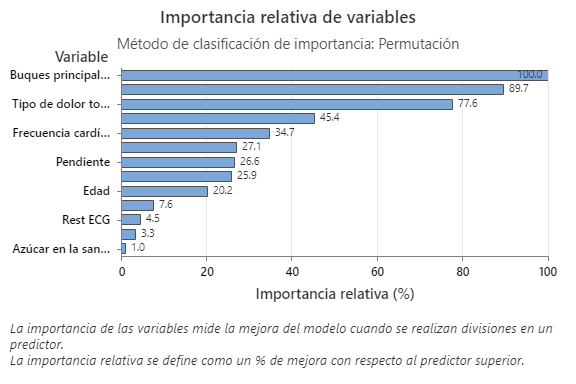

La gráfica Importancia relativa de las variables presenta los predictores en el orden de su efecto en la mejora del modelo cuando se realizan divisiones en un predictor sobre la secuencia de árboles. La variable predictora más importante es Grandes vasos. Si la contribución de la variable predictora más importante, Grandes vasos, es 100%, entonces la siguiente variable importante, Thal, tiene una contribución de 89.7%. Esto significa que Thal es 89.7% tan importante como Grandes vasos en este modelo de clasificación.

Matriz de confusión

| Clase de predicción (Out-of-Bag) | ||||

|---|---|---|---|---|

| Clase real | Conteo | Sí | No | % Correcto |

| Sí (Evento) | 139 | 109 | 30 | 78.42 |

| No | 164 | 26 | 138 | 84.15 |

| Todo | 303 | 135 | 168 | 81.52 |

| Estadísticas | Out-of-Bag (%) |

|---|---|

| Tasa de positivos verdaderos (sensibilidad o potencia) | 78.42 |

| Tasa de positivos falsos (error tipo I) | 15.85 |

| Tasa de negativos falsos (error tipo II) | 21.58 |

| Tasa de negativos verdaderos (especificidad) | 84.15 |

La matriz de confusión muestra qué tan efectivo es el modelo para separar las clases correctamente. En este ejemplo, la probabilidad de que un evento sea pronosticado correctamente es 78.42%. La probabilidad de que un no evento se pronosticado correctamente es 84.15%.

Clasificación errónea

| Out-of-Bag | |||

|---|---|---|---|

| Conteo | Clasificado erróneamente | % Error | |

| Clase real | |||

| Sí (Evento) | 139 | 30 | 21.58 |

| No | 164 | 26 | 15.85 |

| Todo | 303 | 56 | 18.48 |

La tasa de clasificaciones erróneas ayuda a indicar si el modelo predecirá nuevas observaciones con exactitud. Para la predicción de eventos, el error de clasificaciones erróneas es 21.58%. Para la predicción de no eventos, el error de clasificaciones erróneas es 15.85% y, en general, el error de clasificaciones erróneas es 18.48%.

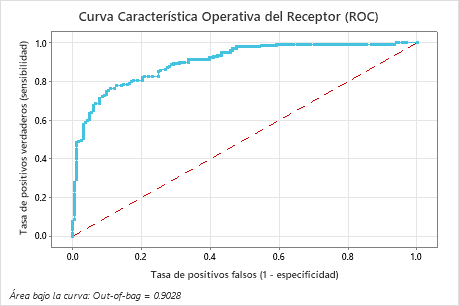

El área bajo la curva ROC para estos datos es aproximadamente 0.9028, lo que indica una ligera mejora con respecto al modelo Clasificación CART®. El modelo Clasificación TreeNet® tiene una prueba AUROC de 0.9089, por lo que estos dos métodos proporcionan resultados similares.

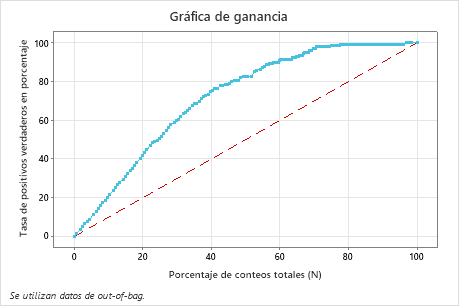

En este ejemplo, la gráfica de ganancia muestra un fuerte aumento por encima de la línea de referencia y, luego, un aplanamiento. En este caso, aproximadamente 40% de los datos representan aproximadamente 78% de los verdaderos positivos. Esta diferencia es la ganancia adicional que se obtiene al utilizar el modelo.

En este ejemplo, la gráfica de elevación muestra un gran aumento por encima de la línea de referencia que disminuye gradualmente.