Revisión general

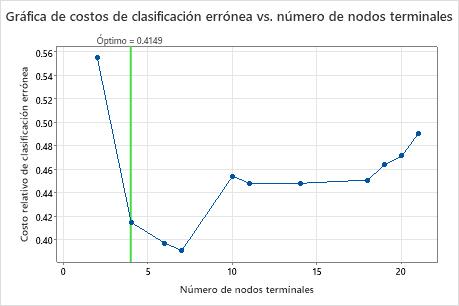

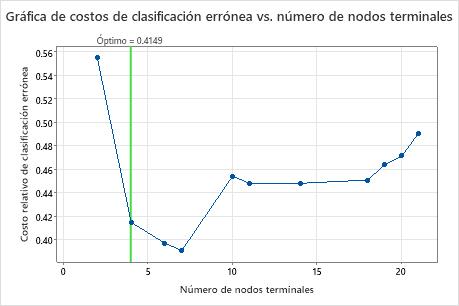

- El árbol óptimo forma parte de un patrón en el que los costos de clasificación errónea disminuyen. Uno o más árboles que tienen algunos nodos más forman parte del mismo patrón. Normalmente, desea realizar predicciones desde un árbol con la mayor exactitud de predicción posible. Si el árbol es lo suficientemente simple, también puede usarlo para comprender cómo afecta cada variable predictora a los valores de respuesta.

- El árbol óptimo forma parte de un patrón en el que los costos de clasificación errónea son relativamente planos. Uno o más árboles con estadísticas de resumen del modelo similares tienen muchos menos nodos que el árbol óptimo. Normalmente, un árbol con menos nodos terminales proporciona una imagen más clara de cómo cada variable predictora afecta a los valores de respuesta. Un árbol más pequeño también facilita la identificación de algunos grupos objetivo para estudios posteriores. Si la diferencia en la exactitud de predicción para un árbol más pequeño es insignificante, también puede utilizar el árbol más pequeño para evaluar las relaciones entre la respuesta y las variables predictoras

- El analista elige un árbol más pequeño que proporciona una vista más clara de las variables más importantes.

- El análisis elige un árbol porque las divisiones están en variables que son más fáciles de medir que las variables de otro árbol.

- El analista elige un árbol porque un nodo terminal determinado es de interés.

Realizar el análisis

Haga clic en Seleccionar árbol alternativo en la salida. Se abre un cuadro de diálogo que muestra la gráfica, un diagrama de árbol y una tabla que resume el árbol o el nodo seleccionado.

Seleccionar un árbol alternativo

- Haga clic en un punto de la gráfica.

- Haga clic en los botones de flecha debajo de la tabla de resumen del modelo para seleccionar un árbol que sea un árbol más grande o más pequeño que la selección actual.

- Haga clic en un botón para seleccionar un árbol que sea una opción común. Cuando el análisis no utiliza validación, no se aplican los botones que hacen referencia al error estándar.

- Costo mín.

- Seleccione el árbol con el costo mínimo de clasificación errónea

- Dentro 1 EE de Cost Mín

- Seleccione el árbol más pequeño que tenga un costo de clasificación errónea dentro de un error estándar del costo mínimo.

- Dentro 2 EE de Cost Mín

- Seleccione el árbol más pequeño que tenga un costo de clasificación errónea dentro de 2 errores estándares del costo mínimo.

- Mejor ROC

- Seleccione el árbol con el área más grande bajo la curva ROC.

Investigar el árbol y los nodos individuales

- Resalte los 5 nodos con la mayor pureza. Estos nodos son los nodos óptimos.

- Cambiar entre Árbol detallado y Árbol con división de nodos. La Árbol con división de nodos es útil cuando tiene un árbol grande y desea ver solo qué variables dividen los nodos.

- Ampliar y reducir el árbol.

Puede seleccionar nodos individuales en el árbol para ver detalles sobre el nodo en la tabla. Los detalles incluyen conteos de clases individuales y el conteo total. Los detalles también incluyen las reglas para llegar al nodo. Haga clic en Copiar reglas en el portapapeles para que pueda pegar las reglas en otro lugar.

Para volver a seleccionar todo el árbol, haga clic en cualquier parte del diagrama que no sea un nodo individual.

Crear un nuevo árbol

Haga clic en Crear árbol para crear y almacenar los resultados de un árbol alternativo que elija. Las selecciones para los resultados y el almacenamiento son las mismas que para el árbol original. Las gráficas y tablas para el árbol alternativo se encuentran en una nueva ficha de salida. Las columnas almacenadas están en la hoja de trabajo con los datos originales.