Para obtener más detalles sobre los métodos de validación de modelos y los parámetros de complejidad, véase Breiman, Friedman, Olshen y Stone (1984) 1.

Métodos de validación del modelo

Los estadísticos de resumen del modelo, como el área bajo la curva ROC, tienden a ser optimistas cuando se calculan con los mismos datos que se usan para ajustar un modelo. Los métodos de validación del modelo dejan una parte de los datos fuera del proceso de ajuste del modelo y, a continuación, calculan estadísticos que evalúan el rendimiento del modelo con los datos omitidos. Las técnicas de validación de modelos proporcionan una mejor estimación del rendimiento de los modelos en datos nuevos. El costo de clasificación errónea de los datos omitidos es el criterio para la selección del árbol óptimo. Minitab ofrece dos métodos de validación para técnicas de analítica predictiva validación cruzada de k pliegues y validación con un conjunto de datos de prueba independiente.

El árbol óptimo con validación cruzada con k-fold

La validación cruzada de K pliegues es el método predeterminado en Minitab cuando los datos tienen 5000 casos o menos. Con este método, Minitab divide los datos en K subconjuntos. Los subconjuntos se denominan pliegues. La validación cruzada de k pliegues tiende a funcionar bien con conjuntos de datos que son relativamente pequeños en comparación con los conjuntos de datos que funcionan bien con un conjunto de datos de prueba. Dado que el proceso se repite K veces, la validación cruzada suele ser más lenta que la validación con un conjunto de datos de prueba.

Procedimiento de validación cruzada de k pliegues

Para completar la validación cruzada de k pliegues, Minitab produce 1 + k secuencias de subárboles. Una secuencia de subárboles, la secuencia maestra, utiliza todo el conjunto de datos de entrenamiento. Las otras k secuencias son para los k pliegues. Para cada pliegue, la secuencia de subárboles utiliza (k – 1)/k de los casos del conjunto de datos de entrenamiento.

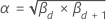

Cada secuencia consta de una secuencia finita de subárboles anidados. Cada pliegue tiene una secuencia finita de parámetros de complejidad αd ≤ α ≤ αd + 1 que corresponden al árbol más grande y a los subárboles de la secuencia. La secuencia que se encuentra para el conjunto de datos completo tiene parámetros de complejidad βd ≤ β ≤ βd + 1donde d = 0, 1, ... D, donde β0 es el parámetro para el árbol más grande de la secuencia.

Para cualquier subárbol de la secuencia maestra, supongamos que los parámetros de complejidad correspondientes son βd y βd + 1. Sea  . Luego, Minitab utiliza este alfa para encontrar los k subárboles correspondientes de los k pliegues. Para cada pliegue, calcule el costo de clasificación errónea para el subárbol utilizando la fórmula en Métodos y fórmulas para el resumen del modelo en Clasificación CART®. El costo promedio de clasificación errónea en k pliegues es el costo de clasificación errónea estimado para el subárbol en la secuencia maestra. Repita el cálculo del costo de clasificación errónea estimado para cada subárbol de la secuencia maestra. El procedimiento identifica el subárbol con el costo promedio mínimo de clasificación errónea. El árbol con el costo de clasificación errónea mínimo o el árbol más pequeño con un costo de clasificación errónea dentro de un múltiplo de errores estándar del costo de clasificación errónea se convierte en el árbol óptimo en los resultados.

. Luego, Minitab utiliza este alfa para encontrar los k subárboles correspondientes de los k pliegues. Para cada pliegue, calcule el costo de clasificación errónea para el subárbol utilizando la fórmula en Métodos y fórmulas para el resumen del modelo en Clasificación CART®. El costo promedio de clasificación errónea en k pliegues es el costo de clasificación errónea estimado para el subárbol en la secuencia maestra. Repita el cálculo del costo de clasificación errónea estimado para cada subárbol de la secuencia maestra. El procedimiento identifica el subárbol con el costo promedio mínimo de clasificación errónea. El árbol con el costo de clasificación errónea mínimo o el árbol más pequeño con un costo de clasificación errónea dentro de un múltiplo de errores estándar del costo de clasificación errónea se convierte en el árbol óptimo en los resultados.

El árbol óptimo con un conjunto de datos de prueba independiente

En la validación con un conjunto de datos de prueba, una parte de los datos se reserva para la validación. Esta parte de los datos es el conjunto de datos de entrenamiento. En primer lugar, Minitab adapta todos los árboles con el conjunto de datos de entrenamiento. Luego, Minitab calcula el cuadrado medio del error o la desviación absoluta para el conjunto de datos de prueba para cada árbol. El árbol con el valor óptimo del criterio para el conjunto de datos de prueba es el árbol óptimo.

El árbol óptimo sin validación

Sin ninguna validación, Minitab utiliza todo el conjunto de datos para hacer crecer la secuencia de subárboles. El subárbol con más nodos terminales tiene el costo mínimo de clasificación errónea y es el árbol óptimo.