En este tema

- Paso 1: Evaluar la concordancia del evaluador de forma visual

- Paso 2: Evaluar la consistencia de las respuestas para cada evaluador

- Paso 3: Evaluar lo correcto de las respuestas para cada evaluador

- Paso 4: Evaluar la consistencia de las respuestas entre los evaluadores

- Paso 5: Evaluar lo correcto de las respuestas para todos los evaluadores

Paso 1: Evaluar la concordancia del evaluador de forma visual

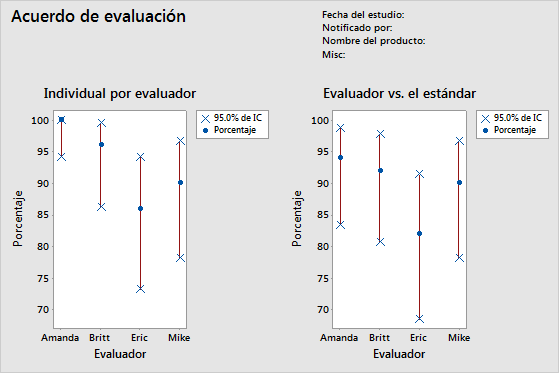

Para determinar la consistencia de las clasificaciones de cada evaluador, examine la gráfica Por evaluador. Compare el porcentaje de coincidencia (círculo azul) con el intervalo de confianza del porcentaje de coincidencia (línea roja) para cada evaluador.

Para determinar lo correcto de las clasificaciones de cada evaluador, examine la gráfica Evaluador vs. el estándar. Compare el porcentaje de coincidencia (círculo azul) con el intervalo de confianza del porcentaje de coincidencia (línea roja) para cada evaluador.

Nota

Minitab solo muestra la gráfica Por evaluador cuando se tienen múltiples ensayos.

Esta gráfica Por evaluador indica que Amanda tiene las clasificaciones más consistentes y Eric tiene las clasificaciones menos consistentes. La gráfica Evaluador vs. el estándar indica que Amanda tiene las calificaciones más correctas y Eric tiene las clasificaciones menos correctas.

Paso 2: Evaluar la consistencia de las respuestas para cada evaluador

Para determinar la consistencia de las clasificaciones de cada evaluador, examine los estadísticos kappa de la tabla Por evaluador. Cuando las clasificaciones sean ordinales, también debería evaluar los coeficientes de concordancia de Kendall. Minitab muestra la tabla Por evaluador cuando cada evaluador clasifica un elemento más de una vez.

Utilice los estadísticos kappa para evaluar el grado de concordancia de las clasificaciones nominales u ordinales realizadas por múltiples evaluadores cuando los evaluadores evalúen las mismas muestras.

- Cuando Kappa = 1, existe concordancia perfecta.

- Cuando Kappa = 0, la concordancia es la misma que se esperaría en virtud de las probabilidades.

- Cuando Kappa < 0, la concordancia es más débil que lo esperado en virtud de las probabilidades; esto casi nunca sucede.

El grupo AIAG sugiere que un valor de kappa de al menos 0.75 indica una concordancia adecuada. Sin embargo, se prefieren valores de kappa más grandes, como 0.90.

Cuando tenga clasificaciones ordinales, tales como clasificaciones de la gravedad de los defectos en una escala del 1 al 5, los coeficientes de Kendall, que consideran el orden, suelen ser estadísticos más apropiados para evaluar la asociación que el uso de kappa solamente.

Nota

Recuerde que la tabla Por evaluador indica si las clasificaciones de los evaluadores son consistentes, pero no si las clasificaciones concuerdan con los valores de referencia. Las clasificaciones consistentes no necesariamente son clasificaciones correctas.

Acuerdo de evaluación

| Evaluador | No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100.00 | (94.18, 100.00) |

| Britt | 50 | 48 | 96.00 | (86.29, 99.51) |

| Eric | 50 | 43 | 86.00 | (73.26, 94.18) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Estadísticos Kappa de Fleiss

| Evaluador | Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 3 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 1.00000 | 0.071052 | 14.0741 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.89605 | 0.141421 | 6.3360 | 0.0000 | |

| 3 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 0.94965 | 0.071401 | 13.3002 | 0.0000 | |

| Eric | 1 | 0.83060 | 0.141421 | 5.8733 | 0.0000 |

| 2 | 0.84000 | 0.141421 | 5.9397 | 0.0000 | |

| 3 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 4 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 0.82354 | 0.071591 | 11.5034 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.83060 | 0.141421 | 5.8733 | 0.0000 | |

| 3 | 0.81917 | 0.141421 | 5.7924 | 0.0000 | |

| 4 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 5 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| General | 0.87472 | 0.070945 | 12.3295 | 0.0000 |

Coeficiente de concordancia de Kendall

| Evaluador | Coef | Chi-cuad. | GL | P |

|---|---|---|---|---|

| Amanda | 1.00000 | 98.0000 | 49 | 0.0000 |

| Britt | 0.99448 | 97.4587 | 49 | 0.0000 |

| Eric | 0.98446 | 96.4769 | 49 | 0.0001 |

| Mike | 0.98700 | 96.7256 | 49 | 0.0001 |

Resultados clave: Kappa, coeficiente de concordancia de Kendall

Muchos de los valores de kappa son iguales a 1, lo cual indica una concordancia perfecta del evaluador entre los ensayos. Algunos de los valores de kappa de Eric están cerca de 0.70. Convendría investigar por qué las clasificaciones de Eric para esas muestras fueron inconsistentes. Como los datos son ordinales, Minitab proporciona el coeficiente de los valores de concordancia de Kendall. Todos estos valores son mayores que 0.98, lo que indica una fuerte asociación entre las clasificaciones de cada evaluador.

Paso 3: Evaluar lo correcto de las respuestas para cada evaluador

Para determinar lo correcto de las clasificaciones de cada evaluador, examine los estadísticos kappa de la tabla Cada evaluador vs. el estándar. Cuando las clasificaciones sean ordinales, también debería evaluar los coeficientes de correlación de Kendall. Minitab muestra la tabla Cada evaluador vs. el estándar cuando usted especifica un valor de referencia para cada muestra.

Utilice los estadísticos kappa para evaluar el grado de concordancia de las clasificaciones nominales u ordinales realizadas por múltiples evaluadores cuando los evaluadores evalúen las mismas muestras.

- Cuando Kappa = 1, existe concordancia perfecta.

- Cuando Kappa = 0, la concordancia es la misma que se esperaría en virtud de las probabilidades.

- Cuando Kappa < 0, la concordancia es más débil que lo esperado en virtud de las probabilidades; esto casi nunca sucede.

El grupo AIAG sugiere que un valor de kappa de al menos 0.75 indica una concordancia adecuada. Sin embargo, se prefieren valores de kappa más grandes, como 0.90.

Cuando tenga clasificaciones ordinales, tales como clasificaciones de la gravedad de los defectos en una escala del 1 al 5, los coeficientes de Kendall, que consideran el orden, suelen ser estadísticos más apropiados para evaluar la asociación que el uso de kappa solamente.

Acuerdo de evaluación

| Evaluador | No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94.00 | (83.45, 98.75) |

| Britt | 50 | 46 | 92.00 | (80.77, 97.78) |

| Eric | 50 | 41 | 82.00 | (68.56, 91.42) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Estadísticos Kappa de Fleiss

| Evaluador | Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83060 | 0.100000 | 8.3060 | 0.0000 | |

| 3 | 0.81917 | 0.100000 | 8.1917 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.92476 | 0.050257 | 18.4006 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83838 | 0.100000 | 8.3838 | 0.0000 | |

| 3 | 0.80725 | 0.100000 | 8.0725 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.92462 | 0.050396 | 18.3473 | 0.0000 | |

| Eric | 1 | 0.91159 | 0.100000 | 9.1159 | 0.0000 |

| 2 | 0.81035 | 0.100000 | 8.1035 | 0.0000 | |

| 3 | 0.72619 | 0.100000 | 7.2619 | 0.0000 | |

| 4 | 0.84919 | 0.100000 | 8.4919 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.86163 | 0.050500 | 17.0622 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.91694 | 0.100000 | 9.1694 | 0.0000 | |

| 3 | 0.90736 | 0.100000 | 9.0736 | 0.0000 | |

| 4 | 0.92913 | 0.100000 | 9.2913 | 0.0000 | |

| 5 | 0.93502 | 0.100000 | 9.3502 | 0.0000 | |

| General | 0.93732 | 0.050211 | 18.6674 | 0.0000 |

Coeficiente de correlación de Kendall

| Evaluador | Coef | EE del Coef. | Z | P |

|---|---|---|---|---|

| Amanda | 0.967386 | 0.0690066 | 14.0128 | 0.0000 |

| Britt | 0.967835 | 0.0690066 | 14.0193 | 0.0000 |

| Eric | 0.951863 | 0.0690066 | 13.7879 | 0.0000 |

| Mike | 0.975168 | 0.0690066 | 14.1256 | 0.0000 |

Resultados clave: Kappa, coeficiente de correlación de Kendall

La mayoría de los valores de kappa es mayor que 0.80, lo cual indica una concordancia adecuada entre cada evaluador y el estándar. Algunos de los valores de kappa están cerca de 0.70, lo cual indica que pudiera ser necesario investigar más a fondo ciertas muestras o a ciertos evaluadores. Como los datos son ordinales, Minitab proporciona los coeficientes de correlación de Kendall. Estos valores varían de 0.951863 y 0.975168, lo que indica una fuerte asociación entre las clasificaciones y los valores estándar.

Paso 4: Evaluar la consistencia de las respuestas entre los evaluadores

Para determinar la consistencia entre las clasificaciones de los evaluadores, examine los estadísticos kappa de la tabla Entre evaluadores. Cuando las clasificaciones sean ordinales, también debería evaluar el coeficiente de concordancia de Kendall.

Utilice los estadísticos kappa para evaluar el grado de concordancia de las clasificaciones nominales u ordinales realizadas por múltiples evaluadores cuando los evaluadores evalúen las mismas muestras.

- Cuando Kappa = 1, existe concordancia perfecta.

- Cuando Kappa = 0, la concordancia es la misma que se esperaría en virtud de las probabilidades.

- Cuando Kappa < 0, la concordancia es más débil que lo esperado en virtud de las probabilidades; esto casi nunca sucede.

El grupo AIAG sugiere que un valor de kappa de al menos 0.75 indica una concordancia adecuada. Sin embargo, se prefieren valores de kappa más grandes, como 0.90.

Cuando tenga clasificaciones ordinales, tales como clasificaciones de la gravedad de los defectos en una escala del 1 al 5, los coeficientes de Kendall, que consideran el orden, suelen ser estadísticos más apropiados para evaluar la asociación que el uso de kappa solamente.

Nota

Recuerde que la tabla Entre evaluadores indica si las clasificaciones de los evaluadores son consistentes, pero no si las clasificaciones concuerdan con los valores de referencia. Las clasificaciones consistentes no necesariamente son clasificaciones correctas.

Acuerdo de evaluación

| No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Estadísticos Kappa de Fleiss

| Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0.954392 | 0.0267261 | 35.7101 | 0.0000 |

| 2 | 0.827694 | 0.0267261 | 30.9695 | 0.0000 |

| 3 | 0.772541 | 0.0267261 | 28.9058 | 0.0000 |

| 4 | 0.891127 | 0.0267261 | 33.3429 | 0.0000 |

| 5 | 0.968148 | 0.0267261 | 36.2248 | 0.0000 |

| General | 0.881705 | 0.0134362 | 65.6218 | 0.0000 |

Coeficiente de concordancia de Kendall

| Coef | Chi-cuad. | GL | P |

|---|---|---|---|

| 0.976681 | 382.859 | 49 | 0.0000 |

Resultados clave: Kappa, coeficiente de concordancia de Kendall

Todos los valores de kappa son mayores que 0.77, lo cual indica una concordancia mínimamente aceptable entre los evaluadores. Los evaluadores coinciden más con respecto a las muestras 1 y 5 y menos con respecto a la muestra 3. Como los datos son ordinales, Minitab proporciona el coeficiente de concordancia de Kendall (0.976681), que indica una asociación muy fuerte entre las clasificaciones de los evaluadores.

Paso 5: Evaluar lo correcto de las respuestas para todos los evaluadores

Para determinar lo correcto de todas las clasificaciones de los evaluadores, examine los estadísticos kappa de la tabla Todos los evaluadores vs. el estándar. Cuando las clasificaciones sean ordinales, también debería evaluar los coeficientes de concordancia de Kendall.

Utilice los estadísticos kappa para evaluar el grado de concordancia de las clasificaciones nominales u ordinales realizadas por múltiples evaluadores cuando los evaluadores evalúen las mismas muestras.

- Cuando Kappa = 1, existe concordancia perfecta.

- Cuando Kappa = 0, la concordancia es la misma que se esperaría en virtud de las probabilidades.

- Cuando Kappa < 0, la concordancia es más débil que lo esperado en virtud de las probabilidades; esto casi nunca sucede.

El grupo AIAG sugiere que un valor de kappa de al menos 0.75 indica una concordancia adecuada. Sin embargo, se prefieren valores de kappa más grandes, como 0.90.

Cuando tenga clasificaciones ordinales, tales como clasificaciones de la gravedad de los defectos en una escala del 1 al 5, los coeficientes de Kendall, que consideran el orden, suelen ser estadísticos más apropiados para evaluar la asociación que el uso de kappa solamente.

Acuerdo de evaluación

| No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Estadísticos Kappa de Fleiss

| Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0.977897 | 0.0500000 | 19.5579 | 0.0000 |

| 2 | 0.849068 | 0.0500000 | 16.9814 | 0.0000 |

| 3 | 0.814992 | 0.0500000 | 16.2998 | 0.0000 |

| 4 | 0.944580 | 0.0500000 | 18.8916 | 0.0000 |

| 5 | 0.983756 | 0.0500000 | 19.6751 | 0.0000 |

| General | 0.912082 | 0.0251705 | 36.2362 | 0.0000 |

Coeficiente de correlación de Kendall

| Coef | EE del Coef. | Z | P |

|---|---|---|---|

| 0.965563 | 0.0345033 | 27.9817 | 0.0000 |

Resultados clave: Kappa, coeficiente de concordancia de Kendall

Estos resultados muestran que todos los evaluadores coincidieron de forma correcta con las clasificaciones estándar en 37 de las 50 muestras. El valor general de kappa es 0.912082, lo que indica una fuerte concordancia con los valores estándar. Como los datos son ordinales, Minitab proporciona el coeficiente de concordancia de Kendall (0.965563), que indica una fuerte asociación entre las clasificaciones y los valores estándar.