Los evaluadores de los tejidos en una empresa de impresión textil califican la calidad de impresión de los tejidos de algodón en una escala de 1 a 5 puntos. El ingeniero de control de calidad desea evaluar qué tan consistentes y correctas son las calificaciones de los evaluadores. El ingeniero pide a cuatro evaluadores que califiquen la calidad de impresión de 50 muestras de tejido dos veces, en orden aleatorio.

Puesto que los datos incluyen un estándar conocido para cada muestra, el ingeniero especializado en calidad puede evaluar qué tan consistentes y correctas son las calificaciones en comparación con el estándar, así como en comparación con otros evaluadores.

- Abra los datos de muestra, CalidadImprTextil.MWX.

- Elija .

- En Los datos están organizados como, seleccione Columna de atributos e ingrese Respuesta.

- En Muestras, ingrese Muestra.

- En Evaluadores, ingrese Evaluador.

- En Estándar/atributo conocido, ingrese Estándar.

- Seleccione Las categorías de los datos de atributos están ordenadas.

- Haga clic en Aceptar.

Interpretar los resultados

- Tabla Por evaluador

- Puesto que cada evaluador proporciona dos o más clasificaciones para cada muestra, el ingeniero puede evaluar la consistencia de cada evaluador.

- Tabla Cada evaluador vs. el estándar

- Puesto que hay un valor estándar conocido para cada muestra, el ingeniero puede evaluar la exactitud y la consistencia de cada una de las clasificaciones del evaluador.

- Tabla Entre evaluadores

- La tabla Entre evaluadores muestra que los evaluadores coinciden en sus clasificaciones para 37 de las 50 muestras.

- Tabla Todos los evaluadores vs. el estándar

- Puesto que hay un valor estándar conocido para cada muestra, el ingeniero puede evaluar la exactitud de las clasificaciones de los evaluadores.

Nota

El valor p de 0.00 que se muestra en la salida se redondeó. Sin embargo, se puede concluir con seguridad que el valor p es muy bajo y que es < 0.00005.

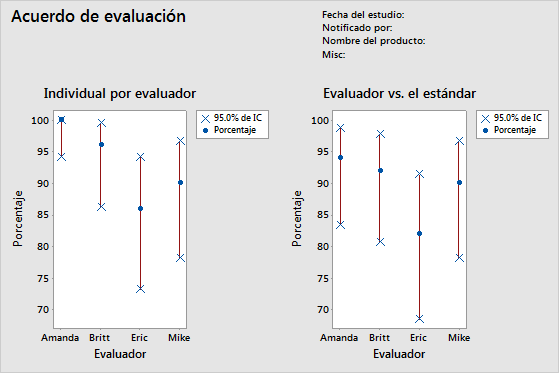

Acuerdo de evaluación

| Evaluador | No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100.00 | (94.18, 100.00) |

| Britt | 50 | 48 | 96.00 | (86.29, 99.51) |

| Eric | 50 | 43 | 86.00 | (73.26, 94.18) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Estadísticos Kappa de Fleiss

| Evaluador | Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 3 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 1.00000 | 0.071052 | 14.0741 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.89605 | 0.141421 | 6.3360 | 0.0000 | |

| 3 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 0.94965 | 0.071401 | 13.3002 | 0.0000 | |

| Eric | 1 | 0.83060 | 0.141421 | 5.8733 | 0.0000 |

| 2 | 0.84000 | 0.141421 | 5.9397 | 0.0000 | |

| 3 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 4 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| General | 0.82354 | 0.071591 | 11.5034 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.83060 | 0.141421 | 5.8733 | 0.0000 | |

| 3 | 0.81917 | 0.141421 | 5.7924 | 0.0000 | |

| 4 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 5 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| General | 0.87472 | 0.070945 | 12.3295 | 0.0000 |

Coeficiente de concordancia de Kendall

| Evaluador | Coef | Chi-cuad. | GL | P |

|---|---|---|---|---|

| Amanda | 1.00000 | 98.0000 | 49 | 0.0000 |

| Britt | 0.99448 | 97.4587 | 49 | 0.0000 |

| Eric | 0.98446 | 96.4769 | 49 | 0.0001 |

| Mike | 0.98700 | 96.7256 | 49 | 0.0001 |

Acuerdo de evaluación

| Evaluador | No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94.00 | (83.45, 98.75) |

| Britt | 50 | 46 | 92.00 | (80.77, 97.78) |

| Eric | 50 | 41 | 82.00 | (68.56, 91.42) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Estadísticos Kappa de Fleiss

| Evaluador | Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83060 | 0.100000 | 8.3060 | 0.0000 | |

| 3 | 0.81917 | 0.100000 | 8.1917 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.92476 | 0.050257 | 18.4006 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83838 | 0.100000 | 8.3838 | 0.0000 | |

| 3 | 0.80725 | 0.100000 | 8.0725 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.92462 | 0.050396 | 18.3473 | 0.0000 | |

| Eric | 1 | 0.91159 | 0.100000 | 9.1159 | 0.0000 |

| 2 | 0.81035 | 0.100000 | 8.1035 | 0.0000 | |

| 3 | 0.72619 | 0.100000 | 7.2619 | 0.0000 | |

| 4 | 0.84919 | 0.100000 | 8.4919 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| General | 0.86163 | 0.050500 | 17.0622 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.91694 | 0.100000 | 9.1694 | 0.0000 | |

| 3 | 0.90736 | 0.100000 | 9.0736 | 0.0000 | |

| 4 | 0.92913 | 0.100000 | 9.2913 | 0.0000 | |

| 5 | 0.93502 | 0.100000 | 9.3502 | 0.0000 | |

| General | 0.93732 | 0.050211 | 18.6674 | 0.0000 |

Coeficiente de correlación de Kendall

| Evaluador | Coef | EE del Coef. | Z | P |

|---|---|---|---|---|

| Amanda | 0.967386 | 0.0690066 | 14.0128 | 0.0000 |

| Britt | 0.967835 | 0.0690066 | 14.0193 | 0.0000 |

| Eric | 0.951863 | 0.0690066 | 13.7879 | 0.0000 |

| Mike | 0.975168 | 0.0690066 | 14.1256 | 0.0000 |

Acuerdo de evaluación

| No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Estadísticos Kappa de Fleiss

| Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0.954392 | 0.0267261 | 35.7101 | 0.0000 |

| 2 | 0.827694 | 0.0267261 | 30.9695 | 0.0000 |

| 3 | 0.772541 | 0.0267261 | 28.9058 | 0.0000 |

| 4 | 0.891127 | 0.0267261 | 33.3429 | 0.0000 |

| 5 | 0.968148 | 0.0267261 | 36.2248 | 0.0000 |

| General | 0.881705 | 0.0134362 | 65.6218 | 0.0000 |

Coeficiente de concordancia de Kendall

| Coef | Chi-cuad. | GL | P |

|---|---|---|---|

| 0.976681 | 382.859 | 49 | 0.0000 |

Acuerdo de evaluación

| No. de inspeccionados | No. de coincidencias | Porcentaje | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Estadísticos Kappa de Fleiss

| Respuesta | Kappa | Error estándar de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0.977897 | 0.0500000 | 19.5579 | 0.0000 |

| 2 | 0.849068 | 0.0500000 | 16.9814 | 0.0000 |

| 3 | 0.814992 | 0.0500000 | 16.2998 | 0.0000 |

| 4 | 0.944580 | 0.0500000 | 18.8916 | 0.0000 |

| 5 | 0.983756 | 0.0500000 | 19.6751 | 0.0000 |

| General | 0.912082 | 0.0251705 | 36.2362 | 0.0000 |

Coeficiente de correlación de Kendall

| Coef | EE del Coef. | Z | P |

|---|---|---|---|

| 0.965563 | 0.0345033 | 27.9817 | 0.0000 |