In diesem Thema

Anpassung

Angepasste Werte sind auch bekannt als Anpassungen oder  . Die angepassten Werte sind Punktschätzungen des Mittelwerts der Antwortvariablen für die gegebenen Werte der Prädiktoren. Die Werte der Prädiktoren werden auch als x-Werte bezeichnet.

. Die angepassten Werte sind Punktschätzungen des Mittelwerts der Antwortvariablen für die gegebenen Werte der Prädiktoren. Die Werte der Prädiktoren werden auch als x-Werte bezeichnet.

Interpretation

Angepasste Werte werden durch Einsetzen der spezifischen x-Werte für jede Beobachtung im Datensatz in die Modellgleichung berechnet.

Wenn die Gleichung beispielsweise y = 5 + 10x lautet, ergibt ein x-Wert von 2 den angepassten Wert 25 (25 = 5 + 10(2)).

Beobachtungen mit angepassten Werten, die stark vom beobachteten Wert abweichen, können ungewöhnlich sein. Beobachtungen mit ungewöhnlichen Prädiktorwerten üben möglicherweise einen starken Einfluss aus. Wenn Minitab feststellt, dass Ihre Daten ungewöhnliche oder einflussreiche Werte enthalten, enthält die Ausgabe die Tabelle „Anpassungen und Bewertung für ungewöhnliche Beobachtungen“, in der die betreffenden Beobachtungen identifiziert werden. Die von Minitab als ungewöhnlich gekennzeichneten Beobachtungen werden durch die vorgeschlagene Regressionsgleichung nicht gut modelliert. Es ist jedoch zu erwarten, dass einige ungewöhnliche Beobachtungen vorliegen. Entsprechend den Kriterien für große standardisierte Residuen ist beispielsweise zu erwarten, dass ca. 5 % der Beobachtungen als Beobachtungen mit einem großen standardisierten Residuum gekennzeichnet werden. Weitere Informationen zu ungewöhnlichen Werten finden Sie unter Ungewöhnliche Beobachtungen.

SE Anpassung

Der Standardfehler der Anpassung (SE Anpassung) ist ein Schätzwert der Streuung im geschätzten Mittelwert der Antwort für die angegebenen Variableneinstellungen. Der Standardfehler der Anpassung wird bei der Berechnung des Konfidenzintervalls für den Mittelwert der Antwortvariablen verwendet. Standardfehler sind immer nicht negativ. Die Analyse berechnet Standardfehler für Modelle aus dem Statistik Menü und Modelle aus Lineare Regression und Binäre logistische Regression aus der Predictive Analytics-Modul.

Interpretation

Verwenden Sie den Standardfehler der Anpassung, um zu ermitteln, wie genau der Schätzwert für den Mittelwert der Antwort ist. Je kleiner der Standardfehler, desto genauer ist der prognostizierte Mittelwert der Antwort. Ein Analytiker entwickelt beispielsweise ein Modell, um die Lieferzeit zu prognostizieren. Für einen Satz von Variableneinstellungen prognostiziert das Modell eine mittlere Lieferzeit von 3,80 Tagen. Der Standardfehler der Anpassung für diese Einstellungen beträgt 0,08 Tage. Für einen zweiten Satz von Variableneinstellungen errechnet das Modell dieselbe mittlere Lieferzeit mit einem Standardfehler der Anpassung von 0,02 Tagen. Der Analytiker kann sich sicherer sein, dass die mittlere Lieferzeit für den zweiten Satz von Variableneinstellungen nahe an 3,80 Tagen liegt.

Mit dem angepassten Wert können Sie den Standardfehler der Anpassung verwenden, um ein Konfidenzintervall für die mittlere Antwortvariablen zu erstellen. Abhängig von der Anzahl der Freiheitsgrade erstreckt sich ein Konfidenzintervall von 95 % beispielsweise über und unter den vorhergesagten Mittelwert. Für die Lieferzeiten beträgt das 95%-Konfidenzintervall des prognostizierten Mittelwerts von 3,80 Tagen bei einem Standardfehler von 0,08 (3,64; 3,96) Tage. Sie können zu 95 % sicher sein, dass der Mittelwert der Grundgesamtheit innerhalb dieses Bereichs liegt. Wenn der Standardfehler 0,02 beträgt, ist das 95%-Konfidenzintervall (3,76; 3,84) Tage. Das Konfidenzintervall für den zweiten Satz von Variableneinstellungen ist schmaler, weil der Standardfehler kleiner ist.

Konfidenzintervall für Anpassung (95%-KI)

Diese Konfidenzintervalle (KI) sind Bereiche von Werten, die wahrscheinlich den Mittelwert der Antwortvariablen für die Grundgesamtheit enthalten, die die beobachteten Werte der Prädiktoren bzw. Faktoren im Modell aufweist.

Da die Stichproben zufällig sind, ist es unwahrscheinlich, dass zwei Stichproben aus einer Grundgesamtheit identische Konfidenzintervalle ergeben. Wenn Sie die Stichprobennahme jedoch viele Male wiederholen, enthält ein gewisser Prozentsatz der resultierenden Konfidenzintervalle den unbekannten Parameter der Grundgesamtheit. Der Prozentsatz dieser Konfidenzintervalle, die den Parameter enthalten, stellt das Konfidenzniveau des Intervalls dar.

Das Konfidenzintervall setzt sich aus den folgenden zwei Teilen zusammen:

Interpretation

Verwenden Sie das Konfidenzintervall, um den Schätzwert des angepassten Werts für die beobachteten Werte der Variablen auszuwerten.

Bei einem 95%-Konfidenzniveau können Sie sich beispielsweise zu 95 % sicher sein, dass das Konfidenzintervall den Mittelwert der Grundgesamtheit für die angegebenen Werte der Prädiktorvariablen oder Faktoren im Modell enthält. Anhand des Konfidenzintervalls können Sie die praktische Signifikanz Ihrer Ergebnisse beurteilen. Bestimmen Sie anhand Ihrer Fachkenntnisse, ob das Konfidenzintervall Werte umfasst, die in der jeweiligen Situation von praktischer Signifikanz sind. Ein breites Konfidenzintervall deutet darauf hin, dass Sie sich bezüglich des Mittelwerts von künftigen Werten weniger sicher sein können. Wenn das Intervall zu breit und damit nicht hilfreich ist, erwägen Sie, den Stichprobenumfang zu vergrößern.

Resid

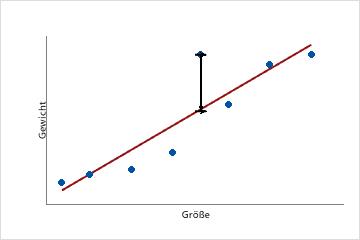

Ein Residuum (ei) ist die Differenz zwischen einem beobachteten Wert (y) und dem entsprechenden angepassten Wert ( ), bei dem es sich um den Wert handelt, der vom Modell prognostiziert wird.

), bei dem es sich um den Wert handelt, der vom Modell prognostiziert wird.

Dieses Streudiagramm zeigt das Gewicht im Vergleich zur Größe für eine Stichprobe erwachsener Männer. Die angepasste Regressionslinie stellt die Beziehung zwischen Größe und Gewicht dar. Wenn die Größe 6 Fuß beträgt, ist der angepasste Wert für das Gewicht 190 Pfund. Wenn das tatsächliche Gewicht 200 Pfund beträgt, ist das Residuum 10.

Interpretation

Stellen Sie die Residuen grafisch dar, um zu ermitteln, ob das Modell angemessen ist und die Annahmen für die Regression erfüllt. Eine Untersuchung der Residuen kann nützliche Informationen darüber liefern, wie gut das Modell an die Daten angepasst ist. Im Allgemeinen sollten die Residuen zufällig verteilt sein und weder offensichtliche Muster noch ungewöhnliche Werte aufweisen. Wenn Minitab feststellt, dass die Daten ungewöhnliche Beobachtungen enthalten, werden diese Beobachtungen in der Tabelle „Anpassungen und Bewertung für ungewöhnliche Beobachtungen“ in der Ausgabe identifiziert. Die von Minitab als ungewöhnlich gekennzeichneten Beobachtungen werden durch die vorgeschlagene Regressionsgleichung nicht gut modelliert. Es ist jedoch zu erwarten, dass einige ungewöhnliche Beobachtungen vorliegen. Entsprechend den Kriterien für große Residuen ist beispielsweise zu erwarten, dass ca. 5 % der Beobachtungen als Beobachtungen mit einem großen Residuum gekennzeichnet werden. Weitere Informationen zu ungewöhnlichen Werten finden Sie unter Ungewöhnliche Beobachtungen.

Std. Resid

Das standardisierte Residuum entspricht dem Wert eines Residuums ei dividiert durch einen Schätzwert von dessen Standardabweichung.

Interpretation

Verwenden Sie die standardisierten Residuen, um Ausreißer zu erkennen. Standardisierte Residuen, die größer als 2 bzw. kleiner als −2 sind, werden im Allgemeinen als groß erachtet. In der Tabelle „Anpassungen und Bewertung für ungewöhnliche Beobachtungen“ werden die betreffenden Beobachtungen mit einem „R“ gekennzeichnet. Die von Minitab gekennzeichneten Beobachtungen werden durch die vorgeschlagene Regressionsgleichung nicht gut modelliert. Es ist jedoch zu erwarten, dass einige ungewöhnliche Beobachtungen vorliegen. Entsprechend den Kriterien für große standardisierte Residuen ist beispielsweise zu erwarten, dass ca. 5 % der Beobachtungen als Beobachtungen mit einem großen standardisierten Residuum gekennzeichnet werden. Weitere Informationen finden Sie unter Ungewöhnliche Beobachtungen.

Standardisierte Residuen sind hilfreich, da Rohresiduen u. U. keine geeigneten Anzeichen für Ausreißer darstellen. Die Varianz jedes Rohresiduums kann um die mit ihm verbundenen x-Werte abweichen. Diese ungleiche Streuung erschwert es, die Größen der Rohresiduen zu beurteilen. Durch das Standardisieren der Residuen wird dieses Problem behoben, indem die unterschiedlichen Varianzen in eine gemeinsame Skala konvertiert werden.

Entfernte Residuen

Jedes entfernte studentisierte Residuum wird mit einer Formel berechnet, die diesem Verfahren entspricht: Jede einzelne Beobachtung wird systematisch aus dem Datensatz entfernt, die Regressionsgleichung wird geschätzt, und es wird ermittelt, wie genau das Modell die entfernte Beobachtung prognostiziert. Jedes entfernte studentisierte Residuum wird zudem standardisiert, indem das entfernte Residuum einer Beobachtung durch einen Schätzwert seiner Standardabweichung dividiert wird. Die Beobachtung wird entfernt, um das Verhalten des Modells ohne die betreffende Beobachtung zu ermitteln. Wenn eine Beobachtung ein großes studentisiertes entferntes Residuum aufweist (dessen Absolutwert größer als 2 ist), kann es sich um einen Ausreißer in den Daten handeln.

Interpretation

Verwenden Sie die entfernten studentisierten Residuen, um Ausreißer zu erkennen. Jede Beobachtung wird entfernt, um zu ermitteln, wie genau das Modell die Antwortvariable prognostiziert, wenn sie nicht in den Prozess der Modellanpassung eingebunden wird. Entfernte studentisierte Residuen größer als 2 oder kleiner als −2 werden in der Regel als groß erachtet. Die von Minitab gekennzeichneten Beobachtungen werden durch die vorgeschlagene Regressionsgleichung nicht gut modelliert. Es ist jedoch zu erwarten, dass einige ungewöhnliche Beobachtungen vorliegen. Entsprechend den Kriterien für große Residuen ist beispielsweise zu erwarten, dass ca. 5 % der Beobachtungen als Beobachtungen mit einem großen Residuum gekennzeichnet werden. Wenn die Analyse viele ungewöhnliche Beobachtungen aufdeckt, beschreibt das Modell die Beziehung zwischen den Prädiktoren und der Antwortvariablen höchstwahrscheinlich nicht adäquat. Weitere Informationen finden Sie unter Ungewöhnliche Beobachtungen.

Standardisierte und entfernte Residuen können beim Ermitteln von Ausreißern nützlicher als Rohresiduen sein. Es wird eine Korrektur für mögliche Differenzen in der Varianz der Rohresiduen vorgenommen, die auf unterschiedliche Werte der Prädiktoren oder Faktoren zurückzuführen sind.

Hoch (Hebelwirkung)

„Hoch“ (auch als Hebelwirkung bezeichnet) ist ein Maß für den Abstand vom x-Wert einer Beobachtung zum Durchschnitt der x-Werte aller Beobachtungen in einem Datensatz.

Interpretation

Hoch-Werte liegen zwischen 0 und 1. Minitab kennzeichnet Beobachtungen mit Hebelwirkungswerten von mehr als 3p/n oder, falls kleiner, 0,99 in der Tabelle „Anpassungen und Bewertung für ungewöhnliche Beobachtungen“ mit einem „X“. Im Ausdruck 3p/n ist p die Anzahl der Koeffizienten im Modell und n die Anzahl der Beobachtungen. Die von Minitab mit einem „X“ gekennzeichneten Beobachtungen können einflussreich sein.

Beobachtungen mit großem Einfluss wirken sich disproportional auf das Modell aus und können irreführende Ergebnisse verursachen. Das Einbinden oder Ausschließen eines einflussreichen Punkts könnte beispielsweise ändern, ob ein Koeffizient statistisch signifikant ist. Beobachtungen mit großem Einfluss können Hebelwirkungspunkte, Ausreißer oder beides sein.

Wenn Sie eine einflussreiche Beobachtung feststellen, ermitteln Sie, ob es sich bei der Beobachtung um einen Dateneingabe- oder Messfehler handelt. Wenn die Beobachtung weder einen Dateneingabefehler noch einen Messfehler darstellt, bestimmen Sie, wie einflussreich die Beobachtung ist. Passen Sie das Modell zuerst mit der Beobachtung und dann ohne die Beobachtung an. Vergleichen Sie anschließend die Koeffizienten, p-Werte, R2-Werte und weitere Modellinformationen. Wenn sich das Modell nach Entfernen der einflussreichen Beobachtung signifikant ändert, untersuchen Sie das Modell eingehender, um festzustellen, ob Sie das Modell falsch angegeben haben. Möglicherweise müssen Sie weitere Daten erfassen, um das Problem zu beheben.

Cook-Distanz (D)

Die Cook-Distanz (D) ist ein Maß für den Effekt einer Beobachtung auf eine Gruppe von Koeffizienten in einem linearen Modell. Bei der Cook-Distanz werden sowohl die Hebelwirkung als auch das standardisierte Residuum jeder Beobachtung berücksichtigt, um den Effekt der betreffenden Beobachtung zu ermitteln.

Interpretation

Beobachtungen mit einem großen D-Wert können einflussreich sein. Ein D-Wert wird häufig als groß betrachtet, wenn er größer als der Median der F-Verteilung F(0,5; p; n–p) ist, wobei p die Anzahl der Modellterme einschließlich der Konstanten und n die Anzahl der Beobachtungen ist. Sie können die D-Werte auch untersuchen, indem Sie sie in einer Grafik vergleichen, beispielsweise in einem Einzelwertdiagramm. Beobachtungen, deren D-Werte im Verhältnis zu denen anderer Beobachtungen groß sind, können einen starken Einfluss ausüben.

Beobachtungen mit großem Einfluss wirken sich disproportional auf das Modell aus und können irreführende Ergebnisse verursachen. Das Einbinden oder Ausschließen eines einflussreichen Punkts könnte beispielsweise ändern, ob ein Koeffizient statistisch signifikant ist. Beobachtungen mit großem Einfluss können Hebelwirkungspunkte, Ausreißer oder beides sein.

Wenn Sie eine einflussreiche Beobachtung feststellen, ermitteln Sie, ob es sich bei der Beobachtung um einen Dateneingabe- oder Messfehler handelt. Wenn die Beobachtung weder einen Dateneingabefehler noch einen Messfehler darstellt, bestimmen Sie, wie einflussreich die Beobachtung ist. Passen Sie das Modell zuerst mit der Beobachtung und dann ohne die Beobachtung an. Vergleichen Sie anschließend die Koeffizienten, p-Werte, R2-Werte und weitere Modellinformationen. Wenn sich das Modell nach Entfernen der einflussreichen Beobachtung signifikant ändert, untersuchen Sie das Modell eingehender, um festzustellen, ob Sie das Modell falsch angegeben haben. Möglicherweise müssen Sie weitere Daten erfassen, um das Problem zu beheben.

DFITS

DFITS ist ein Maß für den Effekt der einzelnen Beobachtungen auf die angepassten Werte in einem linearen Modell. DFITS stellt die annähernde Anzahl der Standardabweichungen dar, um die sich der angepasste Wert ändert, wenn je eine Beobachtung aus dem Datensatz entfernt und das Modell erneut angepasst wird.

Interpretation

| Begriff | Beschreibung |

|---|---|

| p | Anzahl der Modellterme |

| n | Anzahl der Beobachtungen |

Beobachtungen mit großem Einfluss wirken sich disproportional auf das Modell aus und können irreführende Ergebnisse verursachen. Das Einbinden oder Ausschließen eines einflussreichen Punkts könnte beispielsweise ändern, ob ein Koeffizient statistisch signifikant ist. Beobachtungen mit großem Einfluss können Hebelwirkungspunkte, Ausreißer oder beides sein.

Wenn Sie eine einflussreiche Beobachtung feststellen, ermitteln Sie, ob es sich bei der Beobachtung um einen Dateneingabe- oder Messfehler handelt. Wenn die Beobachtung weder einen Dateneingabefehler noch einen Messfehler darstellt, bestimmen Sie, wie einflussreich die Beobachtung ist. Passen Sie das Modell zuerst mit der Beobachtung und dann ohne die Beobachtung an. Vergleichen Sie anschließend die Koeffizienten, p-Werte, R2-Werte und weitere Modellinformationen. Wenn sich das Modell nach Entfernen der einflussreichen Beobachtung signifikant ändert, untersuchen Sie das Modell eingehender, um festzustellen, ob Sie das Modell falsch angegeben haben. Möglicherweise müssen Sie weitere Daten erfassen, um das Problem zu beheben.

Durbin-Watson-Statistik

Prüfen Sie mit Hilfe der Durbin-Watson-Statistik, ob in den Fehlern eines Regressionsmodells Autokorrelation vorliegt. Autokorrelation bedeutet, dass die Fehler benachbarter Beobachtungen korrelieren. Wenn die Fehler korrelieren, kann der Standardfehler der Koeffizienten bei der Regression der kleinsten Quadrate unterschätzt werden. Durch unterschätzte Standardfehler können Prädiktoren signifikant erscheinen, obwohl sie es nicht sind.

Interpretation

Mit der Durbin-Watson-Statistik wird ermittelt, ob die Korrelation zwischen benachbarten Fehlertermen gleich null ist. Um eine Schlussfolgerung aus dem Test abzuleiten, müssen Sie die angezeigte Statistik mit der oberen und unteren Grenze in einer Tabelle vergleichen. Eine Tabelle für Stichprobenumfänge von bis zu 200 und für bis zu 21 Terme finden Sie unter Testen auf Autokorrelation mit der Durbin-Watson-Statistik.

Mit der Durbin-Watson-Statistik werden Tests auf Autokorrelation 1. Ordnung durchgeführt. Um nach anderen Mustern der chronologischen Reihenfolge zu suchen, schauen Sie sich ein Diagramm der Residuen im Vergleich zur Reihenfolge der Daten an.

Anpassungen und Bewertung für einen Testdatensatz

Interpretation

Im Allgemeinen verwenden Sie die Anpassungen und die Bewertung aus dem Testdatensatz auf die gleiche Weise wie die betreffenden Statistiken für den Trainingsdatensatz. Untersuchen Sie die Anpassungen und Konfidenzintervalle, um die Genauigkeit der Schätzungen zu ermitteln. Untersuchen Sie die Residuen, um den Fehlerbetrag zu bestimmen. Untersuchen Sie die ungewöhnlichen Datenpunkte, um die Prädiktorwerte zu ermitteln, bei denen das Modell möglicherweise nicht gut passend ist.

Ein Unterschied besteht darin, dass ungewöhnliche Beobachtungen im Testdatensatz keine Auswirkung auf die Schätzung des Modells haben können. Ein Punkt mit hoher Hebelwirkung gibt stattdessen eine Stelle an, an der der Testdatensatz eine Extrapolation in Bezug auf den Trainingsdatensatz darstellt. Gehen Sie mit Vorsicht vor, wenn Sie eine Extrapolation aus dem Datenbereich in der Schätzung des Modells heraus vornehmen.

Minitab zeigt keine entfernten Residuen, Cook-Distanzen oder DFITS für den Testdatensatz an. Entfernte Residuen zeigen, wie gut das Modell den Wert der Antwortvariablen prognostiziert, wenn eine Beobachtung nicht im Modellanpassungsprozess enthalten ist. Die Cook-Distanz misst den Effekt einer Beobachtung auf die Gruppe von Koeffizienten in einem linearen Modell. DFITS misst den Effekt der einzelnen Beobachtungen auf die angepassten Werte in einem linearen Modell. Da keine der Beobachtungen im Testdatensatz im Modellanpassungsprozess berücksichtigt wird, bietet keine dieser Statistiken eine Interpretation für den Testdatensatz.