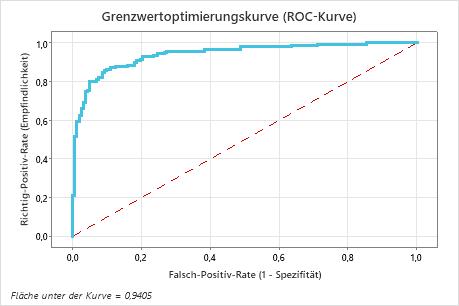

Die ROC-Kurve zeigt die Richtig-Positiv-Rate (TPR), auch als Trennschärfe bezeichnet, auf der y-Achse. Die ROC-Kurve zeigt die Falsch-Positiv-Rate (FPR), auch als Fehler 1. Art bezeichnet, auf der x-Achse. Die Fläche unter einer ROC-Kurve gibt an, ob das binäre Modell ein guter Klassifikator ist.

Interpretation

Die Fläche unter der ROC-Kurve kann Werte von 0,5 bis 1 annehmen. Wenn das binäre Modell die Klassen perfekt trennen kann, entspricht die Fläche unter der Kurve 1. Wenn das binäre Modell die Klassen nicht besser als eine zufällige Einteilung trennen kann, entspricht die Fläche unter der Kurve 0,5.

In diesem Beispiel entspricht die Fläche unter der Kurve für den Test 0,9405.

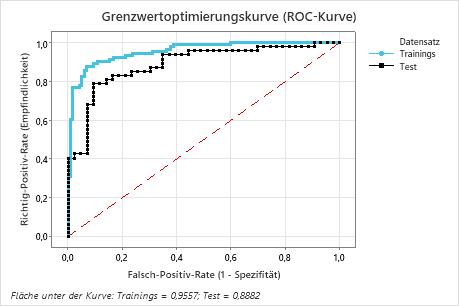

Mit einer Validierungsmethode erstellt Minitab zwei ROC-Kurven. Eine Kurve ist für die Trainingsdaten und die andere für die Validierungsdaten. Die Validierungsergebnisse geben an, ob das Modell die Werte der Antwortvariablen für neue Beobachtungen angemessen prognostizieren oder die Beziehungen zwischen der Antwortvariablen und den Prädiktorvariablen adäquat zusammenfassen kann. Die Ergebnisse für die Trainingsdaten sind in der Regel optimaler als für die tatsächlichen Daten und dienen nur zur Referenz.

Eine k-fache Fläche unter der ROC-Kurve, die wesentlich kleiner ist als die Fläche unter der ROC-Kurve, kann darauf hinweisen, dass das Modell überangepasst ist. Ein überangepasstes Modell tritt auf, wenn das Modell Begriffe enthält, die in der Grundgesamtheit nicht wichtig sind. Das Modell wird auf die Trainingsdaten zugeschnitten und ist daher möglicherweise nicht nützlich, um Vorhersagen über die Grundgesamtheit zu treffen.

In diesem Beispiel zeigt die Trainingskurve eine bessere Anpassung als die Testkurve. Die Leistung der Testkurve ist in der Regel eine bessere Darstellung der Leistung des Modells für neue Daten. Die Fläche unter der Kurve für den Test beträgt 0,8882.