Hinweis

Dieser Befehl ist mit dem Predictive Analytics-Modul verfügbar. Klicken Sie hier, um weitere Informationen zum Aktivieren des Moduls zu erhalten.

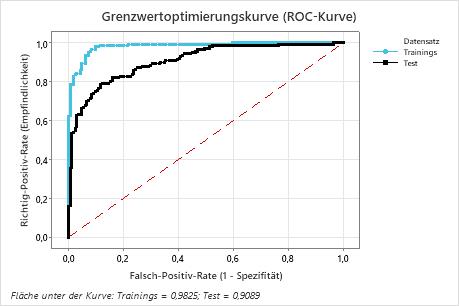

Die ROC-Kurve zeigt die Richtig-Positiv-Rate (TPR), auch als Trennschärfe bezeichnet, auf der y-Achse. Die ROC-Kurve zeigt die Falsch-Positiv-Rate (FPR), auch als Fehler 1. Art bezeichnet, auf der x-Achse. Die Fläche unter einer ROC-Kurve gibt an, ob das Modell ein guter Klassifikator ist.

Interpretation

Die Fläche unter der Kurve für den Test beträgt etwa 0,91. Vergleichen Sie die Trainingsergebnisse und die Testergebnisse, um festzustellen, ob es Probleme mit dem Modell in Bezug auf eine übermäßige Anpassung an den Trainingsdatensatz gibt.