In diesem Thema

- Schritt 1: Visuelles Untersuchen der Prüferübereinstimmung

- Schritt 2: Beständigkeit der Antworten für jeden Prüfer auswerten

- Schritt 3: Richtigkeit der Einstufungen jedes Prüfers auswerten

- Schritt 4: Einheitlichkeit der Einstufungen zwischen den einzelnen Prüfern auswerten

- Schritt 5: Richtigkeit der Antworten für alle Prüfer auswerten

Schritt 1: Visuelles Untersuchen der Prüferübereinstimmung

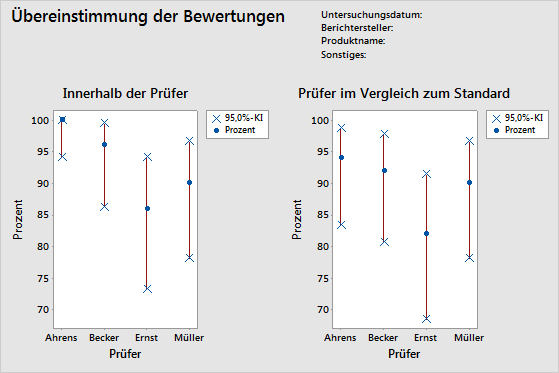

Um zu ermitteln, wie beständig die Einstufungen der einzelnen Prüfer ausfallen, werten Sie die Grafik „Innerhalb der Prüfer“ aus. Vergleichen Sie die prozentuale Übereinstimmung (blauer Kreis) mit dem Konfidenzintervall für die prozentuale Übereinstimmung (rote Linie) für jeden Prüfer.

Um die Richtigkeit der Einstufungen jedes Prüfers zu ermitteln, werten Sie die Grafik „Prüfer im Vergleich zum Standard“ aus. Vergleichen Sie die prozentuale Übereinstimmung (blauer Kreis) mit dem Konfidenzintervall für die prozentuale Übereinstimmung (rote Linie) für jeden Prüfer.

Hinweis

Minitab zeigt die Grafik „Innerhalb der Prüfer“ nur an, wenn mehrere Versuche vorliegen.

Diese Grafik „Innerhalb der Prüfer“ zeigt, dass für Ahrens die beständigsten Einstufungen und für Ernst die am wenigsten beständigen Einstufungen vorliegen. Die Grafik „Prüfer im Vergleich zum Standard“ belegt, dass Ahrens die meisten richtigen Einstufungen und Ernst die wenigsten richtigen Einstufungen vorgenommen hat.

Schritt 2: Beständigkeit der Antworten für jeden Prüfer auswerten

Um zu ermitteln, wie beständig die Einstufungen der einzelnen Prüfer ausfallen, werten Sie die Kappa-Statistiken in der Tabelle „Innerhalb der Prüfer“ aus. Bei ordinalen Einstufungen sollten Sie außerdem die Kendall-Koeffizienten der Konkordanz betrachten. Minitab zeigt die Tabelle „Innerhalb der Prüfer“ an, wenn jeder Prüfer eine Prüfeinheit mehrmals einstuft.

Anhand der Kappa-Statistiken können Sie den Grad der Übereinstimmung der nominalen oder ordinalen Einstufungen mehrerer Prüfer ermitteln, wenn mehrere Prüfer dieselben Stichproben einstufen.

- Bei Kappa = 1 liegt eine vollkommene Übereinstimmung vor.

- Bei Kappa = 0 entspricht die Übereinstimmung der erwarteten zufälligen Übereinstimmung.

- Bei Kappa < 0 ist die Übereinstimmung geringer als die erwartete zufällige Übereinstimmung. Dies tritt jedoch sehr selten auf.

Laut der AIAG lässt ein Kappa-Wert von mindestens 0,75 auf eine gute Übereinstimmung schließen. Größere Kappa-Werte wie 0,90 sind jedoch vorzuziehen.

Wenn ordinale Einstufungen vorliegen, z. B. Bewertungen des Schweregrads von Fehlern auf einer Skala von 1 bis 5, stellen Kendall-Koeffizienten, bei denen die Reihenfolge berücksichtigt wird, meist eine besser geeignete Statistik zum Bestimmen der Assoziation als Kappa allein dar.

Hinweis

Bedenken Sie, dass die Tabelle „Innerhalb der Prüfer“ angibt, ob die Einstufungen der Prüfer einheitlich sind, jedoch nicht, ob die Einstufungen mit den Referenzwerten übereinstimmen. Einheitliche Einstufungen sind nicht unbedingt richtige Einstufungen.

Übereinstimmung der Bewertungen

| Prüfer | # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|---|

| Ahrens | 50 | 50 | 100,00 | (94,18; 100,00) |

| Becker | 50 | 48 | 96,00 | (86,29; 99,51) |

| Ernst | 50 | 43 | 86,00 | (73,26; 94,18) |

| Müller | 50 | 45 | 90,00 | (78,19; 96,67) |

Fleiss-Kappa-Statistik

| Prüfer | Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|---|

| Ahrens | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 3 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 1,00000 | 0,071052 | 14,0741 | 0,0000 | |

| Becker | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,89605 | 0,141421 | 6,3360 | 0,0000 | |

| 3 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 0,94965 | 0,071401 | 13,3002 | 0,0000 | |

| Ernst | 1 | 0,83060 | 0,141421 | 5,8733 | 0,0000 |

| 2 | 0,84000 | 0,141421 | 5,9397 | 0,0000 | |

| 3 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 4 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 0,82354 | 0,071591 | 11,5034 | 0,0000 | |

| Müller | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,83060 | 0,141421 | 5,8733 | 0,0000 | |

| 3 | 0,81917 | 0,141421 | 5,7924 | 0,0000 | |

| 4 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 5 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| Gesamt | 0,87472 | 0,070945 | 12,3295 | 0,0000 |

Kendall-Koeffizient der Konkordanz

| Prüfer | Koef | Chi-Qd | DF | p |

|---|---|---|---|---|

| Ahrens | 1,00000 | 98,0000 | 49 | 0,0000 |

| Becker | 0,99448 | 97,4587 | 49 | 0,0000 |

| Ernst | 0,98446 | 96,4769 | 49 | 0,0001 |

| Müller | 0,98700 | 96,7256 | 49 | 0,0001 |

Wichtigste Ergebnisse: Kappa, Kendall-Koeffizient der Konkordanz

Viele der Kappa-Werte sind gleich 1; dies weist auf eine vollständige Übereinstimmung der Einstufungen eines Prüfers über mehrere Versuche hin. Einige der Kappa-Werte von Ernst liegen nahe 0,70. Möglicherweise sollten Sie untersuchen, weshalb die Einstufungen dieser Stichproben durch Ernst unbeständig waren. Da die Daten ordinal sind, gibt Minitab die Werte des Kendall-Koeffizienten der Konkordanz aus. Diese Werte sind durchgängig größer als 0,98; dies verweist auf eine sehr stark ausgeprägte Assoziation zwischen den Einstufungen des jeweiligen Prüfers.

Schritt 3: Richtigkeit der Einstufungen jedes Prüfers auswerten

Um die Richtigkeit der Einstufungen jedes Prüfers auszuwerten, betrachten Sie die Kappa-Statistiken in der Tabelle „Jeder Prüfer im Vergleich zum Standard“. Bei ordinalen Einstufungen sollten Sie darüber hinaus die Kendall-Koeffizienten der Konkordanz heranziehen. Minitab gibt die Tabelle „Jeder Prüfer im Vergleich zum Standard“ aus, wenn Sie für jede Stichprobe einen Referenzwert angeben.

Anhand der Kappa-Statistiken können Sie den Grad der Übereinstimmung der nominalen oder ordinalen Einstufungen mehrerer Prüfer ermitteln, wenn mehrere Prüfer dieselben Stichproben einstufen.

- Bei Kappa = 1 liegt eine vollkommene Übereinstimmung vor.

- Bei Kappa = 0 entspricht die Übereinstimmung der erwarteten zufälligen Übereinstimmung.

- Bei Kappa < 0 ist die Übereinstimmung geringer als die erwartete zufällige Übereinstimmung. Dies tritt jedoch sehr selten auf.

Laut der AIAG lässt ein Kappa-Wert von mindestens 0,75 auf eine gute Übereinstimmung schließen. Größere Kappa-Werte wie 0,90 sind jedoch vorzuziehen.

Wenn ordinale Einstufungen vorliegen, z. B. Bewertungen des Schweregrads von Fehlern auf einer Skala von 1 bis 5, stellen Kendall-Koeffizienten, bei denen die Reihenfolge berücksichtigt wird, meist eine besser geeignete Statistik zum Bestimmen der Assoziation als Kappa allein dar.

Übereinstimmung der Bewertungen

| Prüfer | # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|---|

| Ahrens | 50 | 47 | 94,00 | (83,45; 98,75) |

| Becker | 50 | 46 | 92,00 | (80,77; 97,78) |

| Ernst | 50 | 41 | 82,00 | (68,56; 91,42) |

| Müller | 50 | 45 | 90,00 | (78,19; 96,67) |

Fleiss-Kappa-Statistik

| Prüfer | Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|---|

| Ahrens | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83060 | 0,100000 | 8,3060 | 0,0000 | |

| 3 | 0,81917 | 0,100000 | 8,1917 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,92476 | 0,050257 | 18,4006 | 0,0000 | |

| Becker | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83838 | 0,100000 | 8,3838 | 0,0000 | |

| 3 | 0,80725 | 0,100000 | 8,0725 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,92462 | 0,050396 | 18,3473 | 0,0000 | |

| Ernst | 1 | 0,91159 | 0,100000 | 9,1159 | 0,0000 |

| 2 | 0,81035 | 0,100000 | 8,1035 | 0,0000 | |

| 3 | 0,72619 | 0,100000 | 7,2619 | 0,0000 | |

| 4 | 0,84919 | 0,100000 | 8,4919 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,86163 | 0,050500 | 17,0622 | 0,0000 | |

| Müller | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,91694 | 0,100000 | 9,1694 | 0,0000 | |

| 3 | 0,90736 | 0,100000 | 9,0736 | 0,0000 | |

| 4 | 0,92913 | 0,100000 | 9,2913 | 0,0000 | |

| 5 | 0,93502 | 0,100000 | 9,3502 | 0,0000 | |

| Gesamt | 0,93732 | 0,050211 | 18,6674 | 0,0000 |

Kendall-Korrelationskoeffizient

| Prüfer | Koef | SE Koef | z | p |

|---|---|---|---|---|

| Ahrens | 0,967386 | 0,0690066 | 14,0128 | 0,0000 |

| Becker | 0,967835 | 0,0690066 | 14,0193 | 0,0000 |

| Ernst | 0,951863 | 0,0690066 | 13,7879 | 0,0000 |

| Müller | 0,975168 | 0,0690066 | 14,1256 | 0,0000 |

Wichtigste Ergebnisse: Kappa, Kendall-Koeffizient der Korrelation

Die meisten Kappa-Werte sind größer als 0,80; dies weist auf eine gute Übereinstimmung der einzelnen Prüfer mit dem Standard hin. Einige Kappa-Werte liegen nahe 0,70; dies verweist darauf, dass Sie bestimmte Stichproben oder Prüfer möglicherweise eingehender untersuchen sollten. Da die Daten ordinal sind, gibt Minitab die Kendall-Koeffizienten der Korrelation aus. Diese Werte liegen im Bereich von 0,951863 bis 0,975168 und weisen auf eine starke Assoziation zwischen den Einstufungen und den Standardwerten hin.

Schritt 4: Einheitlichkeit der Einstufungen zwischen den einzelnen Prüfern auswerten

Um zu ermitteln, wie einheitlich die Einstufungen zwischen den Prüfern ausfallen, werten Sie die Kappa-Statistiken in der Tabelle „Zwischen Prüfern“ aus. Bei ordinalen Einstufungen sollten Sie außerdem den Kendall-Koeffizienten der Konkordanz betrachten.

Anhand der Kappa-Statistiken können Sie den Grad der Übereinstimmung der nominalen oder ordinalen Einstufungen mehrerer Prüfer ermitteln, wenn mehrere Prüfer dieselben Stichproben einstufen.

- Bei Kappa = 1 liegt eine vollkommene Übereinstimmung vor.

- Bei Kappa = 0 entspricht die Übereinstimmung der erwarteten zufälligen Übereinstimmung.

- Bei Kappa < 0 ist die Übereinstimmung geringer als die erwartete zufällige Übereinstimmung. Dies tritt jedoch sehr selten auf.

Laut der AIAG lässt ein Kappa-Wert von mindestens 0,75 auf eine gute Übereinstimmung schließen. Größere Kappa-Werte wie 0,90 sind jedoch vorzuziehen.

Wenn ordinale Einstufungen vorliegen, z. B. Bewertungen des Schweregrads von Fehlern auf einer Skala von 1 bis 5, stellen Kendall-Koeffizienten, bei denen die Reihenfolge berücksichtigt wird, meist eine besser geeignete Statistik zum Bestimmen der Assoziation als Kappa allein dar.

Hinweis

Bedenken Sie, dass die Tabelle „Zwischen Prüfern“ angibt, ob die Einstufungen der Prüfer einheitlich sind, jedoch nicht, ob die Einstufungen mit den Referenzwerten übereinstimmen. Einheitliche Einstufungen sind nicht unbedingt richtige Einstufungen.

Übereinstimmung der Bewertungen

| # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Fleiss-Kappa-Statistik

| Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,954392 | 0,0267261 | 35,7101 | 0,0000 |

| 2 | 0,827694 | 0,0267261 | 30,9695 | 0,0000 |

| 3 | 0,772541 | 0,0267261 | 28,9058 | 0,0000 |

| 4 | 0,891127 | 0,0267261 | 33,3429 | 0,0000 |

| 5 | 0,968148 | 0,0267261 | 36,2248 | 0,0000 |

| Gesamt | 0,881705 | 0,0134362 | 65,6218 | 0,0000 |

Kendall-Koeffizient der Konkordanz

| Koef | Chi-Qd | DF | p |

|---|---|---|---|

| 0,976681 | 382,859 | 49 | 0,0000 |

Wichtigste Ergebnisse: Kappa, Kendall-Koeffizient der Konkordanz

Alle Kappa-Werte sind größer als 0,77; dies weist auf eine minimal akzeptable Übereinstimmung zwischen den Prüfern hin. Die stärkste Übereinstimmung der Prüfer liegt bei den Stichproben 1 und 5 vor, während die geringste Übereinstimmung bei Stichprobe 3 festzustellen ist. Da die Daten ordinal sind, gibt Minitab den Kendall-Koeffizienten der Konkordanz (0,976681) aus, der auf eine äußerst starke Assoziation zwischen den Einstufungen der Prüfer hinweist.

Schritt 5: Richtigkeit der Antworten für alle Prüfer auswerten

Um die Richtigkeit der Einstufungen aller Prüfer auszuwerten, ziehen Sie die Kappa-Statistiken in der Tabelle „Alle Prüfer im Vergleich zum Standard“ heran. Bei ordinalen Einstufungen sollten Sie außerdem die Kendall-Koeffizienten der Konkordanz betrachten.

Anhand der Kappa-Statistiken können Sie den Grad der Übereinstimmung der nominalen oder ordinalen Einstufungen mehrerer Prüfer ermitteln, wenn mehrere Prüfer dieselben Stichproben einstufen.

- Bei Kappa = 1 liegt eine vollkommene Übereinstimmung vor.

- Bei Kappa = 0 entspricht die Übereinstimmung der erwarteten zufälligen Übereinstimmung.

- Bei Kappa < 0 ist die Übereinstimmung geringer als die erwartete zufällige Übereinstimmung. Dies tritt jedoch sehr selten auf.

Laut der AIAG lässt ein Kappa-Wert von mindestens 0,75 auf eine gute Übereinstimmung schließen. Größere Kappa-Werte wie 0,90 sind jedoch vorzuziehen.

Wenn ordinale Einstufungen vorliegen, z. B. Bewertungen des Schweregrads von Fehlern auf einer Skala von 1 bis 5, stellen Kendall-Koeffizienten, bei denen die Reihenfolge berücksichtigt wird, meist eine besser geeignete Statistik zum Bestimmen der Assoziation als Kappa allein dar.

Übereinstimmung der Bewertungen

| # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Fleiss-Kappa-Statistik

| Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,977897 | 0,0500000 | 19,5579 | 0,0000 |

| 2 | 0,849068 | 0,0500000 | 16,9814 | 0,0000 |

| 3 | 0,814992 | 0,0500000 | 16,2998 | 0,0000 |

| 4 | 0,944580 | 0,0500000 | 18,8916 | 0,0000 |

| 5 | 0,983756 | 0,0500000 | 19,6751 | 0,0000 |

| Gesamt | 0,912082 | 0,0251705 | 36,2362 | 0,0000 |

Kendall-Korrelationskoeffizient

| Koef | SE Koef | z | p |

|---|---|---|---|

| 0,965563 | 0,0345033 | 27,9817 | 0,0000 |

Wichtigste Ergebnisse: Kappa, Kendall-Koeffizient der Konkordanz

Diese Ergebnisse zeigen, dass bei 37 der 50 Stichproben die Einstufungen aller Prüfer den Standardeinstufungen entsprachen. Der Kappa-Gesamtwert beträgt 0,912082; dies weist auf eine starke Übereinstimmung mit den Standardwerten hin. Da die Daten ordinal sind, gibt Minitab den Kendall-Koeffizienten der Konkordanz (0,965563) aus, der auf eine starke Assoziation zwischen den Einstufungen und den Standardwerten hinweist.