Stoffprüfer in einem Textildruckunternehmen bewerten die Druckqualität für Baumwollstoffe auf einer Skala von 1 bis 5 Punkten. Der Qualitätstechniker möchte die Beständigkeit und Richtigkeit der Bewertungen der Prüfer untersuchen. Der Techniker fordert vier Prüfer auf, die Druckqualität von 50 Stoffstichproben in zufälliger Reihenfolge zweimal zu bewerten.

Da die Daten einen bekannten Standard für jede Stichprobe enthalten, kann der Qualitätstechniker die Beständigkeit und Richtigkeit der Bewertungen in Bezug auf den Standard sowie im Vergleich mit anderen Prüfern beurteilen.

- Öffnen Sie die Beispieldaten Textildruckqualität.MWX.

- Wählen Sie aus.

- Wählen Sie im Feld Anordnung der Daten die Option Attributspalte aus, und geben Sie Antwort ein.

- Geben Sie im Feld Stichproben die Spalte Stichprobe ein.

- Geben Sie im Feld Prüfer die Spalte Prüfer ein.

- Geben Sie im Feld Bekannter Standard/Attribut die Spalte Standard ein.

- Wählen Sie Kategorien der Attributdaten sind geordnet aus.

- Klicken Sie auf OK.

Interpretieren der Ergebnisse

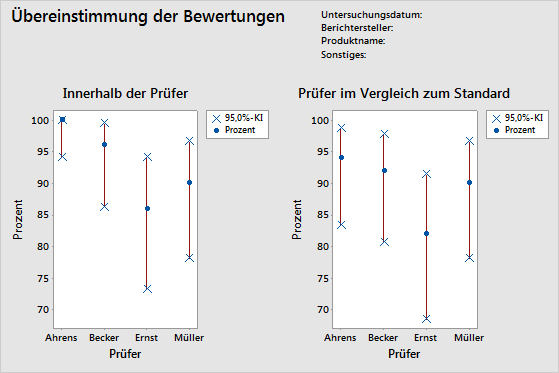

- Tabelle „Innerhalb der Prüfer“

- Da jeder Prüfer mindestens zwei Einstufungen für jede Stichprobe abgibt, kann der Techniker die Beständigkeit jedes Prüfers auswerten.

- Tabelle „Jeder Prüfer im Vergleich zum Standard“

- Da ein bekannter Standard für jede Stichprobe vorliegt, kann der Techniker die Genauigkeit und Beständigkeit der Einstufungen eines bestimmten Prüfers bewerten.

- Tabelle „Zwischen Prüfern“

- In der Tabelle „Zwischen Prüfern“ wird verdeutlicht, dass die Prüfer bei 37 der 50 Stichproben in ihren Einstufungen übereinstimmen.

- Tabelle „Alle Prüfer im Vergleich zum Standard“

- Da ein bekannter Standard für jede Stichprobe vorliegt, kann der Techniker die Genauigkeit der Einstufungen aller Prüfer bewerten.

Hinweis

Der p-Wert von 0,0000 in der Ausgabe ist gerundet. Sie können jedoch mit Sicherheit folgern, dass der p-Wert sehr klein und < 0,00005 ist.

Übereinstimmung der Bewertungen

| Prüfer | # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|---|

| Ahrens | 50 | 50 | 100,00 | (94,18; 100,00) |

| Becker | 50 | 48 | 96,00 | (86,29; 99,51) |

| Ernst | 50 | 43 | 86,00 | (73,26; 94,18) |

| Müller | 50 | 45 | 90,00 | (78,19; 96,67) |

Fleiss-Kappa-Statistik

| Prüfer | Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|---|

| Ahrens | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 3 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 1,00000 | 0,071052 | 14,0741 | 0,0000 | |

| Becker | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,89605 | 0,141421 | 6,3360 | 0,0000 | |

| 3 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 0,94965 | 0,071401 | 13,3002 | 0,0000 | |

| Ernst | 1 | 0,83060 | 0,141421 | 5,8733 | 0,0000 |

| 2 | 0,84000 | 0,141421 | 5,9397 | 0,0000 | |

| 3 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 4 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Gesamt | 0,82354 | 0,071591 | 11,5034 | 0,0000 | |

| Müller | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,83060 | 0,141421 | 5,8733 | 0,0000 | |

| 3 | 0,81917 | 0,141421 | 5,7924 | 0,0000 | |

| 4 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 5 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| Gesamt | 0,87472 | 0,070945 | 12,3295 | 0,0000 |

Kendall-Koeffizient der Konkordanz

| Prüfer | Koef | Chi-Qd | DF | p |

|---|---|---|---|---|

| Ahrens | 1,00000 | 98,0000 | 49 | 0,0000 |

| Becker | 0,99448 | 97,4587 | 49 | 0,0000 |

| Ernst | 0,98446 | 96,4769 | 49 | 0,0001 |

| Müller | 0,98700 | 96,7256 | 49 | 0,0001 |

Übereinstimmung der Bewertungen

| Prüfer | # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|---|

| Ahrens | 50 | 47 | 94,00 | (83,45; 98,75) |

| Becker | 50 | 46 | 92,00 | (80,77; 97,78) |

| Ernst | 50 | 41 | 82,00 | (68,56; 91,42) |

| Müller | 50 | 45 | 90,00 | (78,19; 96,67) |

Fleiss-Kappa-Statistik

| Prüfer | Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|---|

| Ahrens | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83060 | 0,100000 | 8,3060 | 0,0000 | |

| 3 | 0,81917 | 0,100000 | 8,1917 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,92476 | 0,050257 | 18,4006 | 0,0000 | |

| Becker | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83838 | 0,100000 | 8,3838 | 0,0000 | |

| 3 | 0,80725 | 0,100000 | 8,0725 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,92462 | 0,050396 | 18,3473 | 0,0000 | |

| Ernst | 1 | 0,91159 | 0,100000 | 9,1159 | 0,0000 |

| 2 | 0,81035 | 0,100000 | 8,1035 | 0,0000 | |

| 3 | 0,72619 | 0,100000 | 7,2619 | 0,0000 | |

| 4 | 0,84919 | 0,100000 | 8,4919 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Gesamt | 0,86163 | 0,050500 | 17,0622 | 0,0000 | |

| Müller | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,91694 | 0,100000 | 9,1694 | 0,0000 | |

| 3 | 0,90736 | 0,100000 | 9,0736 | 0,0000 | |

| 4 | 0,92913 | 0,100000 | 9,2913 | 0,0000 | |

| 5 | 0,93502 | 0,100000 | 9,3502 | 0,0000 | |

| Gesamt | 0,93732 | 0,050211 | 18,6674 | 0,0000 |

Kendall-Korrelationskoeffizient

| Prüfer | Koef | SE Koef | z | p |

|---|---|---|---|---|

| Ahrens | 0,967386 | 0,0690066 | 14,0128 | 0,0000 |

| Becker | 0,967835 | 0,0690066 | 14,0193 | 0,0000 |

| Ernst | 0,951863 | 0,0690066 | 13,7879 | 0,0000 |

| Müller | 0,975168 | 0,0690066 | 14,1256 | 0,0000 |

Übereinstimmung der Bewertungen

| # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Fleiss-Kappa-Statistik

| Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,954392 | 0,0267261 | 35,7101 | 0,0000 |

| 2 | 0,827694 | 0,0267261 | 30,9695 | 0,0000 |

| 3 | 0,772541 | 0,0267261 | 28,9058 | 0,0000 |

| 4 | 0,891127 | 0,0267261 | 33,3429 | 0,0000 |

| 5 | 0,968148 | 0,0267261 | 36,2248 | 0,0000 |

| Gesamt | 0,881705 | 0,0134362 | 65,6218 | 0,0000 |

Kendall-Koeffizient der Konkordanz

| Koef | Chi-Qd | DF | p |

|---|---|---|---|

| 0,976681 | 382,859 | 49 | 0,0000 |

Übereinstimmung der Bewertungen

| # Geprüft | # Übereinstimmungen | Prozent | 95%-KI |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Fleiss-Kappa-Statistik

| Antwort | Kappa | SE Kappa | z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,977897 | 0,0500000 | 19,5579 | 0,0000 |

| 2 | 0,849068 | 0,0500000 | 16,9814 | 0,0000 |

| 3 | 0,814992 | 0,0500000 | 16,2998 | 0,0000 |

| 4 | 0,944580 | 0,0500000 | 18,8916 | 0,0000 |

| 5 | 0,983756 | 0,0500000 | 19,6751 | 0,0000 |

| Gesamt | 0,912082 | 0,0251705 | 36,2362 | 0,0000 |

Kendall-Korrelationskoeffizient

| Koef | SE Koef | z | p |

|---|---|---|---|

| 0,965563 | 0,0345033 | 27,9817 | 0,0000 |