什么是回归分析?

回归分析生成方程以描述一个或多个预测变量与响应变量之间的统计学关系,并预测新观测值。线性回归一般使用通过使平方残差之和最小化来导出方程的普通最小二乘估计法。

例如,您为一家薯片公司工作,该公司正在分析发货前影响每个包装内碎薯片百分比的因子(响应变量)。您正在进行回归分析,并以马铃薯相对其他成分的百分比和加工温度(摄氏度)作为两个预测变量。下面是结果表格。

回归分析: 碎薯片 与 马铃薯百分比, 加工温度

方差分析

来源 自由度 Adj SS Adj MS F 值 P 值

回归 2 0.62783 0.31392 23.72 0.000

马铃薯百分比 1 0.09958 0.09958 7.53 0.011

加工温度 1 0.59643 0.59643 45.07 0.000

误差 24 0.31759 0.01323

合计 26 0.94542

模型汇总

R-sq(调 R-sq(预

S R-sq 整) 测)

0.115034 66.41% 63.61% 57.96%

系数

方差膨

项 系数 系数标准误 T 值 P 值 胀因子

常量 4.251 0.659 6.45 0.000

马铃薯百分比 -0.909 0.331 -2.74 0.011 1.03

加工温度 0.02231 0.00332 6.71 0.000 1.03

回归方程

碎薯片 = 4.251 - 0.909 马铃薯百分比 + 0.02231 加工温度

异常观测值的拟合和诊断

标准化

观测值 碎薯片 拟合值 残差 残差

6 7.9575 7.7255 0.2320 2.12 R

21 8.3949 8.1342 0.2607 2.44 R

25 8.1355 7.9051 0.2304 2.04 R

R 残差大

回归结果表明,两个预测变量都显著,因为它们的 p 值都很低。这两个预测变量可以解释 66.41% 的碎薯片方差。具体来说:

- 加工温度每增加 1 摄氏度,碎薯片百分比预期会增加 0.022%。

- 为了预测马铃薯含量为 0.5 (50%) 且加工温度为 175 °C 时的碎薯片百分比,您计算出碎薯片的预期值为 7.7%:4.251 - 0.909 * 0.5 + 0.2231 * 175 = 7.70075。

回归结果可以确定预测变量与响应变量间关系的方向、大小和统计显著性。

- 每个系数的符号表明关系的方向。

- 系数表示保持模型中其他预测变量恒定时,预测变量的单位变化导致的响应平均变化。

- 每个系数的 P 值检验系数等于零(无效应)这一原假设。因此,较低的 p 值表示预测变量对模型而言是有意义的补充。

- 方程在给定预测变量值的情况下预测新观测值。

注意

含有一个预测变量的模型被称为简单回归。含有多个预测变量的模型被称为多元线性回归。

什么是简单线性回归?

简单线性回归检查两个连续变量之间的线性关系:一个响应变量 (y) 和一个预测变量 (x)。当这两个变量相关时,可以从几率准确性更好的预测变量值预测出响应值。

回归可以提供与数据拟合效果“最佳”的线。然后可将这条线用于:

- 检查响应变量如何随预测变量的变化而变化。

- 预测任一预测变量 (x) 的响应变量 (y) 的值。

什么是多元线性回归?

多元线性回归检查一个连续响应与两个或更多个预测变量之间的线性关系。

如果预测变量的数量很大,则在用所有预测变量拟合回归模型之前,应使用逐步或最佳子集模型选择技术筛除与响应无关的预测变量。

什么是普通最小二乘回归?

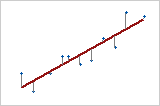

在普通最小二乘 (OLS) 回归中,估计方程可通过确定将样本的数据点与由方程预测的值之间的距离平方和最小化的方程计算得出。

响应与 自变量

在只有一个预测变量(简单线性回归)的情况下,每个点与线之间的距离平方和会尽可能小。

应该满足的 OLS 回归假设

仅当满足以下假设时,OLS 回归才会提供最精确的无偏估计值:

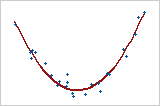

- 回归模型的系数为线性系数。最小二乘可通过变换变量(而不是系数)来为弯曲建模。您必须指定正确的函数形式才能正确地为任何弯曲建模。

二次模型

在此,对预测变量 X 进行了平方计算以便为弯曲建模。Y = bo + b1X + b2X2

- 残差的均值为零。模型中包含常量将迫使均值等于零。

- 所有预测变量都与残差不相关。

- 残差与残差之间不相关(序列相关)。

- 残差具有恒定方差。

- 任何预测变量都不与其他预测变量完全相关 (r=1)。最好也避免不完全的高度相关(多重共线性)。

- 残差呈正态分布。

由于仅当所有这些假定都满足时,OLS 回归才会提供最佳估计值,因此检验这些假定非常重要。常用方法包括检查残差图、使用失拟检验以及使用方差膨胀因子 (VIF) 查看预测变量之间的相关性。