关于本主题

步骤 1:以直观方式评估检验员一致性

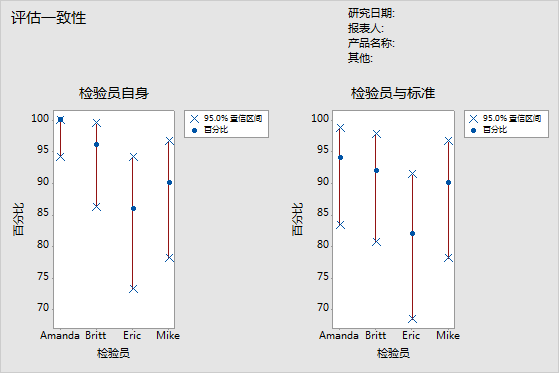

要确定每位检验员评级的一致性,请评估“检验员自身”图。对于每位检验员,将匹配百分比(蓝圈)与匹配百分比的置信区间(红线)进行比较。

要确定每位检验员评级的正确性,请评估“每位检验员与标准”图。对于每位检验员,将匹配百分比(蓝圈)与匹配百分比的置信区间(红线)进行比较。

注意

仅当存在多个试验时,Mnitab 才会显示“检验员自身”图。

此“检验员自身”图显示 Amanda 的评级一致性最高,Eric 的评级一致性最低。“检验员与标准”图显示 Amanda 的评级正确性最高,Eric 的评级正确性最低。

第 2 步:评估每位评估员的响应的一致性

要确定每位评估员评级的一致性,请评估“评估员自身”表格中的 kappa 统计数据。如果是顺序评级,您还应评估 Kendall 的一致性系数。Minitab 会在每位评估员对一个项目评估多次时显示评估员自身表格。

当多位评估员评估相同的样本时,可使用 kappa 统计数据评估由多位评估员给出的名义或顺序评级的一致程度。

- Kappa = 1 时,表明完全一致。

- Kappa = 0 时,则一致性与偶然预期的相同。

- Kappa < 0 时,一致性比偶然预期的还要弱,不过这种情况很少发生。

AIAG 建议,kappa 最小值为 0.75 时表示一致性良好。但是 kappa 值越大越好,例如 0.90。

当进行顺序评级时(比如按 1 到 5 个等级对缺陷严重性进行评定),可说明排序因素的 Kendall 系数通常比单独使用 kappa 更适合用来确定关联度。

注意

切记,“评估员自身”表格可表示评估员的评级是否一致,但无法表示评级是否与参考值一致。一致的评级不一定是正确的评级。

评估一致性

| 检验员 | # 检验数 | # 相符数 | 百分比 | 95% 置信区间 |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100.00 | (94.18, 100.00) |

| Britt | 50 | 48 | 96.00 | (86.29, 99.51) |

| Eric | 50 | 43 | 86.00 | (73.26, 94.18) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Fleiss 的 Kappa 统计量

| 检验员 | 响应 | Kappa | Kappa 标准误 | Z | P(与 > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 3 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 整体 | 1.00000 | 0.071052 | 14.0741 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.89605 | 0.141421 | 6.3360 | 0.0000 | |

| 3 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 整体 | 0.94965 | 0.071401 | 13.3002 | 0.0000 | |

| Eric | 1 | 0.83060 | 0.141421 | 5.8733 | 0.0000 |

| 2 | 0.84000 | 0.141421 | 5.9397 | 0.0000 | |

| 3 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 4 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 整体 | 0.82354 | 0.071591 | 11.5034 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.83060 | 0.141421 | 5.8733 | 0.0000 | |

| 3 | 0.81917 | 0.141421 | 5.7924 | 0.0000 | |

| 4 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 5 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 整体 | 0.87472 | 0.070945 | 12.3295 | 0.0000 |

Kendall 的一致性系数

| 检验员 | 系数 | 卡方 | 自由度 | P |

|---|---|---|---|---|

| Amanda | 1.00000 | 98.0000 | 49 | 0.0000 |

| Britt | 0.99448 | 97.4587 | 49 | 0.0000 |

| Eric | 0.98446 | 96.4769 | 49 | 0.0001 |

| Mike | 0.98700 | 96.7256 | 49 | 0.0001 |

重要结果:Kappa、Kendall 的一致性系数

多个 kappa 值为 1,表示评估员自身对多次试验的评级完全一致。Eric 的部分 kappa 值接近 0.70。您可能需要研究 Eric 对这些样本的评级为何不一致。由于这些数据是顺序响应,因此 Minitab 会提供 Kendall 的一致性系数值。这些值全都大于 0.98,表示评估员自身评级的关联度很高。

第 3 步:评估每位评估员的响应的正确性

要确定每位评估员评级的正确性,请评估“每位评估员与标准”表格中的 kappa 统计数据。如果是顺序评级,您还应评估 Kendall 的相关系数。Minitab 会在您指定每个样本的参考值时显示“每位评估员与标准表格”。

当多位评估员评估相同的样本时,可使用 kappa 统计数据评估由多位评估员给出的名义或顺序评级的一致程度。

- Kappa = 1 时,表明完全一致。

- Kappa = 0 时,则一致性与偶然预期的相同。

- Kappa < 0 时,一致性比偶然预期的还要弱,不过这种情况很少发生。

AIAG 建议,kappa 最小值为 0.75 时表示一致性良好。但是 kappa 值越大越好,例如 0.90。

当进行顺序评级时(比如按 1 到 5 个等级对缺陷严重性进行评定),可说明排序因素的 Kendall 系数通常比单独使用 kappa 更适合用来确定关联度。

评估一致性

| 检验员 | # 检验数 | # 相符数 | 百分比 | 95% 置信区间 |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94.00 | (83.45, 98.75) |

| Britt | 50 | 46 | 92.00 | (80.77, 97.78) |

| Eric | 50 | 41 | 82.00 | (68.56, 91.42) |

| Mike | 50 | 45 | 90.00 | (78.19, 96.67) |

Fleiss 的 Kappa 统计量

| 检验员 | 响应 | Kappa | Kappa 标准误 | Z | P(与 > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83060 | 0.100000 | 8.3060 | 0.0000 | |

| 3 | 0.81917 | 0.100000 | 8.1917 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 整体 | 0.92476 | 0.050257 | 18.4006 | 0.0000 | |

| Britt | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83838 | 0.100000 | 8.3838 | 0.0000 | |

| 3 | 0.80725 | 0.100000 | 8.0725 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 整体 | 0.92462 | 0.050396 | 18.3473 | 0.0000 | |

| Eric | 1 | 0.91159 | 0.100000 | 9.1159 | 0.0000 |

| 2 | 0.81035 | 0.100000 | 8.1035 | 0.0000 | |

| 3 | 0.72619 | 0.100000 | 7.2619 | 0.0000 | |

| 4 | 0.84919 | 0.100000 | 8.4919 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 整体 | 0.86163 | 0.050500 | 17.0622 | 0.0000 | |

| Mike | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.91694 | 0.100000 | 9.1694 | 0.0000 | |

| 3 | 0.90736 | 0.100000 | 9.0736 | 0.0000 | |

| 4 | 0.92913 | 0.100000 | 9.2913 | 0.0000 | |

| 5 | 0.93502 | 0.100000 | 9.3502 | 0.0000 | |

| 整体 | 0.93732 | 0.050211 | 18.6674 | 0.0000 |

Kendall 的相关系数

| 检验员 | 系数 | 系数标准误 | Z | P |

|---|---|---|---|---|

| Amanda | 0.967386 | 0.0690066 | 14.0128 | 0.0000 |

| Britt | 0.967835 | 0.0690066 | 14.0193 | 0.0000 |

| Eric | 0.951863 | 0.0690066 | 13.7879 | 0.0000 |

| Mike | 0.975168 | 0.0690066 | 14.1256 | 0.0000 |

重要结果:Kappa、Kendall 的相关系数

大部分 kappa 值大于 0.80,表示每位评估员与标准之间的一致性良好。少数 kappa 值接近 0.70,表示您可能需要进一步研究某些样本或某些评估员。由于这些数据是顺序响应,因此 Minitab 会提供 Kendall 的相关系数。这些值的范围为 0.951863 到 0.975168,这表示评级和标准值之间的关联度很高。

第 4 步:评估评估员之间的响应的一致性

要确定评估员评级之间的一致性,请评估“评估员之间”表格中的 kappa 统计数据。如果是顺序评级,您还应评估 Kendall 的一致性系数。

当多位评估员评估相同的样本时,可使用 kappa 统计数据评估由多位评估员给出的名义或顺序评级的一致程度。

- Kappa = 1 时,表明完全一致。

- Kappa = 0 时,则一致性与偶然预期的相同。

- Kappa < 0 时,一致性比偶然预期的还要弱,不过这种情况很少发生。

AIAG 建议,kappa 最小值为 0.75 时表示一致性良好。但是 kappa 值越大越好,例如 0.90。

当进行顺序评级时(比如按 1 到 5 个等级对缺陷严重性进行评定),可说明排序因素的 Kendall 系数通常比单独使用 kappa 更适合用来确定关联度。

注意

切记,“评估员之间”表格可表示评估员的评级是否一致,但无法表示评级是否与参考值一致。一致的评级不一定是正确的评级。

评估一致性

| # 检验数 | # 相符数 | 百分比 | 95% 置信区间 |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Fleiss 的 Kappa 统计量

| 响应 | Kappa | Kappa 标准误 | Z | P(与 > 0) |

|---|---|---|---|---|

| 1 | 0.954392 | 0.0267261 | 35.7101 | 0.0000 |

| 2 | 0.827694 | 0.0267261 | 30.9695 | 0.0000 |

| 3 | 0.772541 | 0.0267261 | 28.9058 | 0.0000 |

| 4 | 0.891127 | 0.0267261 | 33.3429 | 0.0000 |

| 5 | 0.968148 | 0.0267261 | 36.2248 | 0.0000 |

| 整体 | 0.881705 | 0.0134362 | 65.6218 | 0.0000 |

Kendall 的一致性系数

| 系数 | 卡方 | 自由度 | P |

|---|---|---|---|

| 0.976681 | 382.859 | 49 | 0.0000 |

重要结果:Kappa、Kendall 的一致性系数

所有 kappa 值都大于 0.77,表示评估员之间的一致性接受程度最低。评估员对样本 1 和 5 的评估一致性最高,样本 3 的一致性最低。由于这些数据是顺序响应,因此 Minitab 会提供 Kendall 一致性系数 (0.976681),这表示评估员评级之间的关联度很高。

第 5 步:评估所有评估员的响应的正确性

要确定所有评估员评级的正确性,请评估“所有评估员与标准”表格中的 kappa 统计数据。如果是顺序评级,您还应评估 Kendall 的一致性系数。

当多位评估员评估相同的样本时,可使用 kappa 统计数据评估由多位评估员给出的名义或顺序评级的一致程度。

- Kappa = 1 时,表明完全一致。

- Kappa = 0 时,则一致性与偶然预期的相同。

- Kappa < 0 时,一致性比偶然预期的还要弱,不过这种情况很少发生。

AIAG 建议,kappa 最小值为 0.75 时表示一致性良好。但是 kappa 值越大越好,例如 0.90。

当进行顺序评级时(比如按 1 到 5 个等级对缺陷严重性进行评定),可说明排序因素的 Kendall 系数通常比单独使用 kappa 更适合用来确定关联度。

评估一致性

| # 检验数 | # 相符数 | 百分比 | 95% 置信区间 |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Fleiss 的 Kappa 统计量

| 响应 | Kappa | Kappa 标准误 | Z | P(与 > 0) |

|---|---|---|---|---|

| 1 | 0.977897 | 0.0500000 | 19.5579 | 0.0000 |

| 2 | 0.849068 | 0.0500000 | 16.9814 | 0.0000 |

| 3 | 0.814992 | 0.0500000 | 16.2998 | 0.0000 |

| 4 | 0.944580 | 0.0500000 | 18.8916 | 0.0000 |

| 5 | 0.983756 | 0.0500000 | 19.6751 | 0.0000 |

| 整体 | 0.912082 | 0.0251705 | 36.2362 | 0.0000 |

Kendall 的相关系数

| 系数 | 系数标准误 | Z | P |

|---|---|---|---|

| 0.965563 | 0.0345033 | 27.9817 | 0.0000 |

重要结果:Kappa、Kendall 的一致性系数

这些结果显示,所有评估员对 50 个样本中的 37 个的标准评级是正确匹配的。整体的 kappa 值为 0.912082,表示标准值的一致性很强。由于这些数据是顺序响应,因此 Minitab 会提供 Kendall 的一致性系数 (0.965563),这表示评级和标准值之间的关联度很高。