Observação

Este comando está disponível com o Módulo de análise preditiva. Clique aqui saber mais sobre como ativar o módulo.

Observação

O Minitab exibe resultados ambos os conjuntos de dados: de treinamento e de teste. Os resultados dos testes indicam se o modelo consegue predizer adequadamente os valores de resposta para novas observações, ou resumir adequadamente as relações entre a resposta e as variáveis preditoras. Use os resultados do treinamento para avaliar o sobreajuste do modelo.

Preditores totais

O número de preditores totais disponíveis para a modelo do TreeNet®. O total é a soma dos preditores contínuos e categóricos especificados por você.

Preditores importantes

O número de preditores importantes no modelo do TreeNet®. Os preditores importantes têm pontuações de importância maiores que 0,0. Você pode usar a carta de Importância Relativa da Variável para exibir a ordem de importância relativa da variável. Por exemplo, suponha que 10 dos 20 preditores sejam importantes no modelo, a carta de Importância Relativa da Variável exibe as variáveis em ordem de importância.

Número de árvores cultivadas

Por padrão, o Minitab cultiva 300 árvores CART® pequenas para produzir o modelo do TreeNet®. Embora esse valor funcione bem para a exploração dos dados, considere se deve cultivar mais árvores para produzir um modelo final. Para alterar o número de árvores cultivadas, vá para a subcaixa de diálogo Opções.

Número ótimo de árvores

O número ótimo de árvores corresponde ao maior valor de R2 ou ao menor valor de DAM.

Quando o número ótimo de árvores está próximo do número máximo de árvores cultivadas pelo modelo, considere uma análise com mais árvores. Assim, se você cultivar 300 árvores e o número ótimo voltar como 298, recrie o modelo com mais árvores. Se o número ótimo continuar próximo ao número máximo, continue aumentando o número de árvores.

R-quadrado

R2 é a porcentagem de variação na resposta que o modelo explica. Os outliers têm um efeito maior no R2 do que no DAM e MAPE.

Quando você usa um método de validação, a tabela inclui uma estatística R2 para o conjunto de dados de treinamento e uma estatística R2 para o conjunto de dados de teste. Quando o método de validação é uma validação cruzada de K dobras, o conjunto de dados de teste é cada dobra quando a construção do modelo exclui essa dobra. Normalmente, a estatística do teste R2 é uma medida melhor de como o modelo funciona para novos dados.

Interpretação

Use o R2 para determinar se o modelo ajusta bem seus dados. Quanto maior o valor R2, melhor o modelo ajusta seus dados. R2 está sempre entre 0% e 100%.

Um teste R2 substancialmente menor do que o R2 de treinamento indica que o modelo pode não predizer os valores de resposta para novos casos tão bem quanto o modelo ajusta o conjunto de dados atual.

Raiz do quadrado médio do erro (RMSE)

A raiz do quadrado médio do erro (RMSE) mede a exatidão do modelo. Os outliers exercem um efeito maior sobre o RMSE do que sobre o DAM e o MAPE.

Quando você usa um método de validação, a tabela inclui uma estatística RMSE para o conjunto de dados de treinamento e uma estatística RMSE para o conjunto de dados de teste. Quando o método de validação é uma validação cruzada de K dobras, o conjunto de dados de teste é cada dobra quando a construção do modelo exclui essa dobra. Normalmente, a estatística do teste RMSE é uma medida melhor de como o modelo funciona para novos dados.

Interpretação

Use para comparar os ajustes de modelos diferentes. Valores menores indicam um ajuste melhor. Um teste RMSE substancialmente maior do que o RMSE de treinamento indica que o modelo pode não predizer os valores de resposta para novos casos tão bem quanto o modelo ajusta o conjunto de dados atual.

Erro quadrado médio (MSE)

O erro quadrado médio (MSE) mede a exatidão do modelo. Os outliers exercem um efeito maior sobre o MSE do que sobre o DAM e o MAPE.

Quando você usa um método de validação, a tabela inclui uma estatística MSE para o conjunto de dados de treinamento e uma estatística MSE para o conjunto de dados de teste. Quando o método de validação é uma validação cruzada de K dobras, o conjunto de dados de teste é cada dobra quando a construção do modelo exclui essa dobra. Normalmente, a estatística do teste MSE é uma medida melhor de como o modelo funciona para novos dados.

Interpretação

Use para comparar os ajustes de modelos diferentes. Valores menores indicam um ajuste melhor. Um teste MSE substancialmente maior do que o MSE de treinamento indica que o modelo pode não predizer os valores de resposta para novos casos tão bem quanto o modelo ajusta o conjunto de dados atual.

Desvio absoluto médio (DAM)

O desvio absoluto médio (DAM) expressa exatidão nas mesmas unidades que os dados, o que ajuda a conceituar a quantidade de erro. Os outliers têm menos efeito sobre o DAM do que sobre o R2, RMSE e MSE.

Quando você usa um método de validação, a tabela inclui uma estatística DAM para o conjunto de dados de treinamento e uma estatística DAM para o conjunto de dados de teste. Quando o método de validação é uma validação cruzada de K dobras, o conjunto de dados de teste é cada dobra quando a construção do modelo exclui essa dobra. Normalmente, a estatística do teste DAM é uma medida melhor de como o modelo funciona para novos dados.

Interpretação

Use para comparar os ajustes de modelos diferentes. Valores menores indicam um ajuste melhor. Um teste DAM substancialmente maior do que o DAM de treinamento indica que o modelo pode não predizer os valores de resposta para novos casos tão bem quanto o modelo ajusta o conjunto de dados atual.

Erro percentual absoluto médio (MAPE)

O erro percentual absoluto médio (MAPE) expressa exatidão como um percentual do erro. Como o MAPE é um percentual, pode ser mais fácil de entender do que a outra estatística de medida de exatidão. Por exemplo, se o MAPE, em média, é de 0,05, então a relação média entre o erro ajustado e o valor real em todos os casos é de 5%. Os outliers têm menos efeito sobre o MAPE do que sobre o R2, RMSE e MSE.

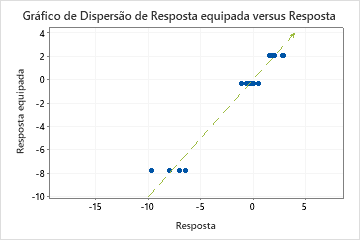

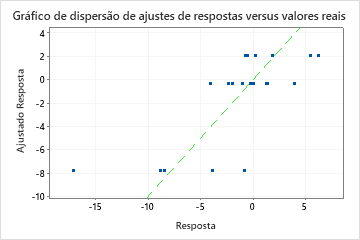

No entanto, às vezes você pode ver um valor MAPE muito grande, mesmo que o modelo pareça ajustar bem os dados. Examine o gráfico de valor de resposta ajustado versus real para ver se algum dos valores de dados estão próximos de 0. Como o MAPE divide o erro absoluto pelos dados reais, os valores próximos a 0 podem inflar muito o MAPE.

Quando você usa um método de validação, a tabela inclui uma estatística MAPE para o conjunto de dados de treinamento e uma estatística MAPE para o conjunto de dados de teste. Quando o método de validação é uma validação cruzada de K dobras, o conjunto de dados de teste é cada dobra quando a construção do modelo exclui essa dobra. Normalmente, a estatística do teste MAPE é uma medida melhor de como o modelo funciona para novos dados.

Interpretação

Use para comparar os ajustes de modelos diferentes. Valores menores indicam um ajuste melhor. Um teste MAPE substancialmente maior do que o MAPE de treinamento indica que o modelo pode não predizer os valores de resposta para novos casos tão bem quanto o modelo ajusta o conjunto de dados atual.