Neste tópico

- Etapa 1: Avaliar a concordância do avaliador visualmente

- Etapa 2: Avaliar a consistência das repostas para cada avaliador

- Etapa 3: Avaliar a precisão das repostas para cada avaliador

- Etapa 4: Avaliar a consistência de respostas entre avaliadores

- Etapa 5: Avaliar a precisão das repostas para todos os avaliadores

Etapa 1: Avaliar a concordância do avaliador visualmente

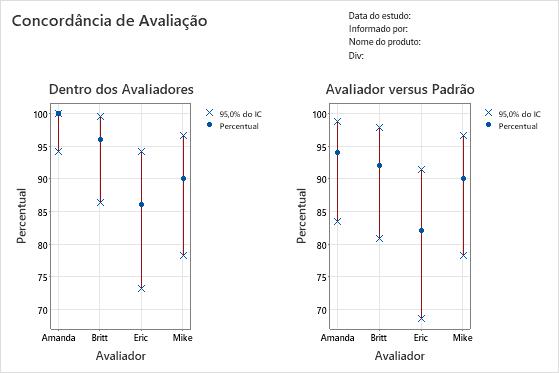

Para determinar a consistência de cada classificação do avaliador, avalie o gráfico Entre Avaliadores. Compare o percentual correspondido (círculo azul) com o intervalo de confiança para o percentual correspondido (linha vermelha) para cada avaliador.

Para determinar a exatidão de cada classificação do avaliador, avalie o gráfico Avaliador vs Padrão. Compare o percentual correspondido (círculo azul) com o intervalo de confiança para o percentual correspondido (linha vermelha) para cada avaliador.

Observação

O Minitab exibe o gráfico Entre Avaliadores apenas quando houver vários ensaios.

Este gráfico dentro dos avaliadores indica que Amanda tem as classificações mais consistentes e Eric tem as classificações menos consistentes. O gráfico avaliador vs padrão indica que Amanda tem as classificações mais corretas e Eric tem as classificações menos corretas.

Etapa 2: Avaliar a consistência das repostas para cada avaliador

Para determinar a consistência de cada classificação do avaliador, avalie as estatísticas de kappa na tabela Nos Avaliadores. Quando as classificações forem ordinais, você deve avaliar também coeficientes de concordância de Kendall. O Minitab exibe a tabela Nos do Avaliadores quando cada avaliador classifica um item mais de uma vez.

Use as estatísticas kappa para avaliar o grau de concordância das classificações nominais ou ordinais feitas por vários avaliadores quando os avaliadores avaliarem as mesmas amostras.

- Quando kappa = 1, existe uma concordância perfeita.

- Quando kappa = 0, a concordância é aquela que seria esperada ao acaso.

- Quando kappa < 0, a concordância é mais fraca do que seria esperado ao acaso, o que raramente ocorre.

A AIAG sugere que um valor de kappa de pelo menos 0,75 indica uma boa concordância. No entanto, valores kappa maiores, como 0,90 como, são preferíveis.

Com classificações ordinais, como a classificação da gravidade de defeitos em uma escala de 1 a 5, os coeficientes de Kendall, que são responsáveis pela ordenação, são geralmente estatísticas mais apropriadas para determinar a associação do que apenas kappa.

Observação

Lembre-se de que a tabela de Nos Avaliadores indica se classificações dos avaliadores são consistentes, mas não se as classificações concordam com os valores de referência. Classificações consistentes não são necessariamente classificações corretas.

Concordância de Avaliação

| Avaliador | Nº de Inspecionados | Nº de Correspondências | Percentual | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100,00 | (94,18; 100,00) |

| Britt | 50 | 48 | 96,00 | (86,29; 99,51) |

| Eric | 50 | 43 | 86,00 | (73,26; 94,18) |

| Mike | 50 | 45 | 90,00 | (78,19; 96,67) |

Estatísticas de Kappa de Fleiss

| Avaliador | Resposta | Kappa | EP de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 3 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 1,00000 | 0,071052 | 14,0741 | 0,0000 | |

| Britt | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,89605 | 0,141421 | 6,3360 | 0,0000 | |

| 3 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,94965 | 0,071401 | 13,3002 | 0,0000 | |

| Eric | 1 | 0,83060 | 0,141421 | 5,8733 | 0,0000 |

| 2 | 0,84000 | 0,141421 | 5,9397 | 0,0000 | |

| 3 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 4 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,82354 | 0,071591 | 11,5034 | 0,0000 | |

| Mike | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,83060 | 0,141421 | 5,8733 | 0,0000 | |

| 3 | 0,81917 | 0,141421 | 5,7924 | 0,0000 | |

| 4 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 5 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| Global | 0,87472 | 0,070945 | 12,3295 | 0,0000 |

Coeficiente de Concordância de Kendall

| Avaliador | Coef | Qui-Quadrado | GL | P |

|---|---|---|---|---|

| Amanda | 1,00000 | 98,0000 | 49 | 0,0000 |

| Britt | 0,99448 | 97,4587 | 49 | 0,0000 |

| Eric | 0,98446 | 96,4769 | 49 | 0,0001 |

| Mike | 0,98700 | 96,7256 | 49 | 0,0001 |

Resultados chave: Kappa, coeficiente de concordância de Kendall

Muitos dos valores de kappa são 1, que indica uma concordância perfeita dentro de um avaliador entre ensaios. Alguns dos valores de kappa de Eric estão perto de 0,70. Talvez você queira investigar a razão pela qual as classificações de Eric daquelas amostras estavam inconsistentes. Como os dados são ordinais, o Minitab fornece os valores de coeficiente de concordância de Kendall. Estes valores são todos superiores a 0,98, o que indica uma associação muito forte dentro das classificações do avaliador.

Etapa 3: Avaliar a precisão das repostas para cada avaliador

Para determinar a precisão de cada classificação do avaliador, avalie as estatísticas de kappa na tabela Cada avaliador x padrão. Quando as classificações forem ordinais, você deve avaliar também coeficientes de correlação de Kendall. O Minitab exibe a tabela Cada avaliador x padrão — avaliação da concordância exibe quando você especifica um valor de referência para cada amostra.

Use as estatísticas kappa para avaliar o grau de concordância das classificações nominais ou ordinais feitas por vários avaliadores quando os avaliadores avaliarem as mesmas amostras.

- Quando kappa = 1, existe uma concordância perfeita.

- Quando kappa = 0, a concordância é aquela que seria esperada ao acaso.

- Quando kappa < 0, a concordância é mais fraca do que seria esperado ao acaso, o que raramente ocorre.

A AIAG sugere que um valor de kappa de pelo menos 0,75 indica uma boa concordância. No entanto, valores kappa maiores, como 0,90 como, são preferíveis.

Com classificações ordinais, como a classificação da gravidade de defeitos em uma escala de 1 a 5, os coeficientes de Kendall, que são responsáveis pela ordenação, são geralmente estatísticas mais apropriadas para determinar a associação do que apenas kappa.

Concordância de Avaliação

| Avaliador | Nº de Inspecionados | Nº de Correspondências | Percentual | IC de 95% |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94,00 | (83,45; 98,75) |

| Britt | 50 | 46 | 92,00 | (80,77; 97,78) |

| Eric | 50 | 41 | 82,00 | (68,56; 91,42) |

| Mike | 50 | 45 | 90,00 | (78,19; 96,67) |

Estatísticas de Kappa de Fleiss

| Avaliador | Resposta | Kappa | EP de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83060 | 0,100000 | 8,3060 | 0,0000 | |

| 3 | 0,81917 | 0,100000 | 8,1917 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92476 | 0,050257 | 18,4006 | 0,0000 | |

| Britt | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83838 | 0,100000 | 8,3838 | 0,0000 | |

| 3 | 0,80725 | 0,100000 | 8,0725 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92462 | 0,050396 | 18,3473 | 0,0000 | |

| Eric | 1 | 0,91159 | 0,100000 | 9,1159 | 0,0000 |

| 2 | 0,81035 | 0,100000 | 8,1035 | 0,0000 | |

| 3 | 0,72619 | 0,100000 | 7,2619 | 0,0000 | |

| 4 | 0,84919 | 0,100000 | 8,4919 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,86163 | 0,050500 | 17,0622 | 0,0000 | |

| Mike | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,91694 | 0,100000 | 9,1694 | 0,0000 | |

| 3 | 0,90736 | 0,100000 | 9,0736 | 0,0000 | |

| 4 | 0,92913 | 0,100000 | 9,2913 | 0,0000 | |

| 5 | 0,93502 | 0,100000 | 9,3502 | 0,0000 | |

| Global | 0,93732 | 0,050211 | 18,6674 | 0,0000 |

Coeficiente de Correlação de Kendall

| Avaliador | Coef | EP de Coef | Z | P |

|---|---|---|---|---|

| Amanda | 0,967386 | 0,0690066 | 14,0128 | 0,0000 |

| Britt | 0,967835 | 0,0690066 | 14,0193 | 0,0000 |

| Eric | 0,951863 | 0,0690066 | 13,7879 | 0,0000 |

| Mike | 0,975168 | 0,0690066 | 14,1256 | 0,0000 |

Resultados chave: Kappa, coeficiente de correlação de Kendall

A maioria dos valores de kappa são maiores do que 0,80, o que indica boa concordância entre cada avaliador e o padrão. Alguns dos valores de kappa estão perto de 0,70, o que indica talvez seja necessário investigar determinadas amostras ou ou determinados avaliadores mais detalhadamente. Como os dados são ordinais, o Minitab fornece os coeficientes de correlação de Kendall. Estes valores variam de 0,951863 e 0,975168, o que indica uma forte associação entre as classificações e os valores padrão.

Etapa 4: Avaliar a consistência de respostas entre avaliadores

Para determinar a consistência entre as classificações do avaliador, avalie as estatísticas de kappa na tabela Entre Avaliadores. Quando as classificações forem ordinais, você deve avaliar também coeficientes de concordância da Kendall.

Use as estatísticas kappa para avaliar o grau de concordância das classificações nominais ou ordinais feitas por vários avaliadores quando os avaliadores avaliarem as mesmas amostras.

- Quando kappa = 1, existe uma concordância perfeita.

- Quando kappa = 0, a concordância é aquela que seria esperada ao acaso.

- Quando kappa < 0, a concordância é mais fraca do que seria esperado ao acaso, o que raramente ocorre.

A AIAG sugere que um valor de kappa de pelo menos 0,75 indica uma boa concordância. No entanto, valores kappa maiores, como 0,90 como, são preferíveis.

Com classificações ordinais, como a classificação da gravidade de defeitos em uma escala de 1 a 5, os coeficientes de Kendall, que são responsáveis pela ordenação, são geralmente estatísticas mais apropriadas para determinar a associação do que apenas kappa.

Observação

Lembre-se de que a tabela de Entre Avaliadores indica se classificações dos avaliadores são consistentes, mas não se as classificações concordam com os valores de referência. Classificações consistentes não são necessariamente classificações corretas.

Concordância de Avaliação

| Nº de Inspecionados | Nº de Correspondências | Percentual | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Estatísticas de Kappa de Fleiss

| Resposta | Kappa | EP de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,954392 | 0,0267261 | 35,7101 | 0,0000 |

| 2 | 0,827694 | 0,0267261 | 30,9695 | 0,0000 |

| 3 | 0,772541 | 0,0267261 | 28,9058 | 0,0000 |

| 4 | 0,891127 | 0,0267261 | 33,3429 | 0,0000 |

| 5 | 0,968148 | 0,0267261 | 36,2248 | 0,0000 |

| Global | 0,881705 | 0,0134362 | 65,6218 | 0,0000 |

Coeficiente de Concordância de Kendall

| Coef | Qui-Quadrado | GL | P |

|---|---|---|---|

| 0,976681 | 382,859 | 49 | 0,0000 |

Resultados chave: Kappa, coeficiente de concordância de Kendall

Todos os valores de kappa são maiores do que 0,77, o que indica concordância minimamente aceitável entre avaliadores. Os avaliadores têm a maioria das concordâncias para as amostras 1 e 5, e a concordância mínima para a amostra 3. Como os dados são ordinais, o Minitab fornece o coeficiente de Kendall de concordância (0,976681), o que indica uma forte associação entre as classificações do avaliador.

Etapa 5: Avaliar a precisão das repostas para todos os avaliadores

Para determinar a precisão de todas as classificações do avaliador, avalie as estatísticas kappa na tabela Todos os avaliadores versus padrão. Quando as classificações forem ordinais, você deve avaliar também coeficientes de concordância de Kendall.

Use as estatísticas kappa para avaliar o grau de concordância das classificações nominais ou ordinais feitas por vários avaliadores quando os avaliadores avaliarem as mesmas amostras.

- Quando kappa = 1, existe uma concordância perfeita.

- Quando kappa = 0, a concordância é aquela que seria esperada ao acaso.

- Quando kappa < 0, a concordância é mais fraca do que seria esperado ao acaso, o que raramente ocorre.

A AIAG sugere que um valor de kappa de pelo menos 0,75 indica uma boa concordância. No entanto, valores kappa maiores, como 0,90 como, são preferíveis.

Com classificações ordinais, como a classificação da gravidade de defeitos em uma escala de 1 a 5, os coeficientes de Kendall, que são responsáveis pela ordenação, são geralmente estatísticas mais apropriadas para determinar a associação do que apenas kappa.

Concordância de Avaliação

| Nº de Inspecionados | Nº de Correspondências | Percentual | IC de 95% |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Estatísticas de Kappa de Fleiss

| Resposta | Kappa | EP de Kappa | Z | P(vs > 0) |

|---|---|---|---|---|

| 1 | 0,977897 | 0,0500000 | 19,5579 | 0,0000 |

| 2 | 0,849068 | 0,0500000 | 16,9814 | 0,0000 |

| 3 | 0,814992 | 0,0500000 | 16,2998 | 0,0000 |

| 4 | 0,944580 | 0,0500000 | 18,8916 | 0,0000 |

| 5 | 0,983756 | 0,0500000 | 19,6751 | 0,0000 |

| Global | 0,912082 | 0,0251705 | 36,2362 | 0,0000 |

Coeficiente de Correlação de Kendall

| Coef | EP de Coef | Z | P |

|---|---|---|---|

| 0,965563 | 0,0345033 | 27,9817 | 0,0000 |

Resultados chave: Kappa, coeficiente de concordância de Kendall

Estes resultados mostram que todos os avaliadores correspondem às classificações padrão em 37 das 50 amostras. O valor global de kappa é 0,912082, o que indica forte concordância com os valores padrão. Como os dados são ordinais, o Minitab fornece o coeficiente de Kendall de concordância (0,965563), o que indica uma forte associação entre as classificações e os valores padrão.