이 항목의 내용

1단계: 평가자 합치를 시각적으로 평가

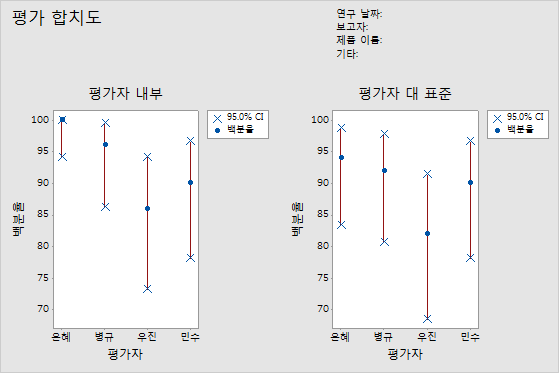

각 평가자 등급의 일관성을 확인하려면 평가자 그래프 안에서 평가하십시오. 합치율(파란색 원)을 각 평가자의 합치율(빨간색 선)에 대한 신뢰 구간과 비교하십시오.

각 평가자 등급의 일관성을 확인하려면 평가자 대 표준 그래프를 평가하십시오. 합치율(파란색 원)을 각 평가자의 합치율(빨간색 선)에 대한 신뢰 구간과 비교하십시오.

참고

여러 번의 시행이 있는 경우에만 평가자 내부 그래프가 표시됩니다.

평가자 내부 그래프는 은혜의 등급이 가장 일관성이 높고 우진의 등급이 가장 일관성이 낮다는 것을 나타냅니다. 평가자 대 표준 그래프는 은혜의 등급이 가장 일관성이 높고 우진의 등급이 가장 일관성이 낮다는 것을 나타냅니다.

2단계: 각 평가자 반응의 일관성 평가

각 평가자 등급의 일관성을 확인하려면 평가자 내 표의 카파 통계량을 평가하십시오. 등급이 순서형인 경우 Kendall의 일치성 계수도 평가해야 합니다. 각 평가자가 한 항목을 두 번 이상 평가하는 경우 평가자 내 표가 표시됩니다.

평가자가 동일한 표본을 평가할 때 여러 평가자의 명목형 또는 순서형 등급의 합치도를 평가하려면 카파 통계량을 사용하십시오.

- 카파 = 1이면 완전하게 합치하는 것입니다.

- 카파 = 0이면 합치가 우연히 발생하기를 기대하는 것과 같습니다.

- 카파 < 0이면 합치가 우연히 발생하기를 기대하는 것보다 약하며, 이러한 경우는 거의 발생하지 않습니다.

AIAG에 따르면 카파 값이 0.75 이상이면 적절히 합치됨을 나타냅니다. 그러나 더 큰 카파 값(예: 0.90)이 바람직합니다.

1-5의 척도를 사용하여 결점의 심각한 정도를 표시할 때처럼 등급이 순서형인 경우에는 일반적으로 카파보다는 Kendall의 계수가 연관성을 평가하는 데 더 적절한 통계량입니다.

참고

평가자 내부 표는 평가자의 등급이 기준 값과 일치하는지 여부가 아니라 등급에 일관성이 있는지 여부를 나타냅니다. 등급에 일관성이 있다고 해서 올바른 등급인 것은 아닙니다.

평가 합치도

| 평가자 | # 검사됨 | # 일치됨 | 백분율 | 95% CI |

|---|---|---|---|---|

| 은혜 | 50 | 50 | 100.00 | (94.18, 100.00) |

| 병규 | 50 | 48 | 96.00 | (86.29, 99.51) |

| 우진 | 50 | 43 | 86.00 | (73.26, 94.18) |

| 민수 | 50 | 45 | 90.00 | (78.19, 96.67) |

Fleiss의 카파 통계량

| 평가자 | 반응 | 카파 | SE 카파 | Z | P(대 > 0) |

|---|---|---|---|---|---|

| 은혜 | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 3 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 전체 | 1.00000 | 0.071052 | 14.0741 | 0.0000 | |

| 병규 | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.89605 | 0.141421 | 6.3360 | 0.0000 | |

| 3 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 4 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 전체 | 0.94965 | 0.071401 | 13.3002 | 0.0000 | |

| 우진 | 1 | 0.83060 | 0.141421 | 5.8733 | 0.0000 |

| 2 | 0.84000 | 0.141421 | 5.9397 | 0.0000 | |

| 3 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 4 | 0.70238 | 0.141421 | 4.9666 | 0.0000 | |

| 5 | 1.00000 | 0.141421 | 7.0711 | 0.0000 | |

| 전체 | 0.82354 | 0.071591 | 11.5034 | 0.0000 | |

| 민수 | 1 | 1.00000 | 0.141421 | 7.0711 | 0.0000 |

| 2 | 0.83060 | 0.141421 | 5.8733 | 0.0000 | |

| 3 | 0.81917 | 0.141421 | 5.7924 | 0.0000 | |

| 4 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 5 | 0.86450 | 0.141421 | 6.1129 | 0.0000 | |

| 전체 | 0.87472 | 0.070945 | 12.3295 | 0.0000 |

Kendall의 일치성 계수

| 평가자 | 계수 | 카이 - 제곱 | DF | P |

|---|---|---|---|---|

| 은혜 | 1.00000 | 98.0000 | 49 | 0.0000 |

| 병규 | 0.99448 | 97.4587 | 49 | 0.0000 |

| 우진 | 0.98446 | 96.4769 | 49 | 0.0001 |

| 민수 | 0.98700 | 96.7256 | 49 | 0.0001 |

주요 결과: 카파, Kendall의 일치성 계수

대부분의 카파 값이 평가자 내부 시행 간에 완전히 합치됨을 나타내는 1입니다. Eric의 카파 값 중 일부는 0.70에 가깝습니다. 해당 표본의 Eric의 등급이 일치하지 않는 이유를 조사해야 할 수도 있습니다. 데이터가 순서형이므로 Minitab에서 Kendall의 일치성 계수 값을 제공합니다. 이 값들은 모두 0.98보다 커서 평가자 등급 내에 매우 강한 연관성이 있음을 나타냅니다.

3단계: 각 평가자 반응의 정확성 평가

각 평가자 등급의 정확성을 확인하려면 각 평가자 대 표준 표를 평가하십시오. 등급이 순서형인 경우 Kendall의 상관 계수도 평가해야 합니다. 각 평가자 대 표준 표는 각 표본에 대한 기준 값을 지정하는 경우 표시됩니다.

평가자가 동일한 표본을 평가할 때 여러 평가자의 명목형 또는 순서형 등급의 합치도를 평가하려면 카파 통계량을 사용하십시오.

- 카파 = 1이면 완전하게 합치하는 것입니다.

- 카파 = 0이면 합치가 우연히 발생하기를 기대하는 것과 같습니다.

- 카파 < 0이면 합치가 우연히 발생하기를 기대하는 것보다 약하며, 이러한 경우는 거의 발생하지 않습니다.

AIAG에 따르면 카파 값이 0.75 이상이면 적절히 합치됨을 나타냅니다. 그러나 더 큰 카파 값(예: 0.90)이 바람직합니다.

1-5의 척도를 사용하여 결점의 심각한 정도를 표시할 때처럼 등급이 순서형인 경우에는 일반적으로 카파보다는 Kendall의 계수가 연관성을 평가하는 데 더 적절한 통계량입니다.

평가 합치도

| 평가자 | # 검사됨 | # 일치됨 | 백분율 | 95% CI |

|---|---|---|---|---|

| 은혜 | 50 | 47 | 94.00 | (83.45, 98.75) |

| 병규 | 50 | 46 | 92.00 | (80.77, 97.78) |

| 우진 | 50 | 41 | 82.00 | (68.56, 91.42) |

| 민수 | 50 | 45 | 90.00 | (78.19, 96.67) |

Fleiss의 카파 통계량

| 평가자 | 반응 | 카파 | SE 카파 | Z | P(대 > 0) |

|---|---|---|---|---|---|

| 은혜 | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83060 | 0.100000 | 8.3060 | 0.0000 | |

| 3 | 0.81917 | 0.100000 | 8.1917 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 전체 | 0.92476 | 0.050257 | 18.4006 | 0.0000 | |

| 병규 | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.83838 | 0.100000 | 8.3838 | 0.0000 | |

| 3 | 0.80725 | 0.100000 | 8.0725 | 0.0000 | |

| 4 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 전체 | 0.92462 | 0.050396 | 18.3473 | 0.0000 | |

| 우진 | 1 | 0.91159 | 0.100000 | 9.1159 | 0.0000 |

| 2 | 0.81035 | 0.100000 | 8.1035 | 0.0000 | |

| 3 | 0.72619 | 0.100000 | 7.2619 | 0.0000 | |

| 4 | 0.84919 | 0.100000 | 8.4919 | 0.0000 | |

| 5 | 1.00000 | 0.100000 | 10.0000 | 0.0000 | |

| 전체 | 0.86163 | 0.050500 | 17.0622 | 0.0000 | |

| 민수 | 1 | 1.00000 | 0.100000 | 10.0000 | 0.0000 |

| 2 | 0.91694 | 0.100000 | 9.1694 | 0.0000 | |

| 3 | 0.90736 | 0.100000 | 9.0736 | 0.0000 | |

| 4 | 0.92913 | 0.100000 | 9.2913 | 0.0000 | |

| 5 | 0.93502 | 0.100000 | 9.3502 | 0.0000 | |

| 전체 | 0.93732 | 0.050211 | 18.6674 | 0.0000 |

Kendall의 상관 계수

| 평가자 | 계수 | SE 계수 | Z | P |

|---|---|---|---|---|

| 은혜 | 0.967386 | 0.0690066 | 14.0128 | 0.0000 |

| 병규 | 0.967835 | 0.0690066 | 14.0193 | 0.0000 |

| 우진 | 0.951863 | 0.0690066 | 13.7879 | 0.0000 |

| 민수 | 0.975168 | 0.0690066 | 14.1256 | 0.0000 |

주요 결과: 카파, Kendall의 상관 계수

대부분의 카파 값이 0.80보다 커서 각 평가자의 등급과 표준이 적절히 일치함을 나타냅니다. 일부 카파 값은 0.70에 가까워 측정 표본 또는 특정 평가자를 더 조사해야 할 수도 있음을 나타냅니다. 데이터가 순서형이므로 Minitab에서 Kendall의 상관 계수를 제공합니다. 이 값의 범위는 0.951863에서 0.975168로, 등급과 표준 값 간에 강한 연관성이 있음을 나타냅니다.

4단계: 평가자 간 반응의 일관성 평가

평가자의 등급 간 일관성을 확인하려면 평가자 간 표의 카파 통계량을 평가하십시오. 등급이 순서형인 경우 Kendall의 일치성 계수도 평가해야 합니다.

평가자가 동일한 표본을 평가할 때 여러 평가자의 명목형 또는 순서형 등급의 합치도를 평가하려면 카파 통계량을 사용하십시오.

- 카파 = 1이면 완전하게 합치하는 것입니다.

- 카파 = 0이면 합치가 우연히 발생하기를 기대하는 것과 같습니다.

- 카파 < 0이면 합치가 우연히 발생하기를 기대하는 것보다 약하며, 이러한 경우는 거의 발생하지 않습니다.

AIAG에 따르면 카파 값이 0.75 이상이면 적절히 합치됨을 나타냅니다. 그러나 더 큰 카파 값(예: 0.90)이 바람직합니다.

1-5의 척도를 사용하여 결점의 심각한 정도를 표시할 때처럼 등급이 순서형인 경우에는 일반적으로 카파보다는 Kendall의 계수가 연관성을 평가하는 데 더 적절한 통계량입니다.

참고

평가자 간 표는 평가자의 등급이 기준 값과 일치하는지 여부가 아니라 등급에 일관성이 있는지 여부를 나타냅니다. 등급에 일관성이 있다고 해서 올바른 등급인 것은 아닙니다.

평가 합치도

| # 검사됨 | # 일치됨 | 백분율 | 95% CI |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Fleiss의 카파 통계량

| 반응 | 카파 | SE 카파 | Z | P(대 > 0) |

|---|---|---|---|---|

| 1 | 0.954392 | 0.0267261 | 35.7101 | 0.0000 |

| 2 | 0.827694 | 0.0267261 | 30.9695 | 0.0000 |

| 3 | 0.772541 | 0.0267261 | 28.9058 | 0.0000 |

| 4 | 0.891127 | 0.0267261 | 33.3429 | 0.0000 |

| 5 | 0.968148 | 0.0267261 | 36.2248 | 0.0000 |

| 전체 | 0.881705 | 0.0134362 | 65.6218 | 0.0000 |

Kendall의 일치성 계수

| 계수 | 카이 - 제곱 | DF | P |

|---|---|---|---|

| 0.976681 | 382.859 | 49 | 0.0000 |

주요 결과: 카파, Kendall의 일치성 계수

모든 카파 값이 평가자 간에 허용되는 최소 합치도를 나타내는 0.77보다 작습니다. 표본 1과 5에 대한 평가자의 합치도가 가장 높고 표본 3에 대한 합치도가 가장 낮습니다. 데이터가 순서형이므로 Minitab에서는 Kendall의 일치성 계수(0.976681)를 제공하며, 이 값은 평가자 등급 간에 매우 강한 연관성이 있다는 것을 나타냅니다.

5단계: 모든 평가자의 반응 정확성 평가

모든 평가자 등급 정확성을 확인하려면 모든 평가자 대 표준 표를 평가하십시오. 등급이 순서형인 경우 Kendall의 일치성 계수도 평가해야 합니다.

평가자가 동일한 표본을 평가할 때 여러 평가자의 명목형 또는 순서형 등급의 합치도를 평가하려면 카파 통계량을 사용하십시오.

- 카파 = 1이면 완전하게 합치하는 것입니다.

- 카파 = 0이면 합치가 우연히 발생하기를 기대하는 것과 같습니다.

- 카파 < 0이면 합치가 우연히 발생하기를 기대하는 것보다 약하며, 이러한 경우는 거의 발생하지 않습니다.

AIAG에 따르면 카파 값이 0.75 이상이면 적절히 합치됨을 나타냅니다. 그러나 더 큰 카파 값(예: 0.90)이 바람직합니다.

1-5의 척도를 사용하여 결점의 심각한 정도를 표시할 때처럼 등급이 순서형인 경우에는 일반적으로 카파보다는 Kendall의 계수가 연관성을 평가하는 데 더 적절한 통계량입니다.

평가 합치도

| # 검사됨 | # 일치됨 | 백분율 | 95% CI |

|---|---|---|---|

| 50 | 37 | 74.00 | (59.66, 85.37) |

Fleiss의 카파 통계량

| 반응 | 카파 | SE 카파 | Z | P(대 > 0) |

|---|---|---|---|---|

| 1 | 0.977897 | 0.0500000 | 19.5579 | 0.0000 |

| 2 | 0.849068 | 0.0500000 | 16.9814 | 0.0000 |

| 3 | 0.814992 | 0.0500000 | 16.2998 | 0.0000 |

| 4 | 0.944580 | 0.0500000 | 18.8916 | 0.0000 |

| 5 | 0.983756 | 0.0500000 | 19.6751 | 0.0000 |

| 전체 | 0.912082 | 0.0251705 | 36.2362 | 0.0000 |

Kendall의 상관 계수

| 계수 | SE 계수 | Z | P |

|---|---|---|---|

| 0.965563 | 0.0345033 | 27.9817 | 0.0000 |

주요 결과: 카파, Kendall의 일치성 계수

이 결과는 50개 표본 중 37개에서 모든 평가자가 표준 등급과 일치한다는 것을 보여줍니다. 전체 카파 값은 0.912082로, 표준 값과 매우 일치함을 나타냅니다. 데이터가 순서형이므로 Minitab에서 Kendall의 일치성 계수(0.965563)를 제공하며, 이 값은 등급과 표준 값 사이에 강한 연관성이 있음을 나타냅니다.