モデルの検証法と複雑度パラメータの詳細については、Breiman, Friedman, Olshen and Stone (1984) を参照してください。1.

モデル検証法

ROC曲線下の面積などのモデルの要約統計量は、モデルに適合するために使用するのと同じデータで計算する場合、楽観的になる傾向があります。モデル検証法は、データのある割合をモデル適合プロセス外に残し、除外されたデータに対するモデルのパフォーマンスを評価する統計量を計算します。モデル検証法は、モデルが新しいデータに対してどの程度良好に機能するかを良く推定します。除外されたデータからの誤分類コストは、最適な木の選択基準となります。Minitabでは、予測分析手法に対する2つの検証法を提供しています。 K分割交差検証と、別のテストデータセットを使用した検証です。

K分割交差検証を使用した最適な木

K分割交差検証は、データのケース数が5,000以下の場合のMinitabのデフォルトの方法です。この方法では、データがK個のサブセットに分割されます。サブセットは分割と呼ばれます。K分割交差検証は、テストデータセットで良好に機能するデータセットに比べて小さいデータセットで良好に機能する傾向があります。このプロセスはK回繰り返されるため、交差検証は、通常、テストデータセットによる検証よりも時間がかかります。

K分割交差検証の手順

K分割交差検証を完了するために、サブツリーの1 + kセットの一連の結果が生成されます。サブツリーの1つの一連の結果であるマスターの結果は、トレーニングデータ セット全体を使用します。他のkセットの一連の結果はk個の分割のためのものです。各分割に関して、サブツリーの一連の結果は、トレーニングデータセット内のケースの (k – 1)/k を使用します。

各一連の結果は、組み入れられたサブツリーの有限な一連の結果で構成されます。各分割には、一連の結果の最大の木とサブツリーに対応する複雑性パラメータαd ≤ α ≤ αd + 1セットの有限な一連の結果を有します。データセット全体の一連の結果には、複雑度パラメータβd ≤ β ≤ βd + 1 ここで d= 0, 1, ..D があり、ここで、一連のセットの中で最も大きい木のパラメータは、β0 です。

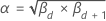

すべてのマスターの一連の結果のサブツリーに対して、対応する複雑度パラメータはβd および βd + 1 であると仮定します。次のように定義します。 .次に、このアルファを使用して、k分割から対応するk本のサブツリーを探します。各分割について、CART® 分類におけるモデルの要約の方法と計算式の計算式を使用してサブツリーの誤分類コストを計算します。k分割全体の平均誤分類コストは、マスターの一連の結果のサブツリーの推定誤分類コストです。マスターの一連の結果の各サブツリーに対して、推定誤分類コストの計算を繰り返します。この手順では、最小の誤分類コストのサブツリーを識別します。最小誤分類コストを有する木、または最小誤分類コストの標準誤差内の倍数以内の誤分類コストを有する最小の木が、結果の最適な木になります。

.次に、このアルファを使用して、k分割から対応するk本のサブツリーを探します。各分割について、CART® 分類におけるモデルの要約の方法と計算式の計算式を使用してサブツリーの誤分類コストを計算します。k分割全体の平均誤分類コストは、マスターの一連の結果のサブツリーの推定誤分類コストです。マスターの一連の結果の各サブツリーに対して、推定誤分類コストの計算を繰り返します。この手順では、最小の誤分類コストのサブツリーを識別します。最小誤分類コストを有する木、または最小誤分類コストの標準誤差内の倍数以内の誤分類コストを有する最小の木が、結果の最適な木になります。

別のテストデータセットによる最適な木

テストデータセットを使用した検証では、データの一部が検証用に確保されます。データのこの部分は、トレーニングデータセットです。まず、Minitabはトレーニングデータセットに合わせてすべての木を適合します。次に、各木のテストデータセットの平均平方誤差または絶対偏差が計算されます。テストデータセットの基準の最適値をもつ木が、最適な木です。

検証のない最適な木

検証を行わない場合、Minitabではデータセット全体を使用してサブツリーの一連の結果が拡張されます。最も多くのターミナルノードがあるサブツリーが、誤分類コストが最小で、最適な木です。