Notation

.

.

La matrice jacobienne de η est une matrice N X P avec des éléments égaux aux dérivées partielles de la fonction de prévision concernant les paramètres :

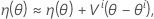

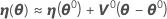

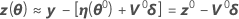

Une approximation linéaire de η est donc la suivante :

Soit θ* l'estimation des moindres carrés.

Gauss-Newton

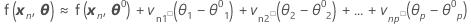

Y compris tous les cas N

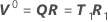

où

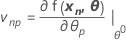

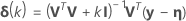

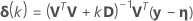

Minitab calcule l'incrément de Gauss δ0 pour minimiser la somme des carrés des valeurs résiduelles approximatives  , à l'aide de :

, à l'aide de :

.

.

Le point

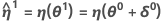

doit désormais être plus proche de y que η(θ0), et Minitab utilise la valeur θ1 = θ0 + δ0 pour réaliser une autre itération en calculant de nouvelles valeurs résiduelles z1 = y - η(θ1), une nouvelle matrice dérivée V1 et un nouvel incrément. Minitab répète ce procédé jusqu'à atteindre une convergence, c'est-à-dire lorsque l'incrément est tellement petit qu'il n'existe aucune variation utile des éléments du vecteur de paramètre.

L'incrément de Gauss-Newton engendre parfois une augmentation de la somme des carrés. Lorsque cela se produit, l'approximation linéaire est toujours proche de la surface réelle pour une zone suffisamment petite autour de η(θ0). Pour réduire la somme des carrés, Minitab introduit un facteur d'étape λ et procède au calcul suivant :

- Bates et Watts (1988). Nonlinear Regression Analysis and Its Applications. John Wiley & Sons, Inc.

Levenberg-Marquardt

.1

.1

- Bates et Watts (1988). Nonlinear Regression Analysis and Its Applications. John Wiley & Sons, Inc.

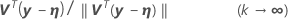

Critère de convergence de décalage relatif

1. Bates et Watts (1988). Nonlinear Regression Analysis and Its Applications. John Wiley & Sons, Inc.