Sur ce thème

Famille exponentielle et fonctions de liaison

L'extension des modèles linéaires classiques aux modèles linaires généralisés se compose de deux parties : une loi issue de la famille exponentielle et une fonction de liaison.

Famille exponentielle

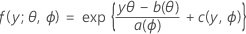

La première partie étend le modèle linéaire aux variables de réponse membres d'une grande famille de lois appelée famille exponentielle. Le format général des fonctions de répartition de probabilités pour les membres de la famille exponentielle de lois est le suivant :

où a(∙), b(∙) et c(∙) dépendent de la loi de la variable de réponse. Le paramètre θ est un paramètre d'emplacement souvent appelé paramètre canonique et ϕ est un paramètre de dispersion. La fonction a(ϕ) a habituellement la forme a(ϕ) = ϕ/ω, où ω représente une constante ou une pondération connue susceptible de varier d'une observation à l'autre. (Dans Minitab, lorsque les pondérations sont indiquées, la fonction a(ϕ) est ajustée en conséquence.)

Les membres de la famille exponentielle peuvent être des lois de probabilité discrète ou des lois de distribution continue. Les lois de distribution continue membres de la famille exponentielle comprennent entre autres la loi normale et la distribution gamma. Les lois de probabilité discrète membres de la famille exponentielle incluent la loi binomiale et la loi de Poisson. Le tableau suivant présente les caractéristiques de certaines de ces lois.

| Loi de distribution | ϕ | b(θ) | a(φ) | c(y, ϕ) |

| Normale | σ2 | θ2/2 | φω |  |

| Binomiale | 1 |  |

φ/ω | -ln(y!) |

| Poisson | 1 | exp(θ) | φ/ω |  |

Fonction de liaison

La seconde partie est la fonction de liaison. Elle associe la moyenne de la réponse dans la ie observation à un prédicteur linéaire de cette manière :

Le modèle linéaire classique est un cas particulier de cette formulation générale dans laquelle la fonction de liaison est la fonction d'identité.

Le choix de la fonction de liaison dans la seconde partie dépend de la loi de la famille exponentielle dans la première partie. Chaque loi de la famille exponentielle dispose d'une fonction de liaison particulière appelée fonction de liaison canonique. Cette dernière vérifie l'équation g (μi) = Xi'β = θ, où θ est le paramètre canonique. La fonction de liaison canonique engendre des propriétés statistiques voulues du modèle. Les statistiques d'adéquation de l'ajustement peuvent servir à comparer les ajustements obtenus par différentes fonctions de liaison. Le choix de certaines fonctions de liaison peut dépendre de raisons historiques ou de leur signification particulière dans une discipline. Par exemple, la fonction logit a pour avantage de fournir une estimation des rapports de probabilités de succès. Nous pouvons également prendre comme exemple la fonction de liaison normit, qui suppose qu'il existe une variable sous-jacente suivant une loi de distribution normale et classée en catégories binaires.

Minitab offre trois fonctions de liaison pour chaque classe de modèles. Les différentes fonctions de liaison permettent de trouver des modèles bien ajustés à une grande variété de données.

Pour les modèles binomiaux, les fonctions de liaison sont logit, normit (également appelée probit) et gompit (appelée également log-log complémentaire). Ces fonctions sont l'inverse de la loi de distribution logistique standard cumulée (logit), l'inverse de la loi de distribution normale standard cumulée (normit) et l'inverse de la loi de distribution de Gompertz (gompit). Logit représente la fonction de liaison canonique pour les modèles binoniaux, ce qui en fait la fonction de liaison par défaut.

Pour les modèles de Poisson, les fonctions de liaison sont le logarithme népérien, la racine carrée et l'identité. Le logarithme népérien représente la fonction de liaison canonique pour les modèles de Poisson, ce qui en fait la fonction de liaison par défaut.

Les fonctions de liaison sont récapitulées ci-après :

| Modèle | Nom | Fonction de liaison, g(μi) |

| Binomiale | logit |  |

| Binomiale | normit (probit) |  |

| Binomiale | gompit (log-log complémentaire) |  |

| Poisson | logarithme népérien |  |

| Poisson | racine carrée |  |

| Poisson | identité |  |

Notation

| Terme | Description |

|---|---|

| μi | réponse moyenne de la ie ligne |

| g(μi) | fonction de liaison |

| X | vecteur de variables de prédiction |

| β | vecteur des coefficients associés aux prédicteurs |

| inverse de la fonction de répartition cumulée pour la loi normale |

Coefficients

[1] P. McCullagh et J. A. Nelder (1989). Generalized Linear Models, 2nd Ed., Chapman & Hall/CRC, London.

Erreur type des coefficients

W est une matrice diagonale dans laquelle les éléments diagonaux sont fournis par la formule suivante :

où

La matrice de variance/covariance est fondée sur la matrice hessienne observée au lieu de la matrice d'informations de Fisher. Minitab utilise la matrice hessienne observée, car le modèle obtenu est plus fiable en cas d'erreur de spécification de la moyenne conditionnelle.

Si la liaison canonique est utilisée, la matrice hessienne observée et la matrice d'informations de Fisher sont identiques.

Notation

| Terme | Description |

|---|---|

| yi | valeur de la réponse pour la ie ligne |

| réponse moyenne estimée pour la ie ligne |

| V(·) | fonction de variance fournie dans le tableau ci-dessous |

| g(·) | fonction de liaison |

| V '(·) | première dérivée de la fonction de variance |

| g'(·) | première dérivée de la fonction de liaison |

| g''(·) | seconde dérivée de la fonction de liaison |

La fonction de variance dépend du modèle :

| Modèle | Fonction de variance |

| Binomiale |  |

| Poisson |  |

Pour plus d'informations, reportez-vous à [1] et à [2].

[1] A. Agresti (1990). Categorical Data Analysis. John Wiley & Sons, Inc.

[2] P. McCullagh et J.A. Nelder (1992). Generalized Linear Model. Chapman & Hall.

Rapports des probabilités de succès pour la régression logistique binaire

Le rapport des probabilités de succès n'est fourni que si vous sélectionnez la fonction de liaison logit pour un modèle avec une réponse binaire. Dans ce cas, le rapport des probabilités de succès sert à interpréter la relation entre un prédicteur et une réponse.

Le rapport des probabilités de succès (τ) peut être tout nombre non négatif. Le rapport des probabilités de succès de 1 sert comme référence de comparaison. Si τ = 1, il n'existe aucune association entre la réponse et le prédicteur. Si τ < 1, les probabilités de succès de l'événement sont supérieures pour le niveau de référence du facteur (ou pour les niveaux inférieurs d'un prédicteur continu). Si τ > 1, les probabilités de succès de l'événement sont inférieures pour le seuil de référence du facteur (ou pour les niveaux inférieurs d'un prédicteur continu). Plus le rapport est éloigné de 1, plus le degré d'association est fort.

Remarque

Pour le modèle de régression logistique binaire avec une covariable ou un facteur, les probabilités de succès estimées sont calculées comme suit :

La relation exponentielle fournit une interprétation pour β : les probabilités de succès sont multipliées par eβ1 pour chaque augmentation d'une unité de x. Le rapport des probabilités de succès est équivalent à exp(β1).

Par exemple, si β est égal à 0,75, le rapport des probabilités de succès est de exp(0,75), soit 2,11. Cela indique une augmentation de 111 % des probabilités de succès pour chaque augmentation d'une unité dans x.

Notation

| Terme | Description |

|---|---|

| probabilité estimée de succès pour la ie ligne des données |

| coefficient estimé de l'ordonnée à l'origine |

| coefficient estimé pour le prédicteur x |

| point de donnée pour la ie ligne |

Matrice de variance/covariance

Matrice d x d, où d représente le nombre de prédicteurs plus un. La variance de chaque coefficient figure dans la cellule en diagonale et la covariance de chaque paire de coefficients figure dans la cellule hors diagonale appropriée. La variance est l'erreur type du carré du coefficient.

La matrice de variance/covariance provient de la dernière itération de la valeur inverse de la matrice d'informations. La matrice de variance/covariance a la forme suivante :

W est une matrice diagonale dans laquelle les éléments diagonaux sont fournis par la formule suivante :

où

La matrice de variance/covariance est fondée sur la matrice hessienne observée au lieu de la matrice d'informations de Fisher. Minitab utilise la matrice hessienne observée, car le modèle obtenu est plus fiable en cas d'erreur de spécification de la moyenne conditionnelle.

Si la liaison canonique est utilisée, la matrice hessienne observée et la matrice d'informations de Fisher sont identiques.

Notation

| Terme | Description |

|---|---|

| yi | valeur de la réponse pour la ie ligne |

| réponse moyenne estimée pour la ie ligne |

| V(·) | fonction de variance fournie dans le tableau ci-dessous |

| g(·) | fonction de liaison |

| V '(·) | première dérivée de la fonction de variance |

| g'(·) | première dérivée de la fonction de liaison |

| g''(·) | seconde dérivée de la fonction de liaison |

La fonction de variance dépend du modèle :

| Modèle | Fonction de variance |

| Binomiale |  |

| Poisson |  |

Pour plus d'informations, reportez-vous à [1] et à [2].

[1] A. Agresti (1990). Categorical Data Analysis. John Wiley & Sons, Inc.

[2] P. McCullagh et J.A. Nelder (1992). Generalized Linear Model. Chapman & Hall.