Remarque

Cette commande est disponible avec le Module d'analyse prédictive. Cliquez ici pour plus d'informations sur l'activation du module.

Remarque

Minitab affiche les résultats des ensembles de données d'apprentissage et de test. Les résultats de test indiquent si le modèle peut prédire de manière adaptée les valeurs de réponse pour les nouvelles observations, ou récapituler correctement les relations entre les variables de réponse et de prédiction. Utilisez les résultats d'apprentissage pour évaluer le surajustement du modèle.

Nombre total de prédicteurs

Nombre total de prédicteurs disponibles pour le modèle TreeNet®. Le total correspond à la somme des prédicteurs continus et de catégorie que vous spécifiez.

Prédicteurs importants

Nombre de prédicteurs importants dans le modèle TreeNet®. Les prédicteurs importants ont des scores d'importance supérieurs à 0,0. Vous pouvez utiliser la courbe d'importance relative des variables pour afficher l'ordre d'importance relative des variables. Par exemple, supposons que 10 des 20 prédicteurs soient importants dans le modèle, la courbe d'importance relative des variables affiche les variables dans l'ordre d'importance.

Nombre d'arbres cultivés

Par défaut, Minitab cultive 300 petits arbres CART® pour produire le modèle TreeNet®. Bien que cette valeur fonctionne bien pour l'exploration des données, envisagez de cultiver plus d'arbres pour produire un modèle final. Pour modifier le nombre d'arbres cultivés, accédez à la sous-boîte de dialogue Options.

Nombre optimal d'arbres

Le nombre optimal d'arbres correspond à la valeur R2 la plus élevée ou à la valeur MAD la plus basse.

Lorsque le nombre optimal d'arbres est proche du nombre maximal d'arbres que le modèle cultive, envisagez d'effectuer une analyse avec plus d'arbres. Ainsi, si vous cultivez 300 arbres et le nombre optimal est de 298, créez à nouveau le modèle avec plus d'arbres. Si le nombre optimal continue d'être proche du nombre maximal, continuez d'augmenter le nombre d'arbres.

R carré

Le R2 est le pourcentage de variation dans la réponse que le modèle explique. Les valeurs aberrantes ont un plus grand effet sur le R2 que sur le MAD et le MAPE.

Lorsque vous utilisez une méthode de validation, le tableau inclut une statistique R2 pour l'ensemble de données d'apprentissage et une statistique R2 pour l'ensemble de données de test. Lorsque la méthode de validation est la validation croisée sur K ensembles, l'ensemble de données de test est chaque partition lorsque la construction du modèle exclut cette partition. La statistique R2 de test est généralement une meilleure mesure de la qualité du modèle avec de nouvelles données.

Interprétation

Utilisez le R2 pour déterminer la qualité d'ajustement offert par le modèle. Plus la valeur de R2 est élevée, plus l'ajustement offert par le modèle est bon. Le R2 se situe toujours entre 0 % et 100 %.

Un R2 de test nettement inférieur au R2 d'apprentissage indique que le modèle peut ne pas prédire les valeurs de réponse pour les nouveaux cas aussi bien qu'il ajuste l'ensemble de données actuel.

Racine de l'erreur quadratique moyenne (RMSE)

La racine de l'erreur quadratique moyenne (RMSE) mesure l'exactitude du modèle. Les valeurs aberrantes ont un plus grand effet sur la RMSE que sur le MAD et le MAPE.

Lorsque vous utilisez une méthode de validation, le tableau inclut une statistique RMSE pour l'ensemble de données d'apprentissage et une statistique RMSE pour l'ensemble de données de test. Lorsque la méthode de validation est la validation croisée sur K ensembles, l'ensemble de données de test est chaque partition lorsque la construction du modèle exclut cette partition. La statistique RMSE de test est généralement une meilleure mesure de la qualité du modèle avec de nouvelles données.

Interprétation

Utilisez cette statistique pour comparer les valeurs ajustées de différents modèles. Des valeurs plus petites indiquent un meilleur ajustement. Une RMSE de test nettement plus élevé à la RMSE d'apprentissage indique que le modèle peut ne pas prédire les valeurs de réponse pour les nouveaux cas aussi bien qu'il ajuste l'ensemble de données actuel.

Erreur quadratique moyenne (MSE)

L'erreur quadratique moyenne (MSE) mesure l'exactitude du modèle. Les valeurs aberrantes ont un plus grand effet sur la MSE que sur le MAD et le MAPE.

Lorsque vous utilisez une méthode de validation, le tableau inclut une statistique MSE pour l'ensemble de données d'apprentissage et une statistique MSE pour l'ensemble de données de test. Lorsque la méthode de validation est la validation croisée sur K ensembles, l'ensemble de données de test est chaque partition lorsque la construction du modèle exclut cette partition. La statistique MSE de test est généralement une meilleure mesure de la qualité du modèle avec de nouvelles données.

Interprétation

Utilisez cette statistique pour comparer les valeurs ajustées de différents modèles. Des valeurs plus petites indiquent un meilleur ajustement. Un MSE de test nettement plus élevé au MSE d'apprentissage indique que le modèle peut ne pas prédire les valeurs de réponse pour les nouveaux cas aussi bien qu'il ajuste l'ensemble de données actuel.

Écart absolu moyen (MAD)

L'écart absolu moyen (MAD) exprime l'exactitude dans les mêmes unités que les données, ce qui permet de conceptualiser la quantité d'erreurs. Les valeurs aberrantes ont moins d'effet sur le MAD que sur le R2, la RMSE et la MSE.

Lorsque vous utilisez une méthode de validation, le tableau inclut une statistique MAD pour l'ensemble de données d'apprentissage et une statistique MAD pour l'ensemble de données de test. Lorsque la méthode de validation est la validation croisée sur K ensembles, l'ensemble de données de test est chaque partition lorsque la construction du modèle exclut cette partition. La statistique MAD de test est généralement une meilleure mesure de la qualité du modèle avec de nouvelles données.

Interprétation

Utilisez cette statistique pour comparer les valeurs ajustées de différents modèles. Des valeurs plus petites indiquent un meilleur ajustement. Un MAD de test nettement plus élevé au MAD d'apprentissage indique que le modèle peut ne pas prédire les valeurs de réponse pour les nouveaux cas aussi bien qu'il ajuste l'ensemble de données actuel.

Pourcentage d'erreur absolue moyen (MAPE)

Le pourcentage d'erreur absolue moyen (MAPE) exprime l'exactitude en pourcentage d'erreur. Étant donné que le MAPE est un pourcentage, il peut être plus facile à comprendre que les autres statistiques de mesure de l'exactitude. Par exemple, si le MAPE est de 0,05 en moyenne, le rapport moyen entre l'erreur ajustée et la valeur réelle est de 5 % dans tous les cas. Les valeurs aberrantes ont moins d'effet sur le MAPE que sur le R2, la RMSE et la MSE.

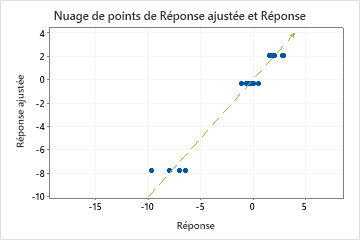

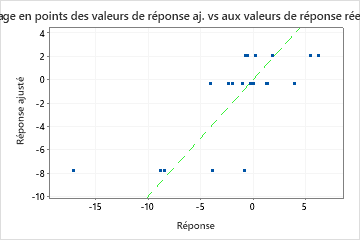

Cependant, parfois, vous pouvez voir une valeur de MAPE très grande, même si le modèle semble bien ajuster les données. Examinez le diagramme de la valeur de réponse ajustée par rapport à la valeur de réponse réelle pour voir si les valeurs de données sont proches de 0. Étant donné que le MAPE divise l'erreur absolue par les données réelles, les valeurs proches de 0 peuvent grandement augmenter le MAPE.

Lorsque vous utilisez une méthode de validation, le tableau inclut une statistique MAPE pour l'ensemble de données d'apprentissage et une statistique MAPE pour l'ensemble de données de test. Lorsque la méthode de validation est la validation croisée sur K ensembles, l'ensemble de données de test est chaque partition lorsque la construction du modèle exclut cette partition. La statistique MAPE de test est généralement une meilleure mesure de la qualité du modèle avec de nouvelles données.

Interprétation

Utilisez cette statistique pour comparer les valeurs ajustées de différents modèles. Des valeurs plus petites indiquent un meilleur ajustement. Un MAPE de test nettement plus élevé au MAPE d'apprentissage indique que le modèle peut ne pas prédire les valeurs de réponse pour les nouveaux cas aussi bien qu'il ajuste l'ensemble de données actuel.