Pour plus de détails sur les méthodes de validation de modèle et les paramètres de complexité, voir Breiman, Friedman, Olshen et Stone (1984)1.

Méthodes de validation de modèle

Les statistiques récapitulatives du modèle, comme le R2, ont tendance à être optimistes lorsque vous les calculez avec les mêmes données que celles utilisées pour ajuster un modèle. Les méthodes de validation de modèle omettent une partie des données lors du procédé d'ajustement du modèle, puis calculent les statistiques qui évaluent les performances du modèle sur les données omises. Les techniques de validation de modèle fournissent une meilleure estimation de la performance des modèles sur de nouvelles données. Minitab propose deux méthodes de validation pour les techniques d'analyse prédictive : la validation croisée sur K ensembles et la validation avec un ensemble de données de test distinct.

Arbre optimal avec la validation croisée sur K ensembles

La validation croisée sur K ensembles est celle utilisée par défaut dans Minitab lorsque les données comprennent un maximum de 5 000 cas. Avec cette méthode, Minitab répartit les données en K sous-échantillons. Ces sous-échantillons sont appelés partitions. La validation croisée sur K ensembles fonctionne bien avec les ensembles de données qui sont relativement petits par rapport aux ensembles de données qui fonctionnent bien avec un ensemble de données de test. Étant donné que le processus se répète K fois, la validation croisée est généralement plus lente que la validation avec un ensemble de données de test.

Procédure de validation croisée sur K ensembles

Pour compléter la validation croisée sur K ensembles, Minitab produit 1 + K séquences de sous-arbres. Une séquence de sous-arbres, la séquence principale, utilise l'ensemble complet de données d'apprentissage. Les K autres séquences sont pour les K ensembles. Pour chaque partition, la séquence des sous-arbres utilise (K - 1)/K cas de l'ensemble de données d'apprentissage.

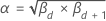

Chaque séquence se compose d'une séquence finie de sous-arbres emboîtés. Chaque partition comprend une séquence finie de paramètres de complexité αd ≤ α ≤ αd + 1 qui correspondent au plus grand arbre et aux sous-arbres de la séquence. La séquence de l'ensemble de données complet a des paramètres de complexité βd ≤ β ≤ βd + 1où d = 0, 1, ... D, où β0 est le paramètre du plus grand arbre de la séquence.

Pour tout sous-arbre de la séquence principale, supposons que les paramètres de complexité correspondants sont βd et βd + 1. Soit  . Ensuite, Minitab utilise cet alpha pour trouver les K sous-arbres correspondants à partir des K ensembles. Pour chaque partition, calculez le critère choisi pour le sous-arbre à l'aide de la formule de Méthodes et formules pour le récapitulatif du modèle dans la fonction Régression CART®. La moyenne du critère entre K ensembles est la valeur estimée pour le sous-arbre dans la séquence principale. Répétez le calcul du critère pour chaque sous-arbre de la séquence principale. Le sous-arbre de valeur moyenne minimale est l'arbre optimal.

. Ensuite, Minitab utilise cet alpha pour trouver les K sous-arbres correspondants à partir des K ensembles. Pour chaque partition, calculez le critère choisi pour le sous-arbre à l'aide de la formule de Méthodes et formules pour le récapitulatif du modèle dans la fonction Régression CART®. La moyenne du critère entre K ensembles est la valeur estimée pour le sous-arbre dans la séquence principale. Répétez le calcul du critère pour chaque sous-arbre de la séquence principale. Le sous-arbre de valeur moyenne minimale est l'arbre optimal.

Arbre optimal avec un ensemble de données de test distinct

Lors de la validation avec un ensemble de données de test, une partie des données est mise de côté pour validation. Cette partie des données est l'ensemble de données d'apprentissage. Tout d'abord, Minitab ajuste tous les arbres avec l'ensemble de données d'apprentissage. Ensuite, Minitab calcule soit l'erreur quadratique moyenne, soit l'écart absolu pour l'ensemble de données de test pour chaque arbre. L'arbre qui présente la valeur optimale du critère pour l'ensemble de données de test est l'arbre optimal.

Arbre optimal sans validation

Sans aucune validation, Minitab utilise l'ensemble de données pour développer la séquence de sous-arbres. Le sous-arbre ayant le plus de nœuds terminaux a la plus petite erreur quadratique moyenne ou le plus petit écart absolu, c'est l'arbre optimal.