Sur ce thème

Effet

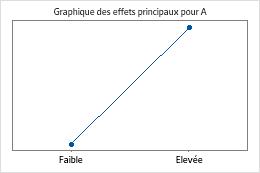

Un effet décrit l'importance et le sens de la relation entre un terme et la variable de réponse. Minitab calcule les effets des facteurs et des interactions entre les facteurs.

Interprétation

L'importance d'effet correspond à une modification de la fonction de liaison. Lors de l'utilisation de la fonction de liaison Logit, l'importance d'effet correspond au rapport des probabilités de succès du logarithme pour le passage du niveau inférieur au niveau supérieur d'un facteur. Le signe de l'effet indique le sens de la relation entre le terme et la réponse.

Plus une interaction comporte de facteurs, plus il est plus difficile d'en interpréter l'effet. Pour les facteurs et les interactions entre facteurs, l'importance de l'effet aide généralement à évaluer si l'effet d'un terme sur la variable de réponse est significatif dans la pratique.

L'importance de l'effet n'indique pas si un terme est statistiquement significatif ou non, car le calcul de la signification prend également en compte la variation des données de réponse. Pour évaluer la signification statistique, examinez la valeur de p du terme.

Coeff

Un coefficient de régression décrit l'importance et le sens de la relation entre un prédicteur et la variable de réponse. Les coefficients sont les nombres par lesquels les valeurs du terme sont multipliées dans une équation de régression.

Interprétation

Utilisez le coefficient pour déterminer si la variation d'une variable de prévision augmente ou réduit la probabilité d'occurrence de l'événement. Le coefficient d'un terme représente le changement dans la fonction de liaison associée à une augmentation d'une unité codée de ce terme quand tous les autres prédicteurs sont maintenus constants.

La valeur de l'effet aide généralement à évaluer si l'effet d'un terme sur la variable de réponse est significatif dans la pratique. L'importance de l'effet n'indique pas si un terme est statistiquement significatif ou non, car le calcul de la signification prend également en compte la variation des données de réponse. Pour évaluer la signification statistique, examinez la valeur de p du terme.

La relation entre le coefficient et la probabilité dépend de plusieurs aspects de l'analyse, notamment la fonction de liaison, l'événement de référence pour la réponse et les niveaux de référence pour les prédicteurs de catégorie du modèle. En général, les coefficients positifs augmentent la probabilité de l'événement tandis que les coefficients négatifs la réduisent. Un coefficient estimé proche de 0 implique que l'effet du prédicteur est réduit.

- Covariables

- Le coefficient d'une covariable est exprimé dans les mêmes unités que la covariable. Le coefficient représente le changement dans la fonction de liaison pour une augmentation d'une unité de la covariable. Si le coefficient est négatif, plus la covariable augmente, plus la probabilité est faible. Si le coefficient est positif, plus la covariable augmente, plus la probabilité est élevée. Etant donné que les covariables ne sont pas codées et ne sont habituellement pas orthogonales par rapport aux facteurs, leur présence augmente généralement les valeurs des FIV. Pour plus d'informations, reportez-vous à la section sur les FIV.

- Blocs

- Les blocs sont des variables de catégorie auxquelles on applique un schéma de codage (−1, 0, +1). Chaque coefficient représente la différence entre la fonction de liaison pour le bloc et la valeur moyenne.

- PtCentr

- Le terme de point central est codé de la façon suivante : 1 pour le point central et 0 pour les autres points. En règle générale, vous n'interprétez pas le coefficient du terme PtCentr, car ce dernier représente autant d'effets quadratiques aliasés qu'il y a de facteurs dans le plan. Généralement, la valeur de p vous permet de déterminer s'il est intéressant de collecter des données supplémentaires afin d'estimer les effets quadratiques des facteurs.

Interprétation de la fonction de liaison logit

La fonction de liaison logit fournit l'interprétation la plus naturelle des coefficients estimés et constitue donc la liaison par défaut dans Minitab. L'interprétation utilise le fait que les probabilités de succès d'un événement de référence sont P(événement)/P(non-événement) et suppose que les autres prédicteurs restent constants. Plus le logarithme des probabilités de succès est important, plus l'événement de référence est probable. Ainsi, des coefficients positifs indiquent que la probabilité de l'événement augmente, tandis que des coefficients négatifs indiquent qu'elle diminue. Vous avez ci-après un résumé des règles d'interprétation pour les différents types de facteurs.

- Facteurs continus

- Le coefficient d'un facteur continu est la variation estimée du logarithme népérien des probabilités de succès pour l'événement de référence à chaque augmentation d'une unité codée du facteur. Par exemple, si chaque unité codée d'un facteur de durée représente un changement de 30 secondes et que le coefficient de la durée est 1,4, le logarithme népérien des probabilités de succès augmente de 1,4 lorsque vous augmentez la durée de 30 secondes.

- Facteurs de catégorie

- Pour un facteur à deux niveaux, l'interprétation du coefficient d'un facteur de catégorie peut porter sur l'écart entre les deux niveaux. Le coefficient d'un facteur de catégorie est la variation estimée du logarithme népérien des probabilités de succès de l'événement à chaque changement d'une unité codée. La différence entre le niveau supérieur et le niveau inférieur d'un facteur de catégorie est de 2 unités codées. Par exemple, une variable de catégorie a les niveaux Rapide et Lent. Lent est le niveau inférieur, codé -1. Rapide est le niveau supérieur, codé +1. Si le coefficient de la variable est de 1,3, alors, lorsque la variable passe de Lent à Rapide, le logarithme népérien des probabilités de succès de l'événement augmente de 2,6.

Coef ErT

L'erreur type du coefficient estime la variabilité entre les estimations des coefficients que vous obtiendriez si vous préleviez des échantillons dans la même population de façon répétée. Le calcul suppose que l'effectif d'échantillon et les coefficients à estimer restent identiques même après plusieurs échantillonnages.

Interprétation

Vous pouvez utiliser l'erreur type du coefficient pour mesurer la précision de l'estimation du coefficient. Plus l'erreur type est petite, plus l'estimation est précise.

Intervalle de confiance pour le coefficient (IC à 95 %)

Ces intervalles de confiance (IC) sont des étendues de valeurs ayant de fortes chances de contenir la véritable valeur du coefficient pour chaque terme du modèle.

Les échantillons étant aléatoires, il est peu probable que deux échantillons d'une population donnent des intervalles de confiance identiques. Cependant, si vous prenez de nombreux échantillons aléatoires, un certain pourcentage des intervalles de confiance obtenus contiendra le paramètre de population inconnu. Le pourcentage de ces intervalles de confiance contenant le paramètre est le niveau de confiance de l'intervalle.

- Estimation ponctuelle

- Cette valeur unique estime un paramètre de population à l'aide de vos données échantillons.

- Marge d'erreur

- La marge d'erreur définit la largeur de l'intervalle de confiance et dépend de l'étendue des probabilités d'événement, l'effectif d'échantillon et le niveau de confiance.

Interprétation

Un intervalle de confiance permet d'obtenir une estimation du coefficient de population pour chaque terme du modèle.

Par exemple, avec un niveau de confiance de 95 %, vous pouvez être sûr à 95 % que l'intervalle de confiance comprend la valeur ou le coefficient de la population. L'intervalle de confiance vous aide à évaluer la signification pratique de vos résultats. Utilisez vos connaissances spécialisées pour déterminer si l'intervalle de confiance comporte des valeurs ayant une signification pratique pour votre situation. Si l'intervalle est trop grand pour être utile, vous devez sans doute augmenter votre effectif d'échantillon.

Valeur de Z

La valeur de Z est une statistique pour les tests de Wald qui mesure le rapport entre le coefficient et son erreur type.

Interprétation

Minitab utilise la valeur de Z pour calculer la valeur de p, qui vous permet de déterminer si des termes sont significatifs et de choisir le modèle approprié. Le test de Wald s'avère précis lorsque l'effectif d'échantillon est assez important pour que la distribution des coefficients d'échantillons suive une loi normale.

Une valeur de Z suffisamment supérieure à 0 indique que l'estimation de coefficient est assez importante et précise pour être statistiquement différente de 0. Inversement, une valeur de Z proche de 0 indique que l'estimation de coefficient est trop petite ou imprécise pour que vous puissiez affirmer que le terme a un effet sur la réponse.

Les tests du tableau Somme des carrés d'écart sont des tests du rapport de vraisemblance. Les tests figurant dans l'affichage développé du tableau Coefficients sont des tests d'approximation de Wald. Les tests du rapport de vraisemblance sont plus exacts pour les petits échantillons que les tests d'approximation de Wald.

Valeur de p

La valeur de p est la probabilité qui mesure le degré de certitude avec lequel il est possible d'invalider l'hypothèse nulle. Des probabilités faibles permettent d'invalider l'hypothèse nulle avec plus de certitude.

Les tests du tableau Somme des carrés d'écart sont des tests du rapport de vraisemblance. Les tests figurant dans l'affichage développé du tableau Coefficients sont des tests d'approximation de Wald. Les tests du rapport de vraisemblance sont plus exacts pour les petits échantillons que les tests d'approximation de Wald.

Interprétation

Pour déterminer si un coefficient est statistiquement différent de 0, comparez la valeur de p du terme à votre seuil de signification afin d'évaluer l'hypothèse nulle. L'hypothèse nulle est que le coefficient est égal à 0, ce qui implique qu'il n'existe aucune association entre le terme et la réponse.

En général, un seuil de signification (noté alpha ou α) de 0,05 fonctionne bien. Un seuil de signification de 0,05 indique qu'il existe un risque de 5 % de conclure à tort que le coefficient n'est pas 0.

- Valeur de p ≤ α : l'association est statistiquement significative

- Si la valeur de p est inférieure ou égale au seuil de signification, vous pouvez conclure qu'il existe une association statistiquement significative entre la variable de réponse et le terme.

- Valeur de p > α : l'association n'est pas statistiquement significative

- Si la valeur de p est supérieure au seuil de signification, vous ne pouvez pas conclure qu'il existe une association statistiquement significative entre la variable de réponse et le terme. Il est sans doute nécessaire de réajuster le modèle sans le terme.

- Facteurs

- Si le coefficient d'un facteur est significatif, vous pouvez en conclure que la probabilité de l'événement n'est pas la même pour tous les niveaux du facteur.

- Interactions entre facteurs

- Si le coefficient d'une interaction est statistiquement significatif, vous pouvez en conclure que la relation entre un facteur et la réponse dépend des autres facteurs du terme.

- Covariables

- Si le coefficient d'une covariable est statistiquement significatif, vous pouvez en conclure que l'association entre la réponse et la covariable l'est aussi.

- Blocs

- Si le coefficient d'un bloc est statistiquement significatif, vous pouvez en conclure que la fonction de liaison du bloc est différente de la valeur moyenne.

- PtCentr

- Si le coefficient d'un point central est statistiquement significatif, vous pouvez en conclure qu'au moins un des facteurs a une relation courbe avec la réponse. Vous pouvez ajouter des points axiaux au plan afin de modéliser la courbure.

Interprétation de la fonction de liaison logit

La fonction de liaison logit fournit l'interprétation la plus naturelle des coefficients estimés et constitue donc la liaison par défaut dans Minitab. L'interprétation utilise le fait que les probabilités de succès d'un événement de référence sont P(événement)/P(non-événement) et suppose que les autres prédicteurs restent constants. Plus le logarithme des probabilités de succès est important, plus l'événement de référence est probable. Ainsi, des coefficients positifs indiquent que la probabilité de l'événement augmente, tandis que des coefficients négatifs indiquent qu'elle diminue. Vous avez ci-après un résumé des règles d'interprétation pour les différents types de facteurs.

- Facteurs continus

- Le coefficient d'un facteur continu est la variation estimée du logarithme népérien des probabilités de succès pour l'événement de référence à chaque augmentation d'une unité codée du facteur. Par exemple, si chaque unité codée d'un facteur de durée représente un changement de 30 secondes et que le coefficient de la durée est 1,4, le logarithme népérien des probabilités de succès augmente de 1,4 lorsque vous augmentez la durée de 30 secondes.

- Facteurs de catégorie

- L'interprétation d'un facteur de catégorie à deux niveaux peut porter sur l'écart entre les deux niveaux. Le coefficient d'un facteur de catégorie est la variation estimée du logarithme népérien des probabilités de succès de l'événement à chaque changement d'une unité codée. La différence entre le niveau supérieur et le niveau inférieur d'un facteur de catégorie est de 2 unités codées. Par exemple, une variable de catégorie a les niveaux Rapide et Lent. Lent est le niveau inférieur, codé -1. Rapide est le niveau supérieur, codé +1. Si le coefficient de la variable est de 1,3, alors, lorsque la variable passe de Lent à Rapide, le logarithme népérien des probabilités de succès de l'événement est multiplié par 2,6.

FIV

Le facteur d'inflation de la variance (FIV) indique dans quelle mesure la variance d'un coefficient est augmentée par les corrélations existant entre les prédicteurs du modèle.

Interprétation

Les FIV permettent de décrire l'importance de la multicolinéarité (la corrélation entre des prédicteurs) dans un modèle. Dans la plupart des plans factoriels, toutes les valeurs de FIV sont égales à 1, ce qui indique qu'il n'existe pas de multicolinéarité entre les prédicteurs. L'absence de multicolinéarité simplifie la détermination de la signification statistique. L'inclusion de covariables dans le modèle et l'occurrence d'essais ratés lors de la collecte de données sont deux situations courantes qui entraînent l'augmentation des FIV, ce qui complique l'interprétation de la signification statistique. En outre, pour les réponses binaires, les valeurs de FIV sont souvent supérieures à 1.

| FIV | Etat du prédicteur |

|---|---|

| FIV = 1 | non corrélés |

| 1 < FIV < 5 | modérément corrélés |

| FIV > 5 | hautement corrélés |

- Les coefficients peuvent ne pas sembler statistiquement significatifs, même lorsqu'il existe une relation importante entre le prédicteur et la réponse.

- Les coefficients de prédicteurs fortement corrélés varieront considérablement d'un échantillon à un autre.

- Lorsque des termes d'un modèle sont fortement corrélés, la suppression de l'un de ces termes aura une incidence considérable sur les coefficients estimés des autres. Les coefficients des termes fortement corrélés peuvent même changer la direction de l'effet.

En cas de multicolinéarité, faites preuve de prudence lorsque vous vous fondez sur la signification statistique pour choisir les termes à enlever d'un modèle. Les termes doivent être ajoutés ou retirés un par un. A chaque modification du modèle, étudiez les changements dans les statistiques récapitulatives du modèle et les tests de signification statistiques.