Sur ce thème

- Etape 1 : Evaluer visuellement la concordance des évaluateurs

- Etape 2 : Evaluer la cohérence des réponses de chaque évaluateur

- Etape 3 : Evaluer la justesse des réponses de chaque évaluateur

- Etape 4 : Evaluer la cohérence entre les réponses des évaluateurs

- Etape 5 : Evaluer la justesse des réponses de tous les évaluateurs

Etape 1 : Evaluer visuellement la concordance des évaluateurs

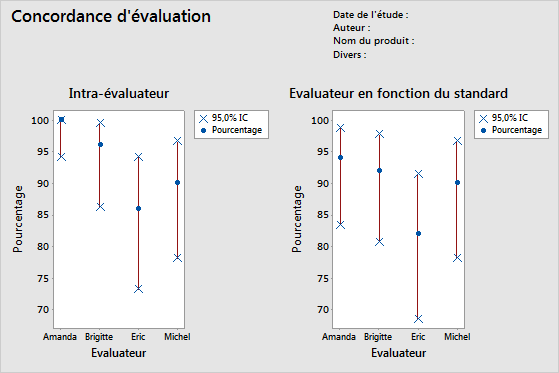

Pour déterminer la cohérence des notations de chaque évaluateur, évaluez le graphique Intra-évaluateur. Comparez le pourcentage de correspondances (cercle bleu) à l'intervalle de confiance pour le pourcentage de correspondance (ligne rouge) pour chaque évaluateur.

Pour déterminer la justesse des notations de chaque évaluateur, évaluez le graphique Evaluateur en fonction du standard. Comparez le pourcentage de correspondances (cercle bleu) à l'intervalle de confiance pour le pourcentage de correspondance (ligne rouge) pour chaque évaluateur.

Remarque

Minitab affiche le graphique Intra-évaluateur uniquement en présence de plusieurs essais.

Ce graphique intra-évaluateur indique qu'Amanda possède les notations les plus cohérentes et qu'Eric présente les notations les moins cohérentes. Ce graphique de l'évaluateur en fonction du standard indique qu'Amanda possède les notations les plus correctes et qu'Eric présente les notations les moins correctes.

Etape 2 : Evaluer la cohérence des réponses de chaque évaluateur

Pour déterminer la cohérence entre les notations de chaque évaluateur, évaluez les statistiques kappa dans le tableau Intra-évaluateur. Lorsque les évaluations sont ordinales, vous devez également évaluer les coefficients de concordance de Kendall. Minitab affiche le tableau Intra-évaluateur lorsque chaque évaluateur note plusieurs fois un élément.

Utilisez les statistiques kappa pour évaluer le degré de concordance des notations nominales ou ordinales réalisées par plusieurs évaluateurs lors de l'analyse des mêmes échantillons.

- Lorsque le kappa = 1, une concordance parfaite existe.

- Si le kappa a pour valeur 0, la concordance est la même que celle qui pourrait être attendue par seul hasard.

- Lorsque le kappa < 0, la concordance est plus faible que celle qui pourrait être attendue par hasard ; cela se produit rarement.

Selon la méthode AIAG, une valeur de kappa d'au moins 0,75 indique une concordance correcte. Toutefois, des valeurs plus élevées, comme 0,90, sont privilégiées.

Lorsque vous utilisez des notations ordinales, telles que les notations de la gravité d'un défaut sur une échelle allant de 1 à 5, les coefficients de Kendall, qui tiennent compte de l'ordre, constituent généralement des statistiques plus adaptées que la valeur du kappa seule pour déterminer l'association.

Remarque

Notez que le tableau Intra-évaluateur indique si les notations des évaluateurs sont cohérentes, mais pas si les notations concordent avec les valeurs de référence. Des notations cohérentes ne sont pas nécessairement des notations correctes.

Concordance d'évaluation

| Evaluateur | # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100,00 | (94,18; 100,00) |

| Brigitte | 50 | 48 | 96,00 | (86,29; 99,51) |

| Eric | 50 | 43 | 86,00 | (73,26; 94,18) |

| Michel | 50 | 45 | 90,00 | (78,19; 96,67) |

Statistiques kappa de Fleiss

| Evaluateur | Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 3 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 1,00000 | 0,071052 | 14,0741 | 0,0000 | |

| Brigitte | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,89605 | 0,141421 | 6,3360 | 0,0000 | |

| 3 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,94965 | 0,071401 | 13,3002 | 0,0000 | |

| Eric | 1 | 0,83060 | 0,141421 | 5,8733 | 0,0000 |

| 2 | 0,84000 | 0,141421 | 5,9397 | 0,0000 | |

| 3 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 4 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,82354 | 0,071591 | 11,5034 | 0,0000 | |

| Michel | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,83060 | 0,141421 | 5,8733 | 0,0000 | |

| 3 | 0,81917 | 0,141421 | 5,7924 | 0,0000 | |

| 4 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 5 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| Global | 0,87472 | 0,070945 | 12,3295 | 0,0000 |

Coefficient de concordance de Kendall

| Evaluateur | Coeff | Khi deux | DL | P |

|---|---|---|---|---|

| Amanda | 1,00000 | 98,0000 | 49 | 0,0000 |

| Brigitte | 0,99448 | 97,4587 | 49 | 0,0000 |

| Eric | 0,98446 | 96,4769 | 49 | 0,0001 |

| Michel | 0,98700 | 96,7256 | 49 | 0,0001 |

Résultats principaux : Kappa, coefficient de concordance de Kendall

De nombreuses valeurs de kappa sont égales à 1, ce qui indique une concordance parfaite entre les notations d'un évaluateur, d'un essai à l'autre. Certaines valeurs de kappa d'Eric sont proches de 0,70. Vous souhaiterez peut-être étudier l'origine de l'incohérence des notations de ces échantillons par Eric. Les données étant ordinales, Minitab propose le coefficient de concordance de Kendall. Ces valeurs sont toutes supérieures à 0,98, ce qui indique une très forte association avec les notations de l'évaluateur.

Etape 3 : Evaluer la justesse des réponses de chaque évaluateur

Pour déterminer la justesse des notations de chaque évaluateur, évaluez les statistiques kappa dans le tableau Chaque évaluateur en fonction du standard. Lorsque les notations sont ordinales, vous devez également évaluer les coefficients de corrélation de Kendall. Minitab affiche le tableau Chaque évaluateur en fonction du standard lorsque vous indiquez une valeur de référence pour chaque échantillon.

Utilisez les statistiques kappa pour évaluer le degré de concordance des notations nominales ou ordinales réalisées par plusieurs évaluateurs lors de l'analyse des mêmes échantillons.

- Lorsque le kappa = 1, une concordance parfaite existe.

- Si le kappa a pour valeur 0, la concordance est la même que celle qui pourrait être attendue par seul hasard.

- Lorsque le kappa < 0, la concordance est plus faible que celle qui pourrait être attendue par hasard ; cela se produit rarement.

Selon la méthode AIAG, une valeur de kappa d'au moins 0,75 indique une concordance correcte. Toutefois, des valeurs plus élevées, comme 0,90, sont privilégiées.

Lorsque vous utilisez des notations ordinales, telles que les notations de la gravité d'un défaut sur une échelle allant de 1 à 5, les coefficients de Kendall, qui tiennent compte de l'ordre, constituent généralement des statistiques plus adaptées que la valeur du kappa seule pour déterminer l'association.

Concordance d'évaluation

| Evaluateur | # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94,00 | (83,45; 98,75) |

| Brigitte | 50 | 46 | 92,00 | (80,77; 97,78) |

| Eric | 50 | 41 | 82,00 | (68,56; 91,42) |

| Michel | 50 | 45 | 90,00 | (78,19; 96,67) |

Statistiques kappa de Fleiss

| Evaluateur | Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83060 | 0,100000 | 8,3060 | 0,0000 | |

| 3 | 0,81917 | 0,100000 | 8,1917 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92476 | 0,050257 | 18,4006 | 0,0000 | |

| Brigitte | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83838 | 0,100000 | 8,3838 | 0,0000 | |

| 3 | 0,80725 | 0,100000 | 8,0725 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92462 | 0,050396 | 18,3473 | 0,0000 | |

| Eric | 1 | 0,91159 | 0,100000 | 9,1159 | 0,0000 |

| 2 | 0,81035 | 0,100000 | 8,1035 | 0,0000 | |

| 3 | 0,72619 | 0,100000 | 7,2619 | 0,0000 | |

| 4 | 0,84919 | 0,100000 | 8,4919 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,86163 | 0,050500 | 17,0622 | 0,0000 | |

| Michel | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,91694 | 0,100000 | 9,1694 | 0,0000 | |

| 3 | 0,90736 | 0,100000 | 9,0736 | 0,0000 | |

| 4 | 0,92913 | 0,100000 | 9,2913 | 0,0000 | |

| 5 | 0,93502 | 0,100000 | 9,3502 | 0,0000 | |

| Global | 0,93732 | 0,050211 | 18,6674 | 0,0000 |

Coefficient de corrélation de Kendall

| Evaluateur | Coeff | Coeff ErT | Z | P |

|---|---|---|---|---|

| Amanda | 0,967386 | 0,0690066 | 14,0128 | 0,0000 |

| Brigitte | 0,967835 | 0,0690066 | 14,0193 | 0,0000 |

| Eric | 0,951863 | 0,0690066 | 13,7879 | 0,0000 |

| Michel | 0,975168 | 0,0690066 | 14,1256 | 0,0000 |

Résultats principaux : Kappa, coefficient de corrélation de Kendall

La plupart des valeurs de kappa sont supérieures à 0,80, ce qui indique une concordance correcte entre chaque évaluateur et le standard. Peu de valeurs de kappa sont proches de 0,70, ce qui indique que vous pouvez être amené à étudier davantage certains échantillons ou certains évaluateurs. Les données étant ordinales, Minitab fournit les coefficients de corrélation de Kendall. Ces valeurs sont comprises entre 0,951863 et 0,975168, ce qui indique une forte association entre les notations et les valeurs standard.

Etape 4 : Evaluer la cohérence entre les réponses des évaluateurs

Pour déterminer la cohérence entre les notations des évaluateurs, évaluez les statistiques kappa dans le tableau Inter-évaluateurs. Lorsque les notations sont ordinales, vous devez également évaluer le coefficient de concordance de Kendall.

Utilisez les statistiques kappa pour évaluer le degré de concordance des notations nominales ou ordinales réalisées par plusieurs évaluateurs lors de l'analyse des mêmes échantillons.

- Lorsque le kappa = 1, une concordance parfaite existe.

- Si le kappa a pour valeur 0, la concordance est la même que celle qui pourrait être attendue par seul hasard.

- Lorsque le kappa < 0, la concordance est plus faible que celle qui pourrait être attendue par hasard ; cela se produit rarement.

Selon la méthode AIAG, une valeur de kappa d'au moins 0,75 indique une concordance correcte. Toutefois, des valeurs plus élevées, comme 0,90, sont privilégiées.

Lorsque vous utilisez des notations ordinales, telles que les notations de la gravité d'un défaut sur une échelle allant de 1 à 5, les coefficients de Kendall, qui tiennent compte de l'ordre, constituent généralement des statistiques plus adaptées que la valeur du kappa seule pour déterminer l'association.

Remarque

Notez que le tableau Inter-évaluateurs indique si les notations des évaluateurs sont cohérentes, mais pas si les notations concordent avec les valeurs de référence. Des notations cohérentes ne sont pas nécessairement des notations correctes.

Concordance d'évaluation

| # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Statistiques kappa de Fleiss

| Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|

| 1 | 0,954392 | 0,0267261 | 35,7101 | 0,0000 |

| 2 | 0,827694 | 0,0267261 | 30,9695 | 0,0000 |

| 3 | 0,772541 | 0,0267261 | 28,9058 | 0,0000 |

| 4 | 0,891127 | 0,0267261 | 33,3429 | 0,0000 |

| 5 | 0,968148 | 0,0267261 | 36,2248 | 0,0000 |

| Global | 0,881705 | 0,0134362 | 65,6218 | 0,0000 |

Coefficient de concordance de Kendall

| Coeff | Khi deux | DL | P |

|---|---|---|---|

| 0,976681 | 382,859 | 49 | 0,0000 |

Résultats principaux : Kappa, coefficient de concordance de Kendall

Toutes les valeurs de kappa sont supérieures à 0,77, ce qui indique une concordance à peine acceptable entre les évaluateurs. Les évaluateurs présentent une concordance maximale pour les échantillons 1 et 5, et une concordance minimale pour l'échantillon 3. Les données étant ordinales, Minitab propose le coefficient de concordance de Kendall (0,976681), qui indique une très forte association entre les notations des évaluateurs.

Etape 5 : Evaluer la justesse des réponses de tous les évaluateurs

Pour déterminer la justesse des notations de tous les évaluateurs, évaluez les statistiques kappa dans le tableau Tous les évaluateurs en fonction du standard. Lorsque les notations sont ordinales, vous devez également évaluer les coefficients de concordance de Kendall.

Utilisez les statistiques kappa pour évaluer le degré de concordance des notations nominales ou ordinales réalisées par plusieurs évaluateurs lors de l'analyse des mêmes échantillons.

- Lorsque le kappa = 1, une concordance parfaite existe.

- Si le kappa a pour valeur 0, la concordance est la même que celle qui pourrait être attendue par seul hasard.

- Lorsque le kappa < 0, la concordance est plus faible que celle qui pourrait être attendue par hasard ; cela se produit rarement.

Selon la méthode AIAG, une valeur de kappa d'au moins 0,75 indique une concordance correcte. Toutefois, des valeurs plus élevées, comme 0,90, sont privilégiées.

Lorsque vous utilisez des notations ordinales, telles que les notations de la gravité d'un défaut sur une échelle allant de 1 à 5, les coefficients de Kendall, qui tiennent compte de l'ordre, constituent généralement des statistiques plus adaptées que la valeur du kappa seule pour déterminer l'association.

Concordance d'évaluation

| # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Statistiques kappa de Fleiss

| Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|

| 1 | 0,977897 | 0,0500000 | 19,5579 | 0,0000 |

| 2 | 0,849068 | 0,0500000 | 16,9814 | 0,0000 |

| 3 | 0,814992 | 0,0500000 | 16,2998 | 0,0000 |

| 4 | 0,944580 | 0,0500000 | 18,8916 | 0,0000 |

| 5 | 0,983756 | 0,0500000 | 19,6751 | 0,0000 |

| Global | 0,912082 | 0,0251705 | 36,2362 | 0,0000 |

Coefficient de corrélation de Kendall

| Coeff | Coeff ErT | Z | P |

|---|---|---|---|

| 0,965563 | 0,0345033 | 27,9817 | 0,0000 |

Résultats principaux : Kappa, coefficient de concordance de Kendall

Ces résultats montrent qu'il existe une correspondance exacte entre les notations de tous les évaluateurs et les notations standard pour 37 des 50 échantillons. La valeur de kappa globale est de 0,912082, ce qui indique une forte concordance avec les valeurs standard. Les données étant ordinales, Minitab propose le coefficient de concordance de Kendall (0,965563), qui indique une forte association entre les notations et les valeurs standard.