Dans une entreprise d'impression textile, des évaluateurs évaluent la qualité d'impression de tissus en coton sur une échelle de 1 à 5. L'ingénieur qualité souhaite évaluer la cohérence et l'exactitude des notes des évaluateurs. Il demande à quatre évaluateurs d'examiner la qualité d'impression de 50 échantillons de tissu à deux reprises, dans un ordre aléatoire.

Etant donné que les données incluent une valeur standard connue pour chaque échantillon, l'ingénieur qualité peut évaluer la cohérence et l'exactitude des évaluations en les comparant à la fois à la valeur standard et aux notes attribuées par les autres évaluateurs.

- Ouvrez le fichier de données échantillons, QualitéImpressionTextile.MWX.

- Sélectionnez .

- Dans la zone Les données sont disposées en, sélectionnez Colonne d'attributs et saisissez Response.

- Dans la zone Echantillons, saisissez Echantillon.

- Dans la zone Evaluateurs, saisissez Contrôleur.

- Dans la zone Standard/attribut connu, saisissez Standard.

- Sélectionnez Les catégories des données d'attribut sont ordonnées.

- Cliquez sur OK.

Interprétation des résultats

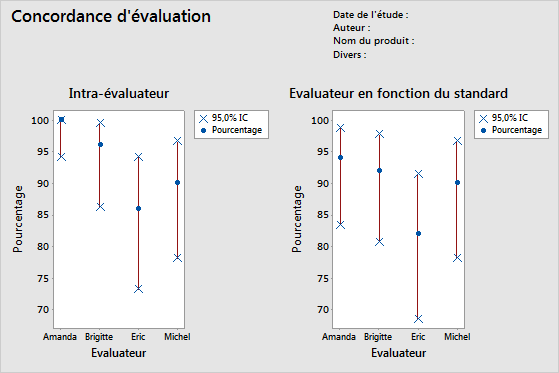

- Tableau Intra-évaluateur

- Chaque évaluateur effectuant au moins deux notations pour chaque échantillon, l'ingénieur peut évaluer la cohérence de chaque évaluateur.

- Tableau Chaque évaluateur en fonction du standard

- Comme il existe un standard connu pour chaque échantillon, l'ingénieur peut évaluer l'exactitude et la cohérence des notations de chaque évaluateur.

- Tableau Inter-évaluateurs

- Le tableau Inter-évaluateurs indique que les notations des évaluateurs concordent pour 37 échantillons sur 50.

- Tableau Tous les évaluateurs en fonction du standard

- Comme il existe un standard connu pour chaque échantillon, l'ingénieur peut évaluer l'exactitude des notations de tous les évaluateurs.

Remarque

La valeur de p de 0,0000 dans les résultats est arrondie. Toutefois, vous pouvez conclure en toute sécurité que la valeur de p est très faible et est inférieure à 0,00005.

Concordance d'évaluation

| Evaluateur | # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|---|

| Amanda | 50 | 50 | 100,00 | (94,18; 100,00) |

| Brigitte | 50 | 48 | 96,00 | (86,29; 99,51) |

| Eric | 50 | 43 | 86,00 | (73,26; 94,18) |

| Michel | 50 | 45 | 90,00 | (78,19; 96,67) |

Statistiques kappa de Fleiss

| Evaluateur | Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 3 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 1,00000 | 0,071052 | 14,0741 | 0,0000 | |

| Brigitte | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,89605 | 0,141421 | 6,3360 | 0,0000 | |

| 3 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 4 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,94965 | 0,071401 | 13,3002 | 0,0000 | |

| Eric | 1 | 0,83060 | 0,141421 | 5,8733 | 0,0000 |

| 2 | 0,84000 | 0,141421 | 5,9397 | 0,0000 | |

| 3 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 4 | 0,70238 | 0,141421 | 4,9666 | 0,0000 | |

| 5 | 1,00000 | 0,141421 | 7,0711 | 0,0000 | |

| Global | 0,82354 | 0,071591 | 11,5034 | 0,0000 | |

| Michel | 1 | 1,00000 | 0,141421 | 7,0711 | 0,0000 |

| 2 | 0,83060 | 0,141421 | 5,8733 | 0,0000 | |

| 3 | 0,81917 | 0,141421 | 5,7924 | 0,0000 | |

| 4 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| 5 | 0,86450 | 0,141421 | 6,1129 | 0,0000 | |

| Global | 0,87472 | 0,070945 | 12,3295 | 0,0000 |

Coefficient de concordance de Kendall

| Evaluateur | Coeff | Khi deux | DL | P |

|---|---|---|---|---|

| Amanda | 1,00000 | 98,0000 | 49 | 0,0000 |

| Brigitte | 0,99448 | 97,4587 | 49 | 0,0000 |

| Eric | 0,98446 | 96,4769 | 49 | 0,0001 |

| Michel | 0,98700 | 96,7256 | 49 | 0,0001 |

Concordance d'évaluation

| Evaluateur | # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|---|

| Amanda | 50 | 47 | 94,00 | (83,45; 98,75) |

| Brigitte | 50 | 46 | 92,00 | (80,77; 97,78) |

| Eric | 50 | 41 | 82,00 | (68,56; 91,42) |

| Michel | 50 | 45 | 90,00 | (78,19; 96,67) |

Statistiques kappa de Fleiss

| Evaluateur | Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|---|

| Amanda | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83060 | 0,100000 | 8,3060 | 0,0000 | |

| 3 | 0,81917 | 0,100000 | 8,1917 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92476 | 0,050257 | 18,4006 | 0,0000 | |

| Brigitte | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,83838 | 0,100000 | 8,3838 | 0,0000 | |

| 3 | 0,80725 | 0,100000 | 8,0725 | 0,0000 | |

| 4 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,92462 | 0,050396 | 18,3473 | 0,0000 | |

| Eric | 1 | 0,91159 | 0,100000 | 9,1159 | 0,0000 |

| 2 | 0,81035 | 0,100000 | 8,1035 | 0,0000 | |

| 3 | 0,72619 | 0,100000 | 7,2619 | 0,0000 | |

| 4 | 0,84919 | 0,100000 | 8,4919 | 0,0000 | |

| 5 | 1,00000 | 0,100000 | 10,0000 | 0,0000 | |

| Global | 0,86163 | 0,050500 | 17,0622 | 0,0000 | |

| Michel | 1 | 1,00000 | 0,100000 | 10,0000 | 0,0000 |

| 2 | 0,91694 | 0,100000 | 9,1694 | 0,0000 | |

| 3 | 0,90736 | 0,100000 | 9,0736 | 0,0000 | |

| 4 | 0,92913 | 0,100000 | 9,2913 | 0,0000 | |

| 5 | 0,93502 | 0,100000 | 9,3502 | 0,0000 | |

| Global | 0,93732 | 0,050211 | 18,6674 | 0,0000 |

Coefficient de corrélation de Kendall

| Evaluateur | Coeff | Coeff ErT | Z | P |

|---|---|---|---|---|

| Amanda | 0,967386 | 0,0690066 | 14,0128 | 0,0000 |

| Brigitte | 0,967835 | 0,0690066 | 14,0193 | 0,0000 |

| Eric | 0,951863 | 0,0690066 | 13,7879 | 0,0000 |

| Michel | 0,975168 | 0,0690066 | 14,1256 | 0,0000 |

Concordance d'évaluation

| # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Statistiques kappa de Fleiss

| Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|

| 1 | 0,954392 | 0,0267261 | 35,7101 | 0,0000 |

| 2 | 0,827694 | 0,0267261 | 30,9695 | 0,0000 |

| 3 | 0,772541 | 0,0267261 | 28,9058 | 0,0000 |

| 4 | 0,891127 | 0,0267261 | 33,3429 | 0,0000 |

| 5 | 0,968148 | 0,0267261 | 36,2248 | 0,0000 |

| Global | 0,881705 | 0,0134362 | 65,6218 | 0,0000 |

Coefficient de concordance de Kendall

| Coeff | Khi deux | DL | P |

|---|---|---|---|

| 0,976681 | 382,859 | 49 | 0,0000 |

Concordance d'évaluation

| # Inspectées | # Concordance | Pourcentage | IC à 95 % |

|---|---|---|---|

| 50 | 37 | 74,00 | (59,66; 85,37) |

Statistiques kappa de Fleiss

| Réponse | Kappa | Kappa ErT | Z | P (contre > 0) |

|---|---|---|---|---|

| 1 | 0,977897 | 0,0500000 | 19,5579 | 0,0000 |

| 2 | 0,849068 | 0,0500000 | 16,9814 | 0,0000 |

| 3 | 0,814992 | 0,0500000 | 16,2998 | 0,0000 |

| 4 | 0,944580 | 0,0500000 | 18,8916 | 0,0000 |

| 5 | 0,983756 | 0,0500000 | 19,6751 | 0,0000 |

| Global | 0,912082 | 0,0251705 | 36,2362 | 0,0000 |

Coefficient de corrélation de Kendall

| Coeff | Coeff ErT | Z | P |

|---|---|---|---|

| 0,965563 | 0,0345033 | 27,9817 | 0,0000 |